Ensemble

前面说dropout是一种ensemble,现在来讲讲ensemble。

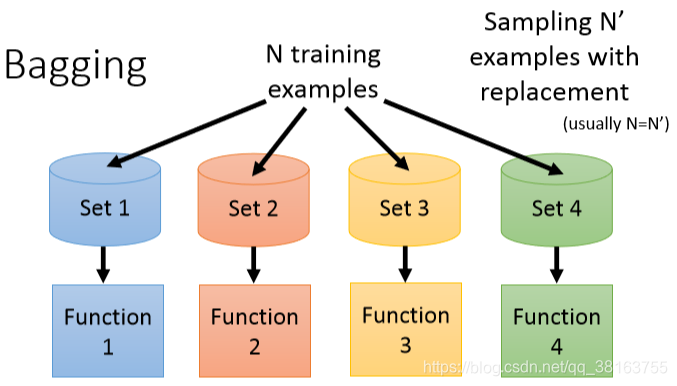

Bagging

复杂的模型会有较大的variance,这个方法对容易overfit的复杂模型有帮助。

data set大小为n,有放回的随机抽n’次,即使n’=n,data set也不一定完全一样,因为有可能会重复抽到同一个

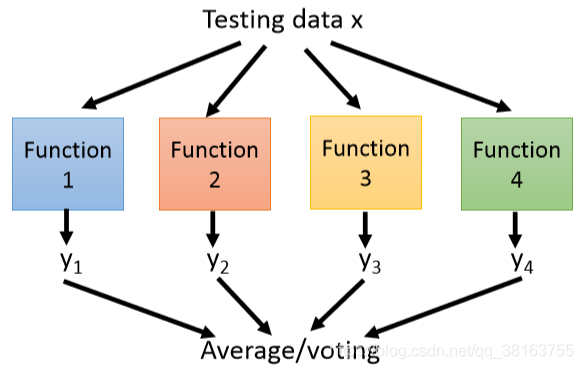

最后将所有function的结果取平均,或者按出现次数最多的输出。

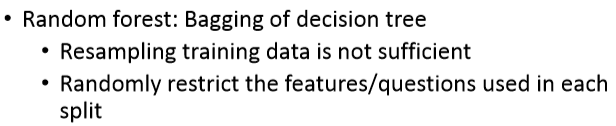

单纯的resample不一定高效,应该加一些限制使得每个function都有所不同。

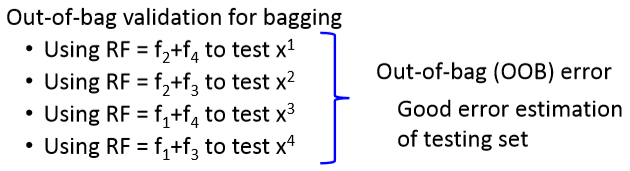

一种validation的方法。

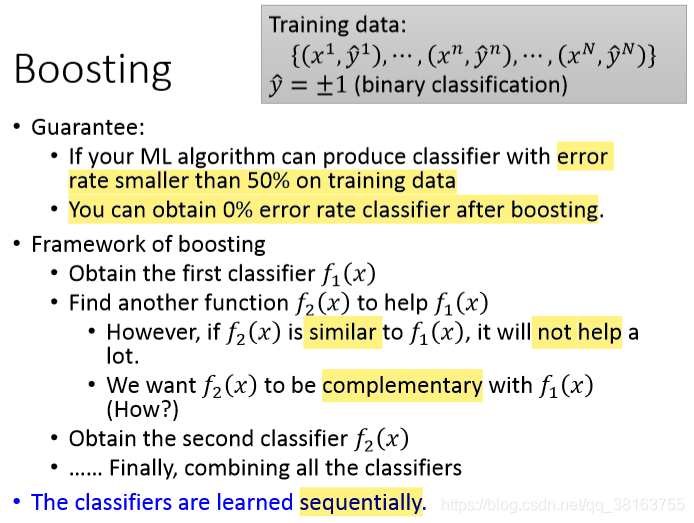

Boosting

Improving Weak Classifiers

以下均以+1-1的二元分类为例。

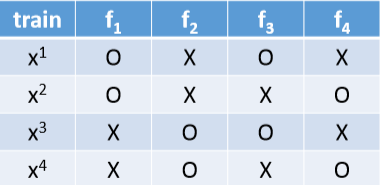

classifier是挨个train的,保证他们之间不相似,而是互补。

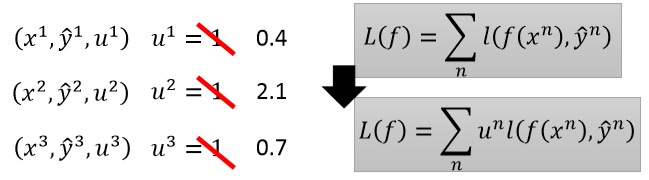

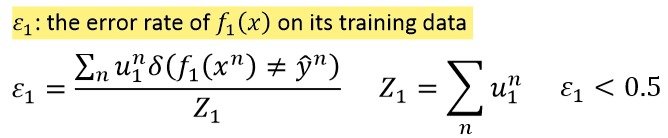

给每笔data加上weight,更改cost function,然后只要data的weight变了,train出来的function就不会相似。

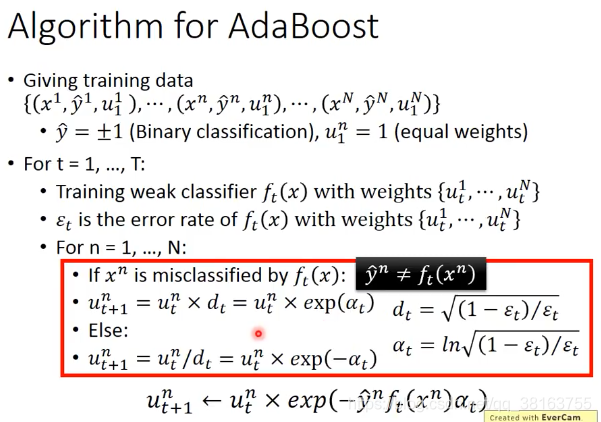

Adaboost的思想是training ?? (?) on the new training set that fails ?? (?)。上面的例子基于+1-1的二分类,所以u的更新可以统一写成那个样子。

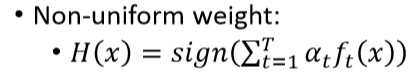

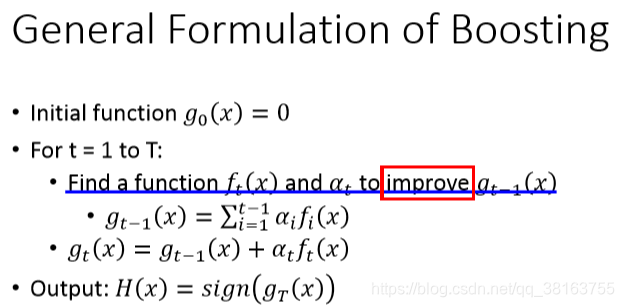

通过这种方式合起来,α的计算上面有。因为输出是正负1,所以用sign。As we have more and more ?? (T increases), ? (?) achieves smaller and smaller error rate on training data.

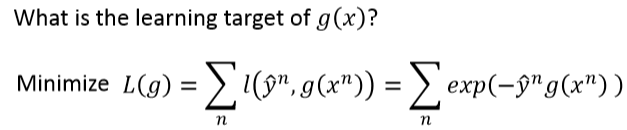

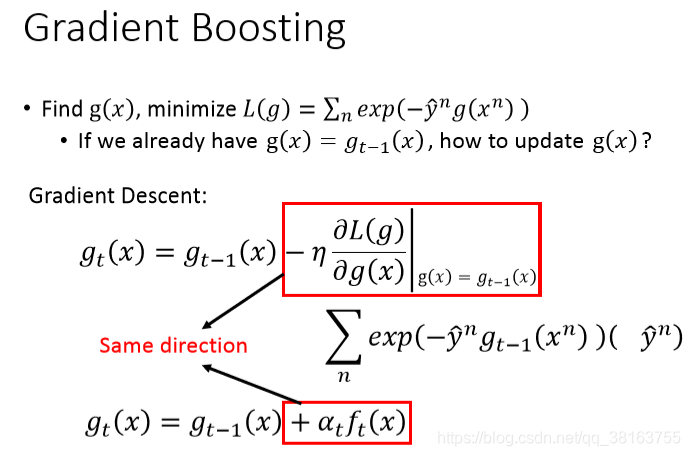

gradient boosting就是adaboosting,给出的思想就是可以任意定义loss function,reweight的公式不用变。要保证错误率小于0.5,如果没有达到,可以更改输出层,反过来。

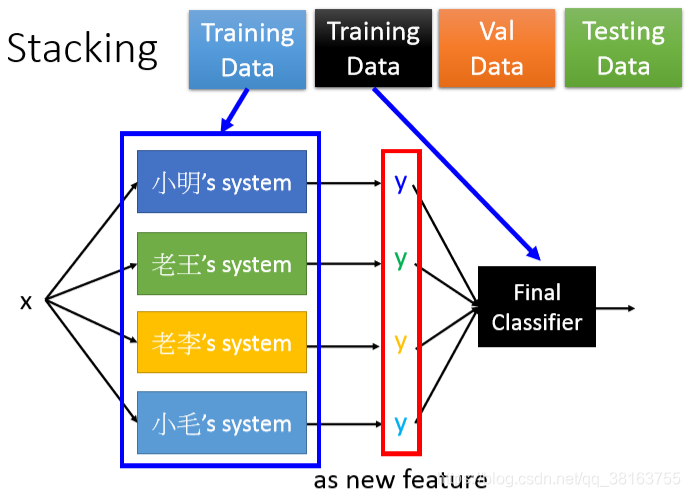

Stacking

作进一步的提升

用来train这些function的与train Final classifier应该是不同的training data。Final classifier可以是个简单的logistic regression