2021-01-25 23:02:40

作者 | 陈大鑫、青暮

当今世界人工智能领域,有三位AI学者被业内奉为“神一样的存在”,其中两位来自加拿大,一位来自法国。

他们就是2018年的图灵奖得主Geoffrey Hinton、Yoshua Bengio,以及我们今天要着重介绍的Yann LeCun(以下简称“LeCun”)——纽约大学终身教授、纽约大学数据科学中心的创始人、Facebook人工智能研究院首席科学家。

LeCun是法国学术界非常引以为豪的科学家,也是在美国科技巨头公司中担任要职的为数不多的法国人。虽然同为“极客”,但法国人独特的气质让LeCun和很多美国科学家相比,看起来更加随意、富有亲和力。

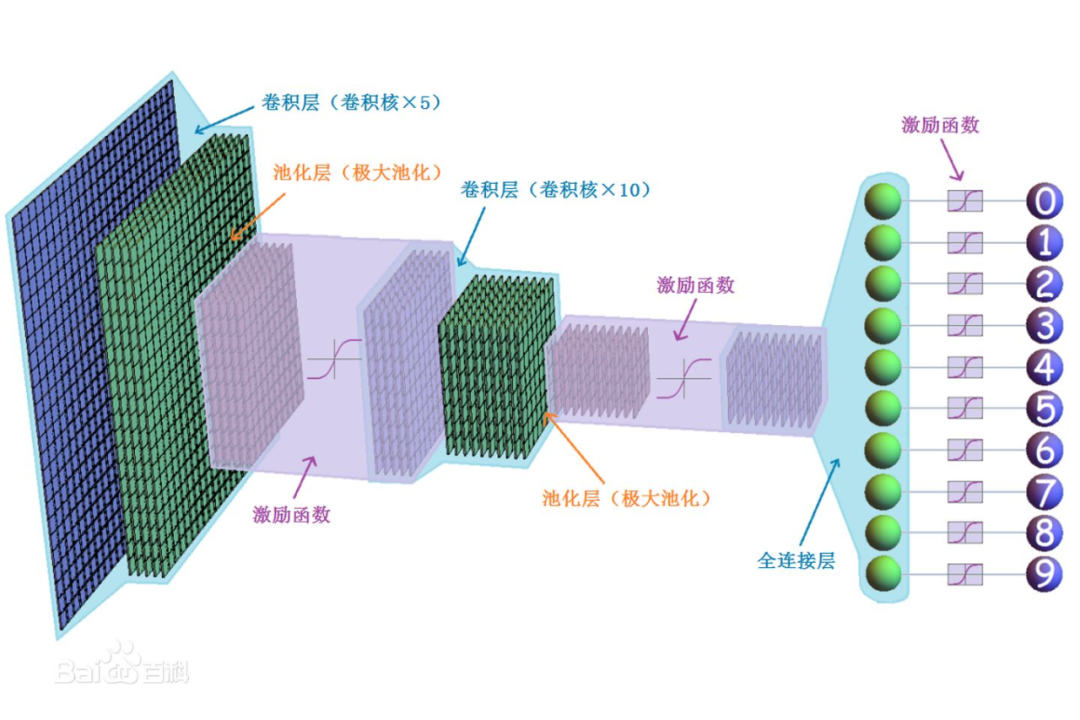

他所开发的手写数字辨识模型LeNet,不但是反向传播算法的首次被实践,也证实了Hinton的想法是可行的,更是计算机视觉中常见的卷积神经网络原型。

在这篇文章中,AI科技评论将带大家回顾LeCun的一路走来的六十年。

1 从“2001太空漫游”到单板机

LeCun全名为Yann André Le Cun,他于1960年7月8日出生于法国巴黎西北边的一个小镇上。而Yann LeCun这个名字的由来,则是因为他考虑到自己的发展重心是美国和加拿大,为避免英语使用者将自己的姓氏“Le Cun”中的“Le”误认为是中间名,于是将“Le Cun”改写为“LeCun”。此外,他的中文译名来源也有一个有趣的小故事。Yann LeCun的中文译名原为扬·勒丘恩,而华人AI圈一直亲切地称他为“杨乐康”,据说Yann LeCun听闻后,干脆自己给自己取了中文名字——“杨立昆”。

LeCun的父亲是航空机械工程师,母亲是家庭主妇,他还有一位从小一起长大的哥哥。在父亲的影响下,LeCun小时候就对科学和工程非常感兴趣,建造飞机模型和电子玩具是他和哥哥的重要童年回忆。LeCun第一次见识到“有智能”的机器,来自在9岁那年偶然看到的电影“2001太空漫游”,这部电影在他心中埋下了好奇的种子。

身为一个太空迷,LeCun还仿照星球大战中的纳布皇家巡洋舰制作过一个模型。

LeCun拥有的第一部电脑,是在17岁那年买的一台单板机。这台单板机的构造非常简单,除了一个小小的键盘,就是一个只能显示六位数字的屏幕,这似乎和计算器的构造差不多。然而它的使用复杂得多,必须自己编程,而重量更是达到了四公斤。学理科的人一般对音乐的理解能力较高,LeCun也不例外。他喜欢文艺复兴音乐和爵士乐,还能吹奏双簧管、长笛等多种古典乐器。两种兴趣的碰撞让他催生了用单板机打造“管乐合成器”(wind synthesizer)的想法,并付诸实施。这种“寓学于乐”的操作,让他在玩音乐的同时,也快速地学习了很多编程技能。

2两本启蒙书

LeCun大学就读于巴黎高等电子与电气工程师学校,学习电机工程专业,并在1983年获得工程师学位。除了学习应用数学与物理学,他还对神经科学感兴趣。在这段时期内,LeCun就开始读可学习机器方面的各种文献,并尝试做了一些简单的项目,这些项目在今天看来也能归入人工智能领域。然而,直到他读到了两本书,才坚定了自己的兴趣和未来研究方向。

这两本书的其中一本名为《语言与学习》(Language and Learning),这本书是LeCun在大二时无意间翻到的,这本书通过发展心理学家让·皮亚杰与语言学泰斗乔姆斯基之间的辩论,来探讨语言的本质:语言是后天学习的能力,还是与生俱来的天赋?书中关于“学习机器”(learning machine)的讨论更是让LeCun心醉神往。

另一本名为《感知器:计算几何学概论》(Perceptrons: an introduction to computational geometry),由人工智能先驱马文·明斯基和Seymour Papert所著。

LeCun在这本书里第一次接触到了“感知器”(perceptron)的概念,他心中涌现出一股冲动,就是打造一台“可学习”的机器。然而,这本书也指出,单层神经网络感知器的应用是有限的,这种结合神经科学与计算机科学的方法论在当时的学术界基本被人所遗忘。

LeCun于是乎疯狂地游窜于各个大学的图书馆,寻找一切关于感知器的内容加以深入学习研究。

在此之后,LeCun除了想打造“可学习的机器”,也希望这种方法论在AI领域内得到复兴。

在1983年,LeCun发现在法国有一群人在研究Automata(自动机)。那时候计算机科学还没有任何人在研究神经网络,甚至连简单的机器学习都没有。LeCun当时遇到了一些人,他们在思考很多简单的单元互相连接起来形成的网络会有哪些新的性质。实际上,这就是神经网络。LeCun和他们取得联系以后,发现他们有一个全球性的研究社区。

之后,LeCun读了 John Hopfield 写的 Hopfield 网络的论文,也听说了 Geoffrey Hinton 和 Terry Sejnowski 这两个人,他们那时候刚刚发表了一篇关于玻尔兹曼机的论文。LeCun觉得那篇论文写的非常好,并期待能见到他们。

3与Hinton、Bengio相遇

LeCun在巴黎第六大学就读博士,并在1987年获得计算机科学博士学位。LeCun的导师对神经网络一无所知,他对LeCun说:“我可以给你的论文签字,你似乎挺聪明的,但是从技术角度讲我确实没办法帮助你。”

在这段期间内,LeCun提出了多层神经网络以及反向传播算法学习算法的原型,突破了单层神经网络感知器的限制。

现代人工神经网络复兴的起点,发生在1986年的夏天。尽管有了原型,但是当时LeCun的模型中的矩阵乘法运算速度非常慢,这样的实验效果不足为外人道也。在这一年,和Geoffrey Hinton的相遇使得希望显现,LeCun惊喜地发现Hinton也在研究反向传播算法。

知音相遇,一拍即合,他们后来一起发展出了更加完善的反向传播算法。

1987年,刚刚获得博士学位的LeCun正值27岁,这时他已经让人工智能学界重拾对神经网络的信心。他离开法国飞到了加拿大,在Hinton的指导下开启多伦多大学的博士后研究生涯。

在这一年的冬天,蒙特利尔举行了一场学术演讲,LeCun在台下听到一位年轻人不断提出聪明的问题。他好奇地走近了那位年轻人,结识了另一位未来的极为重要的伙伴——Yoshua Bengio。

3 LeNet的诞生Net的诞生

1980年代末,LeCun和Bengio以及其他组员,来到了当时美国电信巨头AT&T所属的实验室──AT&T贝尔实验室。这座美国最大的业界研究机构,培育了数不清的精英人才,许多发明至今依然影响深远。

LeCun与他的研究团队很快就将反向传播算法应用在卷积神经网路上。这种进阶版的人工神经网路,可以自动寻找数据中的模式和表征,于是就可以应用在图像与文字的识别上。

1993年,时年32岁的LeCun便是在这样的基础上,开发出了世界上第一个用于文本数字识别的卷积网络──LeNet。

图注:32年前Yann LeCun当初演示用CNN识别数字的视频,视频中,参与这项实验的研究人员还有实验室负责人Rich Howard,和计算机专家Donnie Henderson。

在演示视频中,系统快速且精准地识别出了手写数字210-949-4038。据说,这是LeCun当时在贝尔实验室的电话号码。

LeNet后来成功商业化,被金融和邮政机构拿来读取信件或支票上的数字与条码,这不仅是LeCun在业界赚到的第一桶金,也证明了他当初与导师Hinton一同钻研的基于反向传播算法的卷积神经网路是可行的。

图注:Lenet-5 在线识别手写数字

然而好景不常,对于神经网络报以厚望的人们变得“贪婪”起来,人们不再满足于简单的手写数字的辨认,而是更复杂、多样的图像,可是这也意味着需要更多、更深的网络隐藏层,这带来的计算量远远超出当时计算硬件设备的上限。

期望越大失望越大,资本和市场很快对之失去了耐心,神经网路再次被打入冷宫。与此同时,AT&T为了与其他电信公司竞争,专注于通讯服务的经营,于是公司原先的实验室被一分为二,成为「贝尔实验室」与「AT&T实验室」两个不同公司下的研究部门。L

eCun虽然可以留在AT&T实验室继续他的研究,但是许多其他相关领域的朋友,例如当初协助将LeNet拓展到金融服务业的工程人员,都被拆散到了另一个实验室,这使得所有相关研究计划被迫暂停。

LeCun也因此有整整六年时间没有再碰神经网路。这段时间也被后人称为「人工智能的第二次寒冬」,LeCun在这段时间收拾心情,重整他之前写到一半的论文,并与其他组员研发出新的图片压缩技术──DjVu。

DjVu的特点在于能将图像中重复度高的形状独立出来,当再次出现时只要需记录位置信息即可,因此可以有效压缩高清晰度影像,这也是DjVu一名取自法语déja vu(似曾相识)的原因。在当时很多艺术与文化的资料,例如全彩杂志内页的扫描,若以djvu的格式储存,相较于传统的jpeg或pdf格式,大小可以缩减到五倍以上。

所幸随着摩尔定律的生效,计算硬件设备的性能也逐年递增,特别是近几年来GPU在很多科学计算上逐渐崭露头角。很多研究者发现GPU对于可高度并行化的简单任务(例如卷积操作),有着取代CPU的巨大潜力。自此之后,神经网路凭借着与GPU结合,渐渐走出低谷。

近些年,卷积神经网络(CNN)已经成为众多科学领域的研究热点之一。特别是在计算机视觉领域,由于CNN避免了对图像的复杂前期预处理,可以直接输入原始图像进行操作,这让其得到了更为广泛的应用,这种革命性的系统从一开始能够识别手写数字,随着算力的不断发展和训练数据的不断丰富,CNN从高清图像中识别视觉出如猫和狗早已不在话下。

CNN后来在计算机视觉领域可谓是大杀四方,ImageNet竞赛一晃十载,历年来霸榜的神经网络模型如AlexNet、Inception、ResNet等等无一不是以CNN为基础架构。

而最近一年多来Transformer模型的出现以及在视觉模型上的成功应用似乎对CNN的垄断地位构成了严峻的挑战,至于是哪个模型能笑到最后,还需更多的时间来检验。

4产学两栖

2002年,LeCun离开了AT&T实验室,带着组员来到日本电气公司(Nippon Electric Company,NEC)位于美国普林斯顿的研究中心。

无奈当时NEC研究中心正值转型期,很多LeCun想合作的研究人员都相继出走;一年半的短暂停留后,LeCun转战来到了纽约大学,时至今日仍未离开。

LeCun先后与其他学者在纽约大学成立了数据科学中心,并担任共同主任;2013年,数据科学中心被Facebook看上,LeCun获聘担任其下AI研究部门Facebook AI的主任。今日Facebook与Instagram上的人脸识别与自动标注功能,很大一部分是LeCun与其团队的研究成果。

Facebook产品中的AI背后的许多基础研究现在都在FAIR进行。它最有影响力的创意之一是记忆网络,它可以存储足够的数据来回答常识性问题,从而改善机器与人们的交谈方式。此外,LeCun还将开放研究作为其计划的基石。现在,FAIR几乎公开了其所有工作,并开放了其大部分代码、数据集和工具的资源,例如经典机器学习框架PyTorch,从而促进工业界和学术界的交流。

正因为如此,LeCun一直在积极倡导在产学合作制度──让从事科学研究的学者一部分时间待在业界、另一部分时间在大学任教──引进商业界的资源与运营模式,使AI的发展在学界和业界互通有无。他曾经专门写过一篇文章,提出了“双重联盟”(dual-affiliation)的概念,来阐述这种模式的好处。

虽说这样「产学两栖」的学者不在少数,然而树大难免招风。LeCun的这个举动引起了纽约大学其他同僚的非议,认为这会让一名教授投注在教学上的时间与精力大大减少。

LeCun觉得很多人都误解了双重联盟的非常重要的一点,就是:只有一个工业界实验室是研究性质的实验室,而不是开发性质的实验室,以及这个实验室做的是开放性的研究,设立这个实验室的企业对实验室的知识产权没有很强的占有欲的时候,这种双重联盟的模式才是可行的。

LeCun在产学合作制度基础上还主张研究成果的开放,让更多人了解自己正在从事的研究。

他表示:“要和大学实验室保持良好关系,让他们为你输送各类人才,进行各种可能的研究,这就必须要开放项目和研究成果。科研人员公开发表自己的研究成果是非常重要的,因为你的地位在于学术影响。你不能简单地告诉人们‘我正在为Facebook工作,但我不能告诉你们我在研究什么’,这样你的职业生涯就毁了,这真的很重要。”

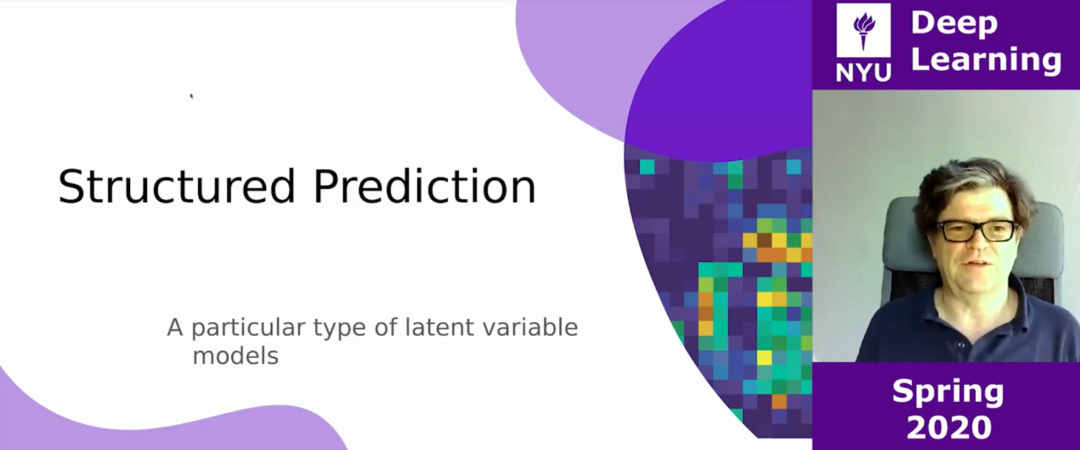

2020年,LeCun有一个主讲的纽约大学《深度学习》课程,后来因为疫情原因,LeCun在网上也有坚持亲自授课。

而在人工智能的商业化方面,LeCun则表示:“基础研究的影响在比较长的时间后才能体现出来。你不能幻想种下一颗种子,然后就突然冒出了实体产品线,商业模式就能发生彻底改变。这是一种长期投资,它需要的是有远见的人,这样的人谷歌有,Facebook也有。”

2018年,LeCun与Hinton和Bengio三人共同获得了有「计算机科学界的诺贝尔奖」之称的图灵奖。

ACM 表示,Yann LeCun 主要做出了三大贡献:提出卷积神经网络、改进反向传播算法、拓宽神经网络视角。

除了是对研究的肯定,这个奖项更为Hinton、LeCun与Bengio三人之间,这段亦师亦友的感情做了最好的注解。

获得图灵奖后,LeCun却似乎不满足于此,他的研究脚步仍未停下。

4学术之道&人生之道

LeCun曾表示,人工智能发展的一大难题是让机器掌握人类常识,这是让机器和人类自然互动的关键。关于机器视觉如何与常识相联系,LeCun说,有很多种看法。其中一种观点认为,给人工智能系统提供足够信息的唯一方式是加入视觉认知,因为影像会比语言的信息密度高得多。

对此,LeCun表示:“这跟婴儿的学习方式类似。然而,幼儿在学习很多事情的时候并不需要明确的指示。”LeCun认为在没有指导的过程中的学习才是他想要达到的。

近年来,人们越来越担心,如果AI无法如期实现当前人们的期望乃至通用人工智能(AGI),那么另一个冬天将很快到来。LeCun并不认同通用人工智能的说法,他曾说道,“没有像AGI这样的东西”,因为“人类的智能还远未达到通用水平。” 但是,他热衷于追求“人类级AI”。

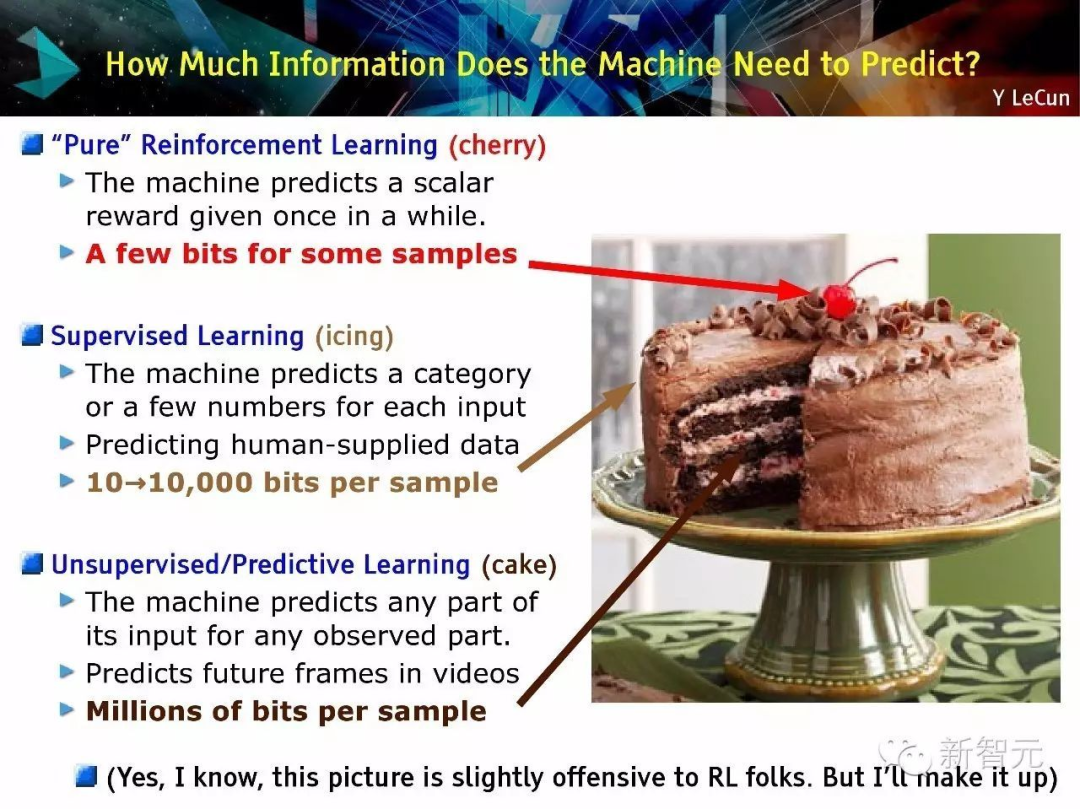

LeCun曾打过一个比方:「人类与动物的学习大都是无监督学习。所以说如果智能是一块蛋糕,那么无监督学习才是蛋糕本体,监督学习则是那层糖霜,强化学习不过是蛋糕上的一颗樱桃。」

监督学习所训练出来的模型,通常只有在特定目标、特定范围内才有不错的效果效,但这与人类举一反三、鉴古知今的学习方法有很大的区别。

LeCun曾说过在你退休之前最想做出来的成果,是找到一个普遍适用的好方法来做自监督学习。不难看出对于LeCun而言,我们距离真正的「智能」还有很长一段路要走。

我认为,一旦突破了那堵砖墙,我们将在AI系统功能开发上取得重大进步。但事实是,它后面可能会还有一堵砖墙。我们现在不知道,是因为它隐藏起来了。因此,我们不知道要达到老鼠级别的智能、猫级别的智能、人类级别的智能,还需要经过多少堵砖墙。我们甚至不知道要花多长时间才能突破第一堵墙。

在被问及成功秘诀时,LeCun则认为,自己并不是天才,但与天才的相遇让他受益匪浅。

我的秘诀是钻到一群比我聪明的人里面去,所以在很多方面我都根本没觉得自己有什么天赋。反倒是,我经常为别人感到惊叹。比如我和 Léon Bottou 有过很长时间的联系和合作,在机器学习界他是一个知名人物,而且几乎每个方面他都比我强!

我喜欢做的事,就是一直向下挖掘,去发现一个疑问背后真正的问题是什么。「如何才能让机器学习」,类似这种。有点像是考虑大方向、考虑哪些是真正重要的问题。把问题简化、再简化,直到达到真正的核心问题。

有时候一个想法或者一个概念显得很复杂,因为其中用到了很多很麻烦的数学知识,但是它真正的核心往往就是一个很简单的想法。我觉得我还没法和 Richard Feynman 相提并论,但是这种思考方式真的和他的很像。就是要问最基本的问题、摒弃一切表面上的东西,直到得到一个简单得不可思议的问题。不过我做得还没有他那么好。

当然,也有些人觉得自己成功的秘诀在于专注,比如Yoshua Bengio,Yoshua 是非常自律的、井井有条的人。我不是那样的人,我活得乱糟糟的。

最后值得一提的是,不同于Hinton和Bengio,LeCun比较热衷于在推特上活跃发言,目前在推特上有24万的粉丝,妥妥的大V。当然,LeCun在推特上也有过不愉快的一段往事,曾经一度退出推特......

参考链接:

https://www.yicai.com/news/5272525.html

https://www.leiphone.com/news/201811/62TcDCKFomfCEWnQ.html