大数据学习笔记

1.HDFS启动

根目录下

sbin/start-dfs.sh

查看启动

jps

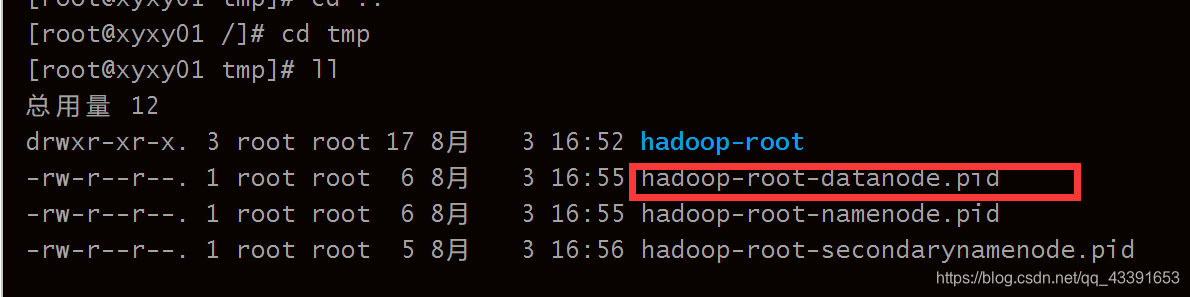

2.SecondaryNameNode没有启动

启动成功会显示

NameNode

DataNode

SecondaryNameNode

jps

没有启动成功可以 进入 tmp文件删除相关临时文件

3.配置文件

vi /etc/profile 编辑配置文件

source /etc/profile 使更改的配置立即生效

4.安装Spark

上传安装包

下载好后解压至/usr/local/

tar zxvf ~/Downloads/spark-2.4.4-bin-hadoop2.7.tgz -C /usr/local

删除安装包:

rm -rf spark-2.4.4-bin-hadoop2.7.tgz

进入到解压目录并重命名

cd /usr/local/

mv spark-2.4.4-bin-hadoop2.7 spark

配置环境

sudo vim /etc/profile

查看是否安装成功

进入spark文件

jps

5.linux 发现交换文件 “.swp”

解决方案 链接

6.bash: ls: 未找到命令

刚刚修改完PATH之后,发现ls不能用了、ll、vi、vim都不能用了。

原因是:

环境变量PATH被修改了,是刚刚的修改影响了PATH

解决方法 :

方法一、格式化一下 bin/hdfs namenode -format

方法二、执行 export PATH=/bin:/usr/bin:$PATH

执行 NameNode 的格式化:

hadoop@hadoop:/usr/local/hadoop$ ./bin/hdfs namenode -format

启 NameNode 和 DataNode 守护进程。

hadoop@hadoop:/usr/local/hadoop$ ./sbin/start-dfs.sh

7.网络Ping不通

重启网络服务:service network restart

8.查找文件

find / -name mongodb.log

9.快速查找jdk位置

echo $JAVA_HOME

10.判断flume是否安装成功

fl

11.安装文件

yum install -y 文件名

12.系统容量扩增

Linux增加LV(逻辑卷)容量

系统容量扩增

查看磁盘容量 df -h

13.查看运行进程

ps -ef | grep

15.关闭防火墙

systemctl stop firewalld(本次服务关闭防火墙)

systemctl disable firewalld(永久禁用防火墙)

16.HDFS的web访问

Hadoop3.0之前的访问端口是50070

Hadoop3.0之后的访问端口是9870

17.设置密码登录

ssh-keygen

18.修改ip地址

vim /etc/sysconfig/network-scripts/ifcfg-enp0s3

19.修改用户名

hostnamectl set-hostname xyxy02

20.hadoop 2.x 集群搭建

21.配置秘钥

密钥生成:ssh-keygen -t rsa

密钥拷贝:ssh-copy-id servername

22.分发各个节点

进入zookeeper-3.4.6目录

scp -r zookeeper-3.4.6/ xyxy12:/usr/tools

scp -r zookeeper-3.4.6/ xyxy13:/usr/tools

23.杀死进程

常用:kill -9 pid

24、ha同步元数据

namenode无法启动

./hdfs namenode -bootstrapStandby #同步元数据

25.启动zookeep

zkServer.sh start

26.启动namenode

hadoop-daemon.sh start namenode

27.创建文件夹

hdfs dfs -mkdir -p /lyc/xc/

28.上传文件到web端

hdfs dfs -put /usr/tools/hadoop-2.6.5/etc/hadoop/core-site.xml /lyc/xc/

29.删除文件夹

hdfs dfs -rm -rf -R /usr/

30.查看文件

hdfs dfs -text /lyc/xc/core-site.xml

31.一键启动zookeeper脚本文件

zookeeper一键启动脚本文件

创建.sh文件 例如:zkStart.sh vi编辑

#判断用户是否传参

if [ $# -ne 1 ];then

echo "无效参数,用法为: $0 {start|stop|restart|status}"

exit

fi

#获取用户输入的命令

cmd=$1

#定义函数功能

function zookeeperManger(){

case $cmd in

start)

echo "启动服务"

remoteExecution start

;;

stop)

echo "停止服务"

remoteExecution stop

;;

restart)

echo "重启服务"

remoteExecution restart

;;

status)

echo "查看状态"

remoteExecution status

;;

*)

echo "无效参数,用法为: $0 {start|stop|restart|status}"

;;

esac

}

#定义执行的命令

function remoteExecution(){

for (( i=129 ; i<=131 ; i++ )) ;

do

tput setaf 2

echo ========== hadoop${i} zkServer.sh $1 ================

tput setaf 9

ssh xyxy${i} "source /etc/profile ; /opt/module/zookeeper-3.4.10/bin/zkServer.sh $1"

done

}

#调用函数

zookeeperManger

创建好后直接启动

zkStart.sh start (启动脚本)

32.设置权限

chmod -R 777 ./* (本目录下的所有文件)

33.启动zkfc

hadoop-daemon.sh start zkfc

34.格式化zookeeper

hdfs zkfc -formatZK

35.启动yarn nodemanager resourmanager

yarn-daemon.sh start nodemanager

yarn-daemon.sh start resourmanagers

36.强制转化为active

hdfs haadmin -transition ToActive nn1

37.查询hdfs文件计算结果

hdfs dfs -text /user/root/data/1/par*

38.提交一个 data.txt 到hdfs上 进行计算 wordcount

hdfs里面创建

/input/

/user/root/data/output

hadoop jar /usr/tools/hadoop-2.6.5/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.5.jar

wordcount /input/data.txt /user/root/data/output/1

39.分布式文件系统HDFS

HDFS是hadoop项目的核心子项目

主要负责集群数据的存储与读取

HDFS文件系统主要包括一个NameNode一个Secondary NameNode 和多个DateNode

NameNode、Secondary NameNode 运行在Master

DateNode 运行在Slave

40.分布式计算框架mapreduce

MapReduce是Hadoop核心计算框架,适用于大规模数据集(大于1TB)并行运算的编程模型

Map(映射)和Reduce(规约)两部分

当启动一个 MapReduce 任务时,Map 端会读取 HDFS 上的数据,将数据映射成所需要的键值对类型并传到 Reduce 端。Reduce 端接收 Map 端传过来的键值对类型的数据,根据不同键进行分组,对每一组键相同的数据进行处理,得到新的键值对并输出到 HDFS,这就是 MapReduce 的核心思想。

41.集群资源管理器–YARN

YARN主要包含三大模块:

Resource Manager(RM)、Node Manager(NM)、application Master(AM)

Resource Manager负责所有资源的监控、分配和管理

application Master负责每一个应用程序的调度和协调

Node Manager 负责每一个节点的