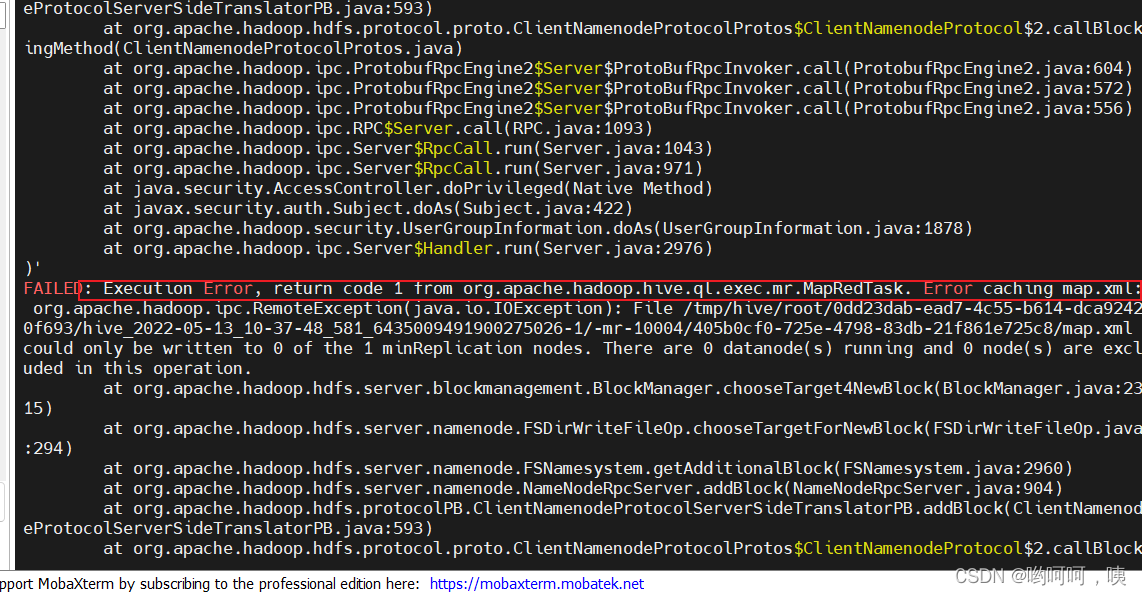

看它的报错信息好像是节点没有启动,但是我的节点都启动起来了,使用jps也能查看到节点信息。

使用hadoop dfsadmin -report命令查看磁盘使用情况,发现出现以下问题:

节点下存储空间都是空的,问题应该就是出现在这了。

查阅资料发现造成这个问题的原因可能是使用hadoop namenode -format格式化时格式化了多次造成那么spaceID不一致,解决方案:

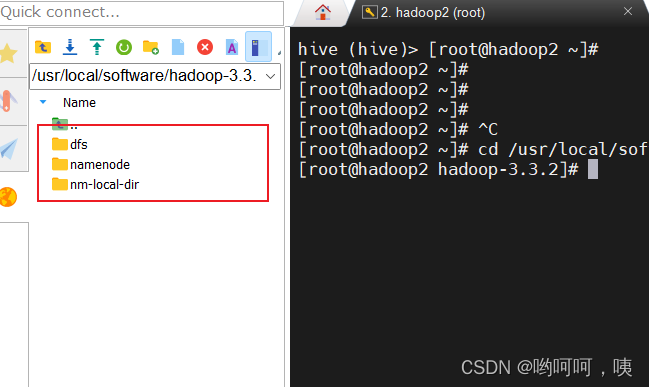

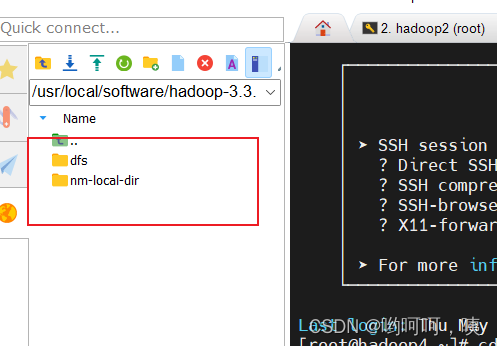

- 分别删除hadoop集群中的所有数据

hadoop2

hadoop3

hadoop4

- 使用

hadoop namenode -format格式化hadoop集群 - mysql数据库中创建hive数据库

- 使用

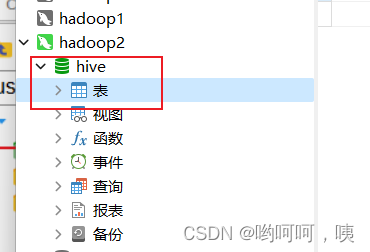

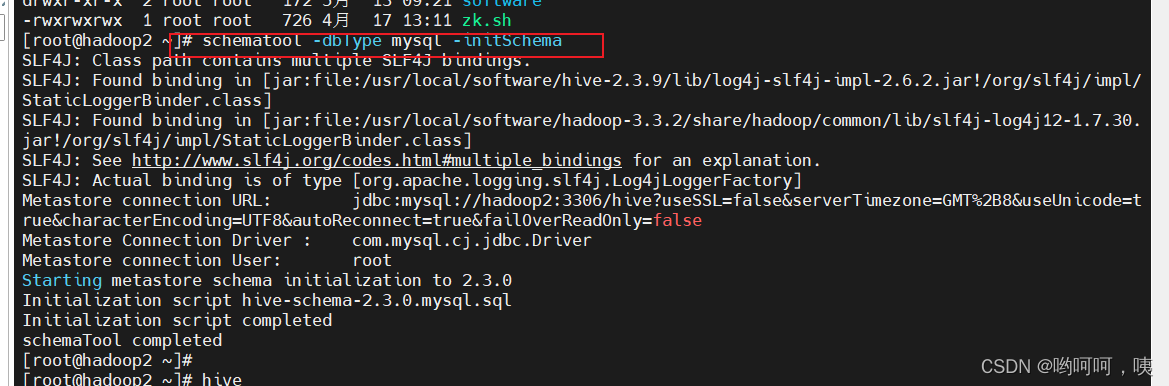

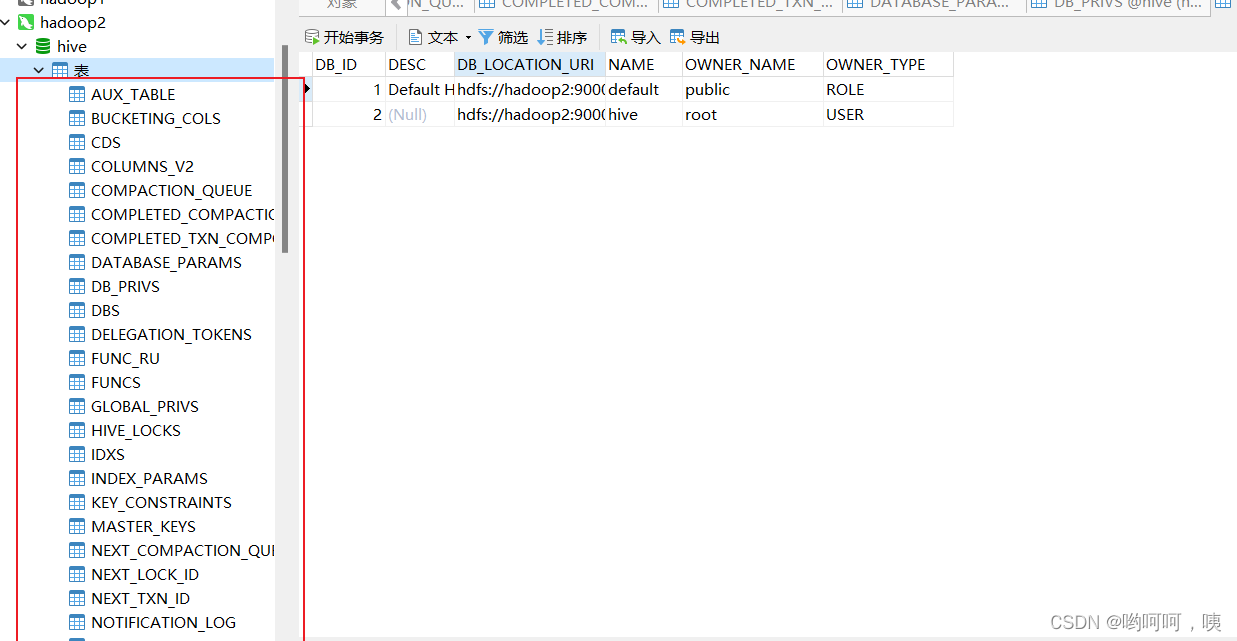

schematool -dbType mysql -initSchema格式化hive,最终出现如下图的各种hive元数据信息表

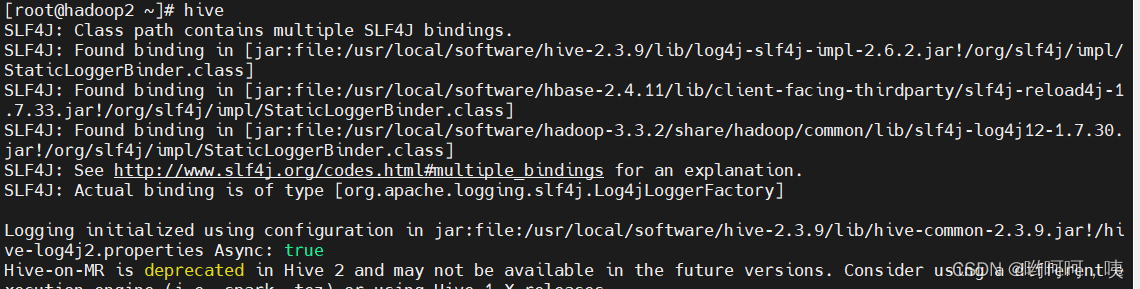

5. 启动hive

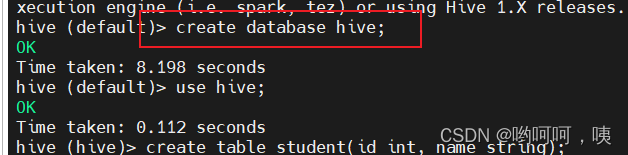

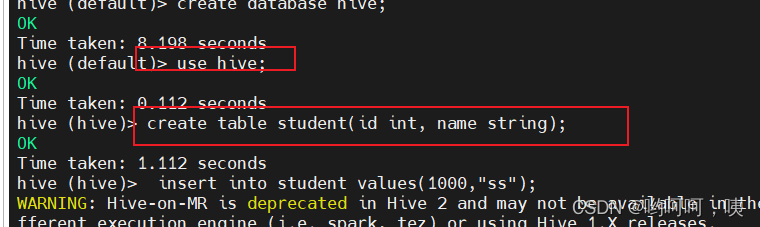

6. 创建hive数据库hive

7.创建表

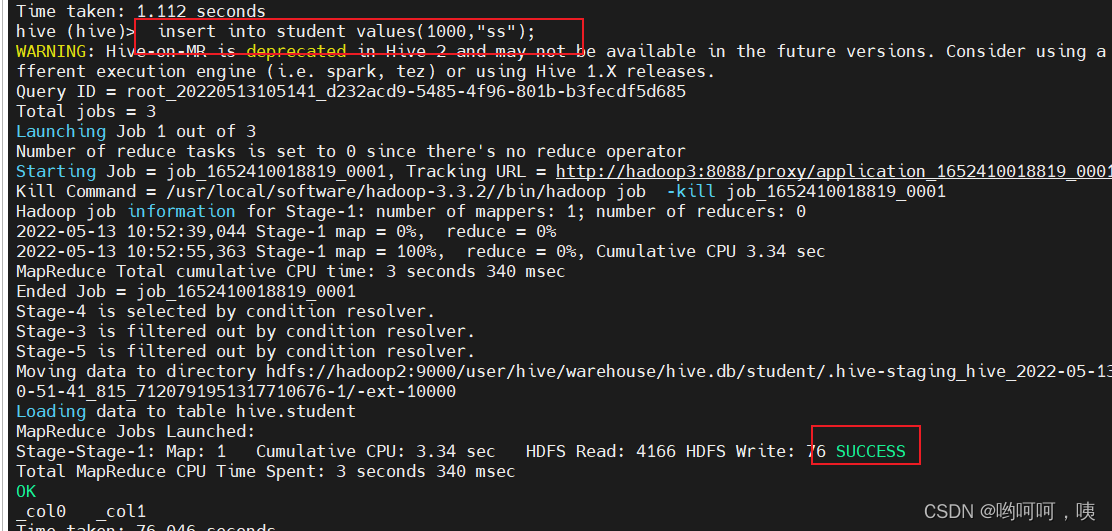

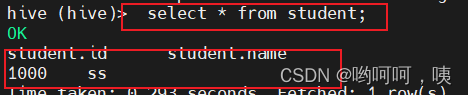

8. 插入数据

版权声明:本文为qq_45834006原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。