设置账号:组 hadoop:hadoop

SSH免密登录

注意事项:

关闭防护墙

- 显示状态:systemctl status firewalld.service

- 关闭:systemctl stop firewalld.service

- 开机时禁用:systemctl disable firewalld.service

1.上传文件

(以hadoop·2.7.2为例)

2.解压

[hadoop@hadoop1 soft]$ tar zxvf hadoop-2.7.2.tar.gz -C /opt/module

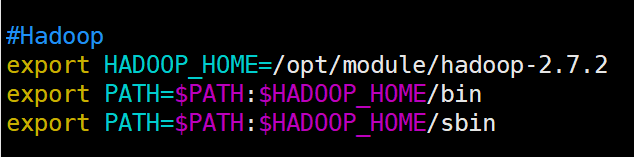

3.配置环境变量

[hadoop@hadoop1 soft]$ sudo vim /etc/profile

修改为:

export HADOOP_HOME=/opt/module/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

环境变量生效

[hadoop@hadoop1 soft]$ source /etc/profile

默认配置文件目录 $HADOOP_HOME/etc/hadoop

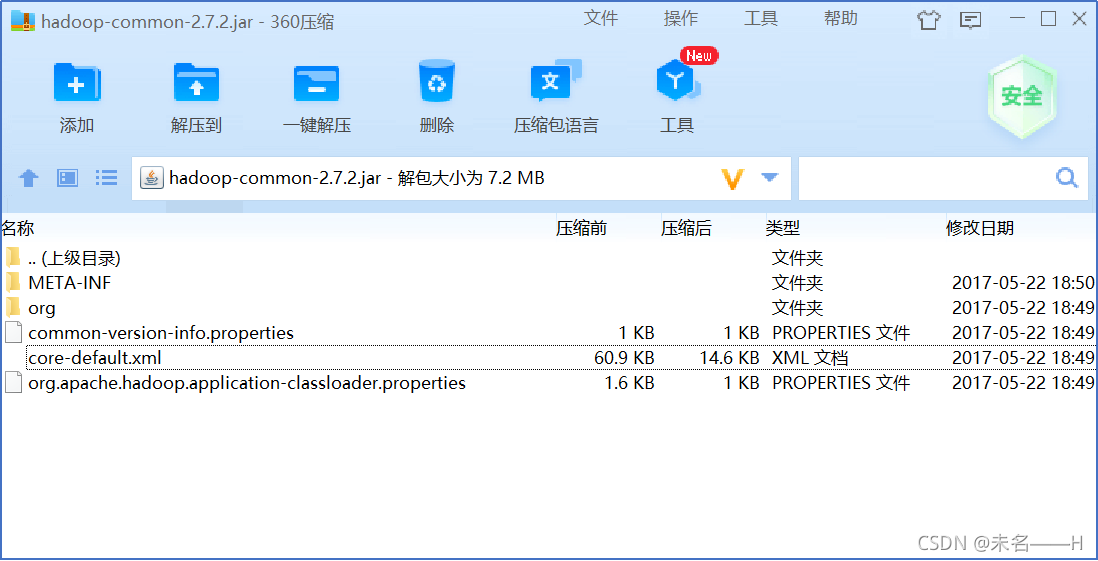

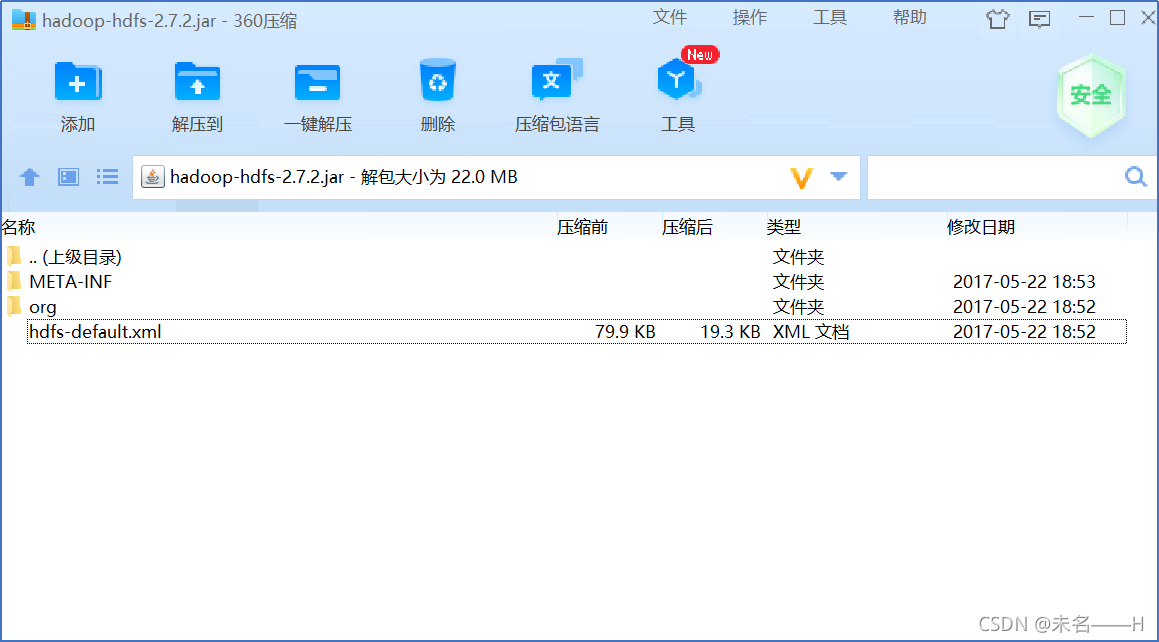

4.配置文件说明

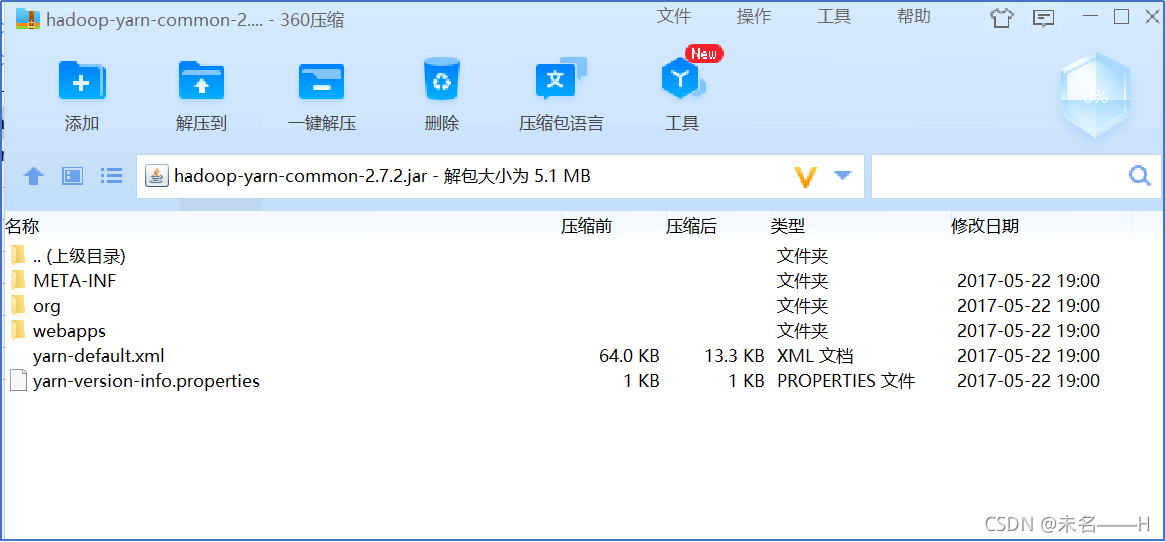

默认的配置文件:

core-default.xml: Hadoop核心的参数

hdfs-default.xml HDFS相关的参数!

mapred-default.xml: MR程序在运行时的参数!

yarn-default.xml: yarn: YARN在启动时需要的参数!

用户可以自定义的配置文件

core-site.xml: 用户自定义的设置hadoop核心的参数

hdfs-site.xml 用户自定义的HDFS相关的参数

mapred-site.xml: 用户自定义的MR程序需要的参数

yarn-site.xml: 用户自定义的YARN在启动时需要的参数

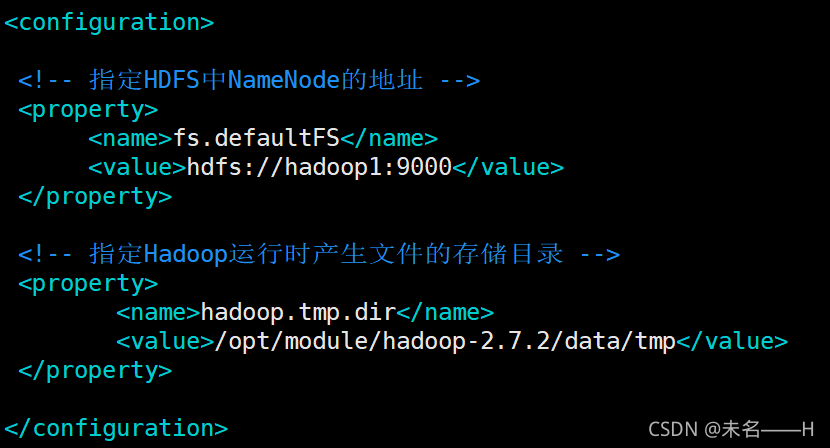

5.配置core-site.xml

[hadoop@hadoop1 hadoop]$ vi core-site.xml

<configuration>

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop1:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-2.7.2/data/tmp</value>

</property>

</configuration>

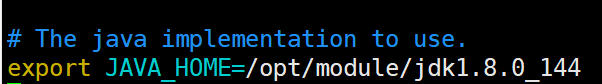

6.配置hadoop-env.sh

[hadoop@hadoop1 hadoop]$ vi hadoop-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144(或其他版本jdk)

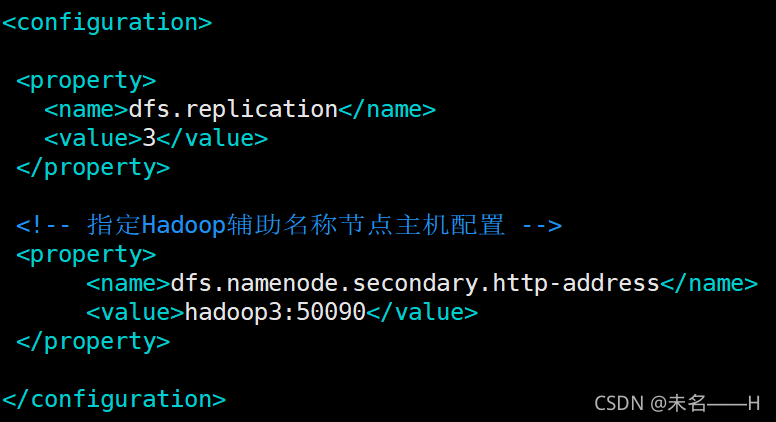

7.配置hdfs-site.xml

[hadoop@hadoop1 hadoop]$ vi hdfs-site.xml

<!—副本因子 -->

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- 指定Hadoop辅助名称节点主机配置 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop3:50090</value>

</property>

</configuration>

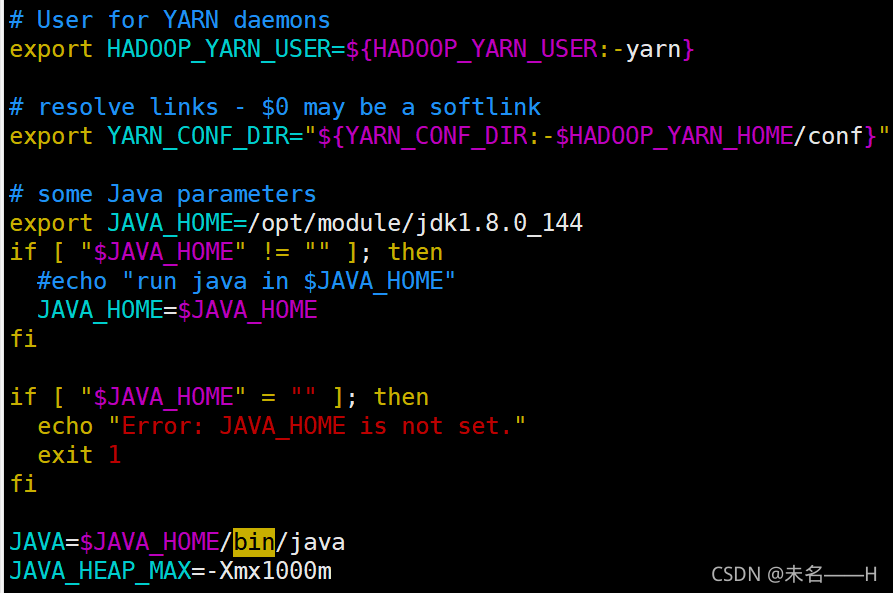

8.配置yarn-env.sh

[hadoop@hadoop1 hadoop]$ vi yarn-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

9.配置yarn-site.xml

[hadoop@hadoop1 hadoop]$ vi yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<!-- Reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop2</value>

</property>

</configuration>

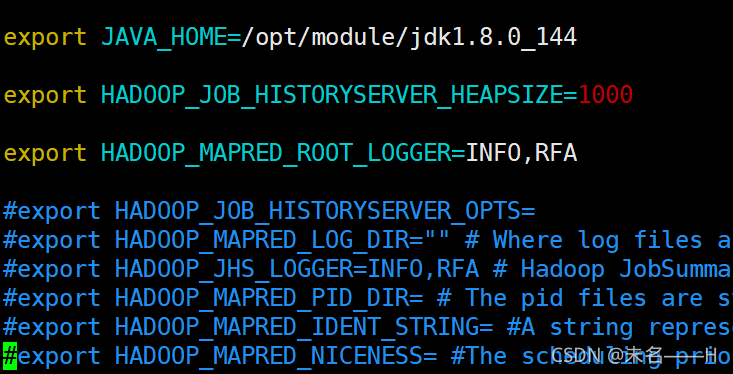

10.配置mapred-env.sh

[hadoop@hadoop1 hadoop]$ vi mapred-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

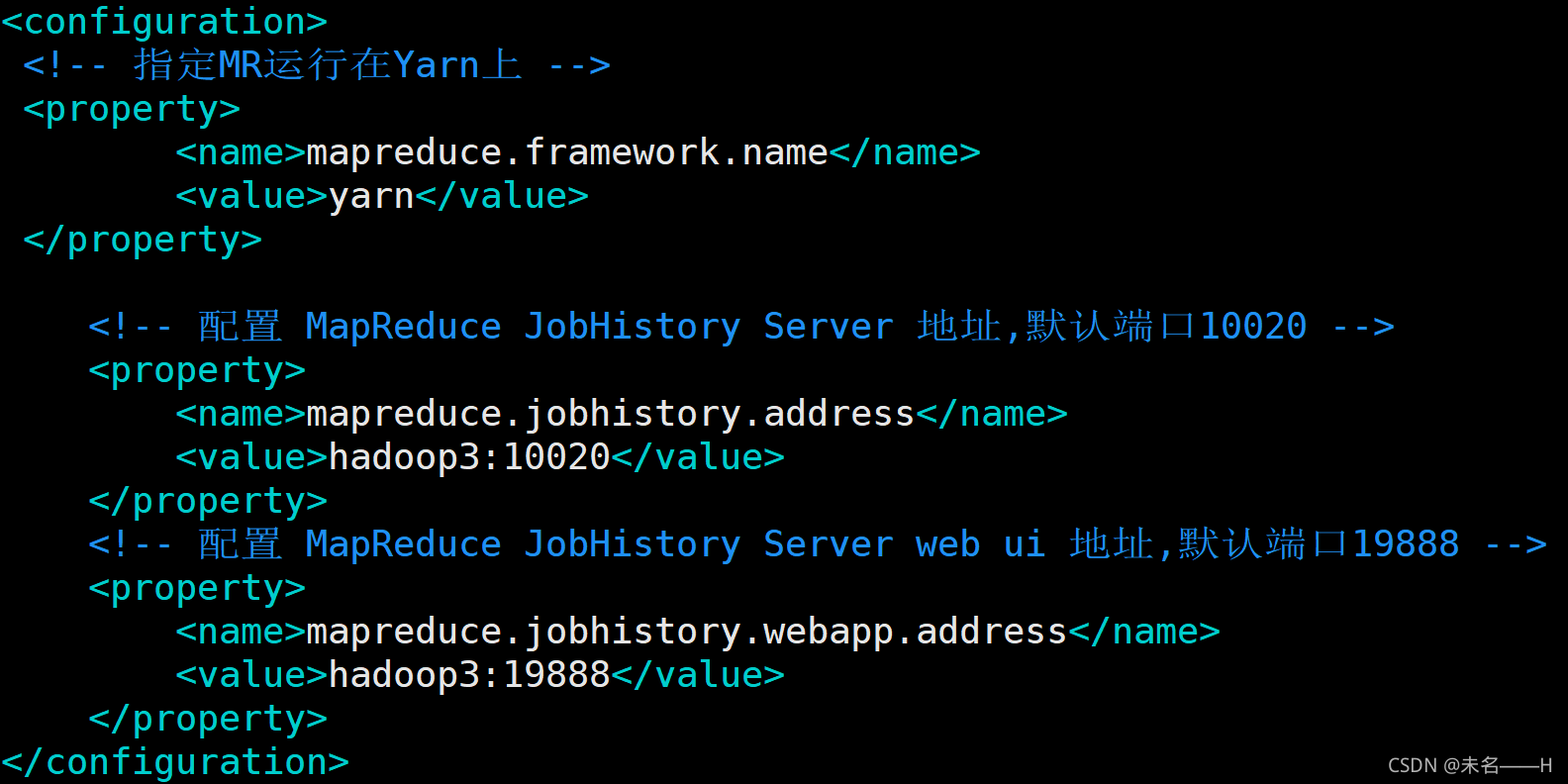

11.配置mapred-site.xml

[hadoop@hadoop1 hadoop]$ cp mapred-site.xml.template mapred-site.xml

[hadoop@hadoop1 hadoop]$ vi mapred-site.xml

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 配置 MapReduce JobHistory Server 地址,默认端口10020 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop3:10020</value>

</property>

<!-- 配置 MapReduce JobHistory Server web ui 地址,默认端口19888 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop3:19888</value>

</property>

</configuration>

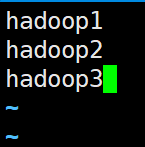

12.配置slaves

[hadoop@hadoop1 hadoop]$ vi slaves