1.查看进程jps

2.进入配置文件(可能路径不同,具体路径以格式化后通知的文件储存路径为主)

[root@master ~]# cd /tmp/hadoop-root/dfs/name/current/

3.改变文件格式,使之可以查看

hdfs oiv -i fsimage_000000000000000000 -o fsimage_000000000000000000.xml -p XML

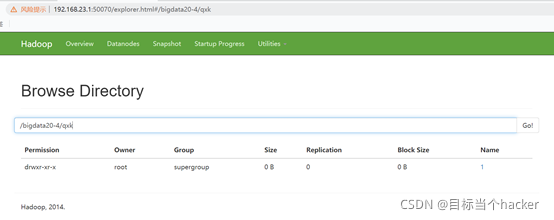

4.在Hadoop里新建文件夹

[root@master current]# hdfs dfs -mkdir /bigdata20-4

[root@master current]# hdfs dfs -mkdir -p /bigdata20-4/qxk/1

和正常命令一样,就是在mkdir前加破折号- 使之变为参数,并在整体前加上hdfs dfs 表指定,也可以使用-p 进行多级目录创建

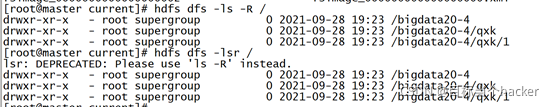

5.查询Hadoop文件

[root@master current]# hdfs dfs -ls -R /

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4/qxk

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4/qxk/1

[root@master current]# hdfs dfs -lsr /

lsr: DEPRECATED: Please use 'ls -R' instead.

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4/qxk

drwxr-xr-x - root supergroup 0 2021-09-28 19:23 /bigdata20-4/qxk/1

-R 表示递归

-lsr=-ls -R 有时-lsr会报错

6.下载,移动Hadoop文件

[root@master current]# hdfs dfs -put /export/software/jdk-8u191-linux-x64.tar.gz /bigdata20-4/qxk/1/

Put: 戴上,放到,放置,放 相当于mv

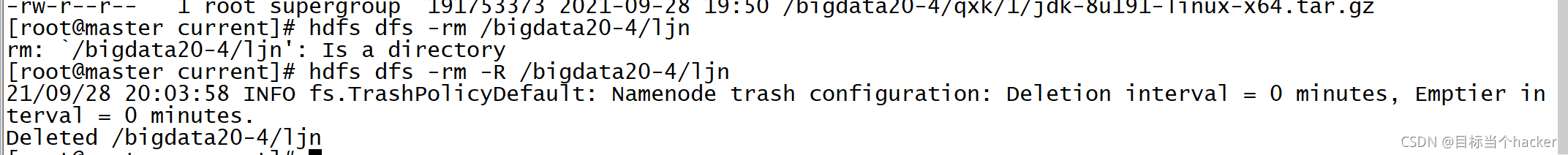

7.删除Hadoop文件

[root@master current]# hdfs dfs -rm /bigdata20-4/ljn

rm: `/bigdata20-4/ljn': Is a directory

[root@master current]# hdfs dfs -rm -R /bigdata20-4/ljn

21/09/28 20:03:58 INFO fs.TrashPolicyDefault: Namenode trash configuration: Deletion interval = 0 minutes, Emptier interval = 0 minutes.

Deleted /bigdata20-4/ljn

[root@master current]# hdfs dfs -rm /bigdata20-4/qxk/1/jdk-8u191-linux-x64.tar.gz

21/09/28 20:10:46 INFO fs.TrashPolicyDefault: Namenode trash configuration: Deletion interval = 0 minutes, Emptier interval = 0 minutes.

Deleted /bigdata20-4/qxk/1/jdk-8u191-linux-x64.tar.gz

注:必须在-rm 后加入-R才可以删除一个目录,-rm只可以删除一个文件