Word2Vec是将 单词转换为向量 的算法,该算法使得具有相似含义的单词表示为相互靠近的向量。

Word2Vec分为 Skip-Gram 和 CBOW 两种模型。Skip-Gram是中心词来预测上下文,CBOW是上下文来预测中心词。

其中Skip-Gram 建模不是目的,第一个hidden_layer的权重矩阵W,才是我们要求的词嵌入。用周围词来反向传播训练得到中心词的词嵌入。

CBOW可以看作Skip-Gram反过来。

关于Word2vec

word2vec是Google与2013年开源推出的一个用于获取word vecter的工具包,利用神经网络为单词寻找一个连续向量看空间中的表示。word2vec是将单词转换为向量的算法,该算法使得具有相似含义的单词表示为相互靠近的向量。

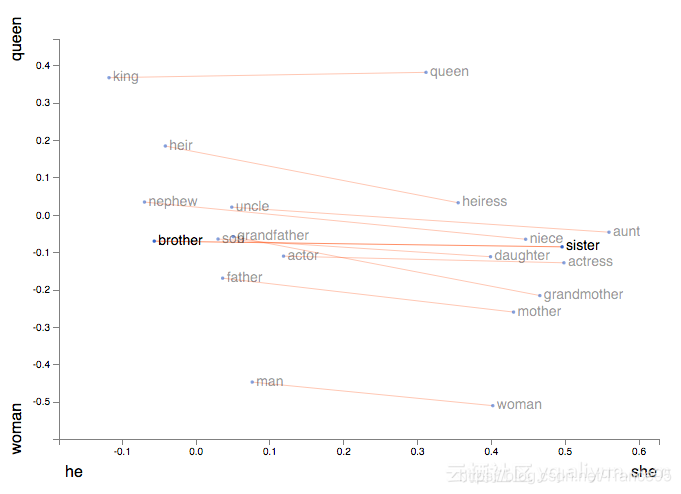

此外,它能让我们使用向量算法来处理类别,例如着名等式King−Man+Woman=Queen。

区别

word2vec一般分为CBOW</

版权声明:本文为Trance95原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。