上一篇文章:NLP模型笔记2022-33:Sentence-BERT STS模型列表与预训练方法

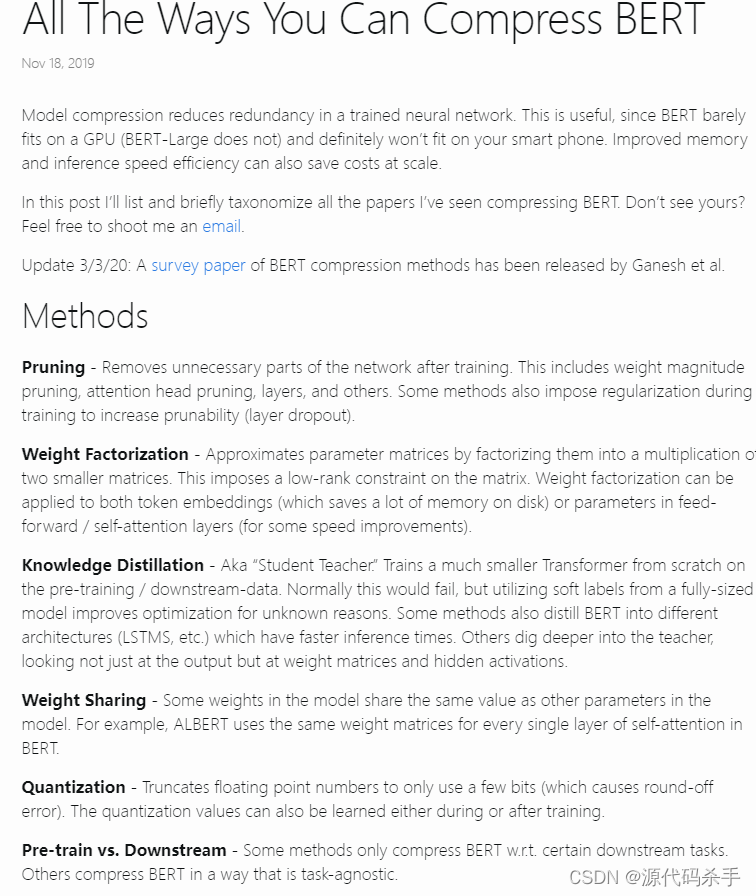

压缩方法英文总结:http://mitchgordon.me/machine/learning/2019/11/18/all-the-ways-to-compress-BERT.html

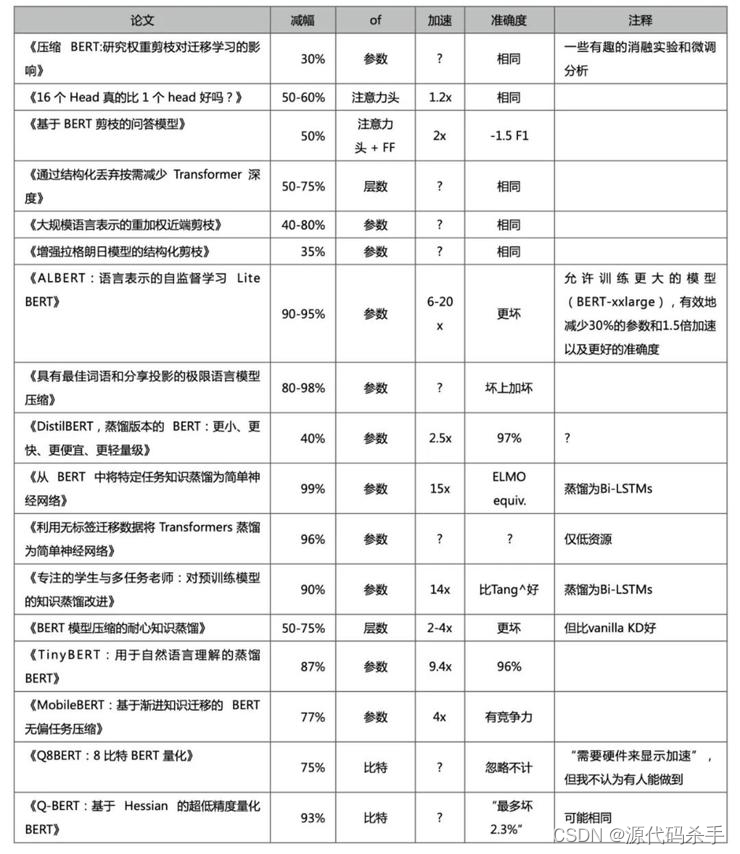

压缩方法中文总结:https://baijiahao.baidu.com/s?id=1659957262872530251&wfr=spider&for=pc

BERT模型压缩方法:

大规模的预训练语言模型已经成为各种自然语言处理任务(NLP)的新驱动力,例如BERT在对下游任务进行微调后,显著提高了模型的表现。尽管这些模型在各种NLP任务上获得了最先进的结果,但是通常内存占用和功耗过高,以此带来很高的延迟,包括训练阶段和推断阶段。这反过来又限制了这些模型在移动和物联网等嵌入式设备上的部署。模型压缩旨在解决

版权声明:本文为weixin_41194129原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。