Spark是大数据体系的明星产品,是一款高性能的分布式内存迭代计算框架,可以处理海量规模的数据。下面就带大家来学习今天的内容!

往期内容:

- Spark基础入门-第一章:Spark 框架概述

- Spark基础入门-第二章:Spark环境搭建-Local

- Spark基础入门-第三章:Spark环境搭建-StandAlone

- Spark基础入门-第四章:Spark环境搭建-StandAlone-HA

- Spark基础入门-第五章:环境搭建-Spark on YARN

- Spark基础入门-第六章:PySpark库

- Spark基础入门-第七章:本机开发环境搭建

- Spark基础入门-第八章:分布式代码执行分析

一、程序入口 SparkContext对象

Spark RDD 编程的程序入口对象是SparkContext对象(不论何种编程语言),只有构建出SparkContext, 基于它才能执行后续的API调用和计算。本质上, SparkContext对编程来说, 主要功能就是创建第一个RDD出来。

二、 RDD的创建

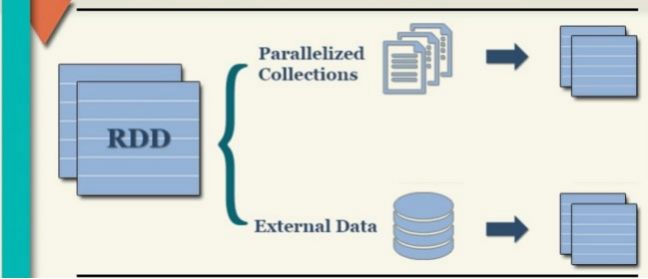

RDD的创建主要有2种方式:

• 通过并行化集合创建 ( 本地对象 转 分布式RDD)

• 读取外部数据源 ( 读取文件 )

三、 RDD 算子

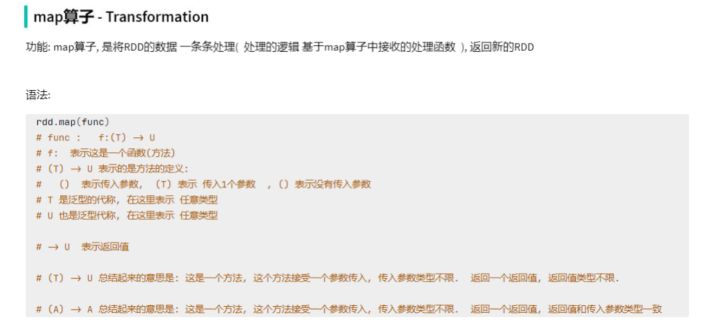

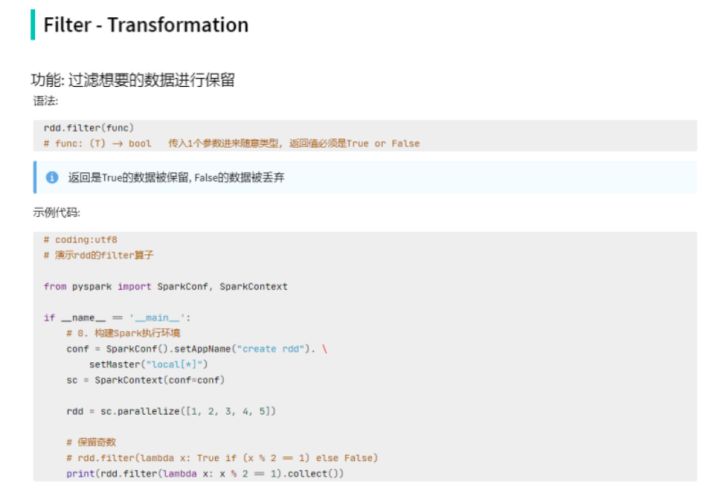

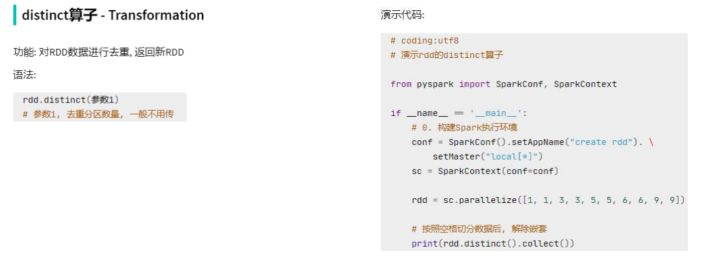

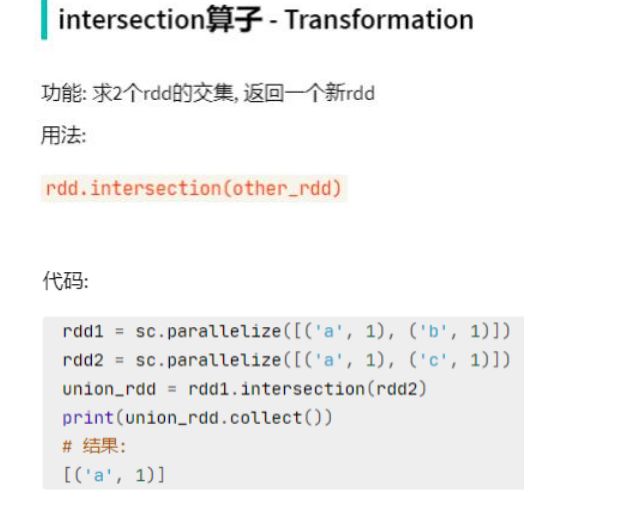

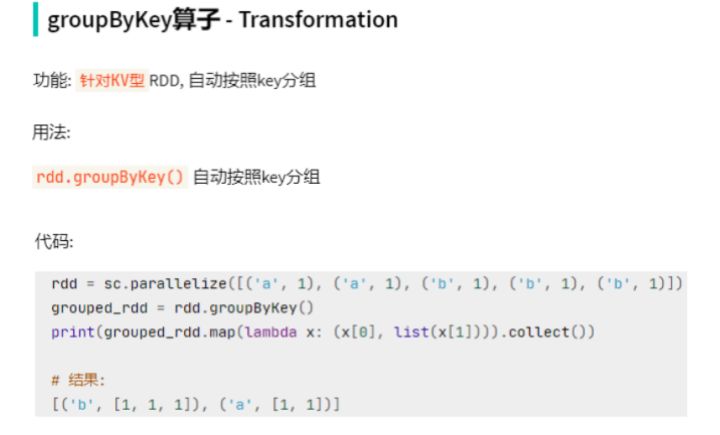

四、常用Transformation算子

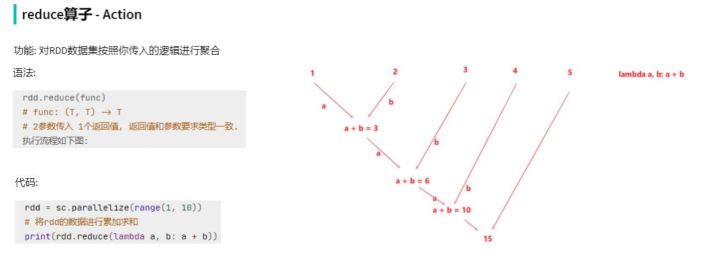

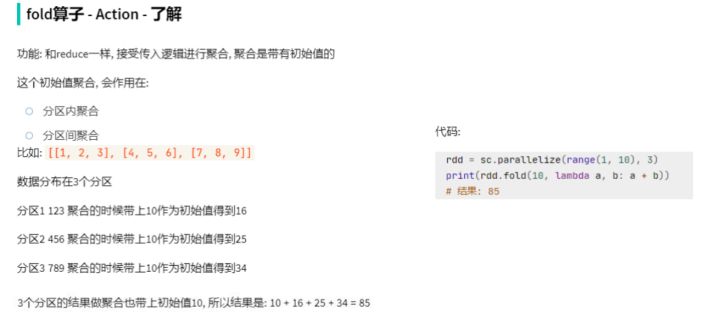

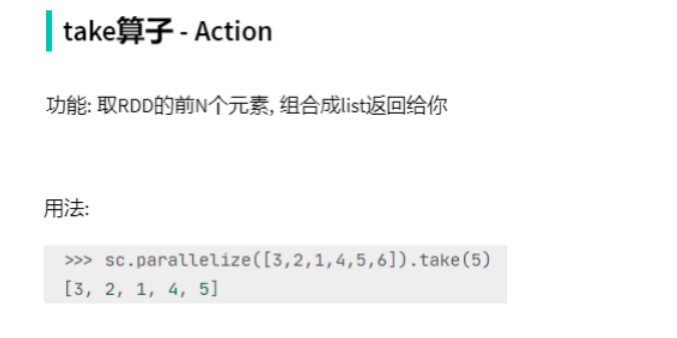

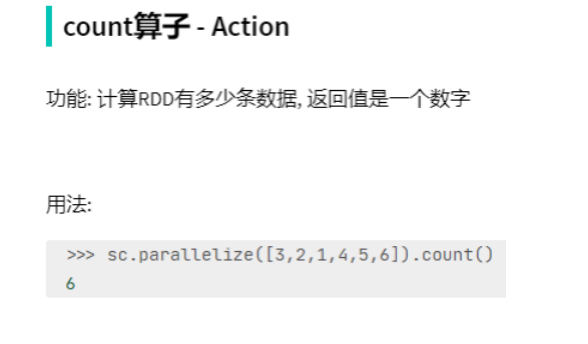

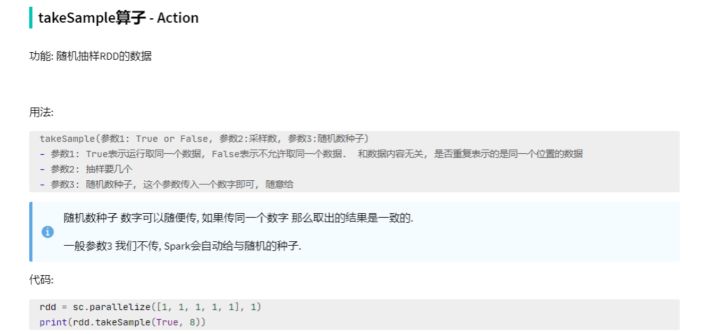

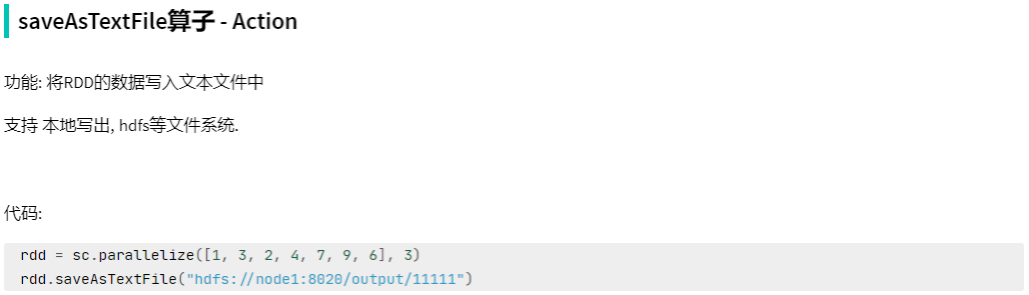

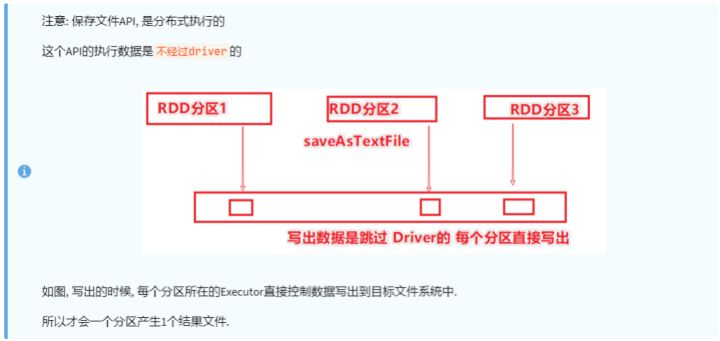

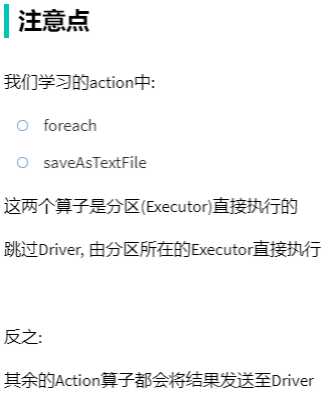

五、 常用 Action 算子

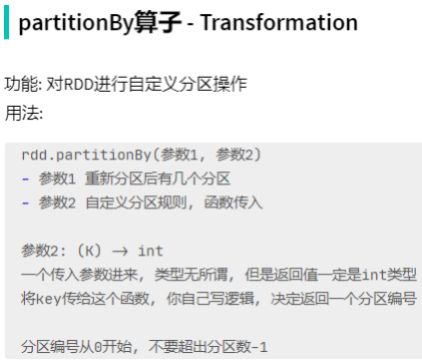

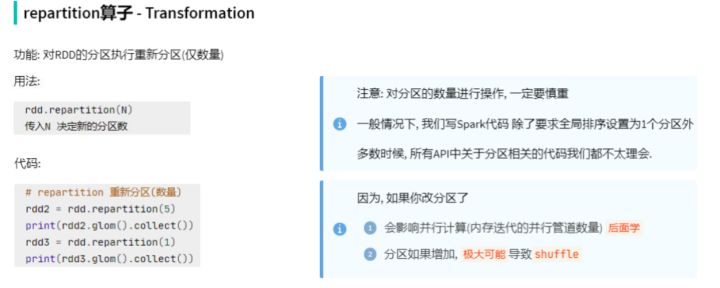

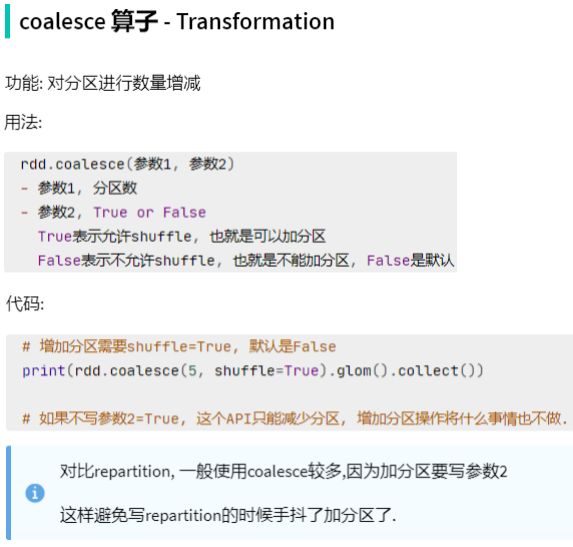

六、分区操作算子

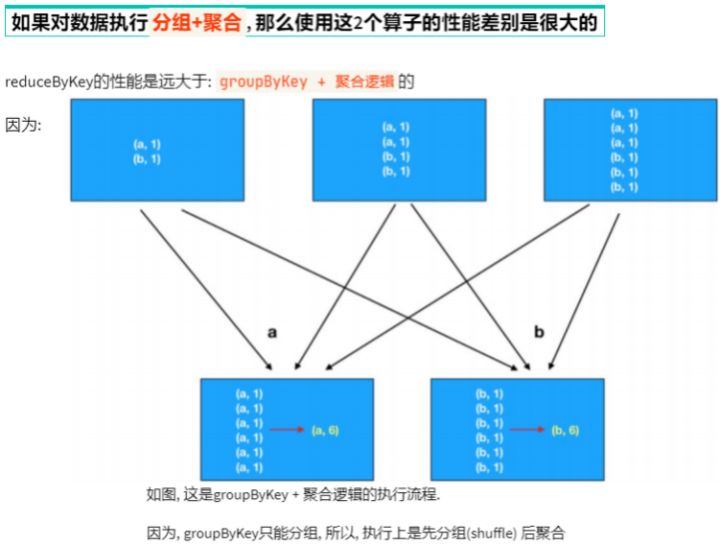

七、面试题: groupByKey和reduceByKey的区别

版权声明:本文为itcast_cn原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。