文章目录

Attentional Factorization Machines:Learning the Weight of Feature Interactions via Attention Networks (2017)

(0) 个人小结

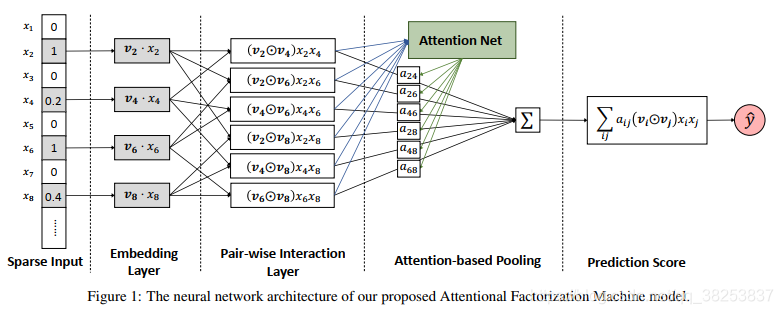

AMF是在FM的基础上引入了注意力机制,从而学习交叉特征的“重要程度”(即给每个交叉项学习一个权重)。AMF由输入层、Embedding层、Pair-wise Interaction层、Attention-based Pooling层组成。Pair-wise Interaction层主要完成特征的交叉,Attention-based层主要完成交叉特征的权重。

(1) 研究目标

提出AFM模型来解决FM学习交叉特征并没有区分各交叉特征的权重问题。

(2) 背景 & 问题描述

FM统一地对待各交叉特征,而没有区分不同交叉特征对目标预测的重要程度,在实际的数据中,交叉特征中的某些交叉项可能对目标预测并没有什么用,那么这些项就可能成为噪声。

(3) 研究方法

AFM的模型图为:

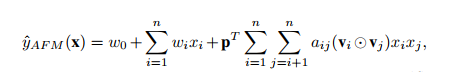

AFM的公式为:

其中,p是预测层的参数,a是attention学习得到的权重。

(4) 结论与展望

AFM可以提高特征的表达能力,并且让FM有一定的可解释性。

Attention-based Pooling层后面是不是可以再加个DNN来学习高阶特征交叉信息。

版权声明:本文为qq_38253837原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。