1.虚拟机的创建

1.1.Vmware的安装

将Vmware软件安装包下载至电脑,解压并点击安装软件

1.2.虚拟机的创建

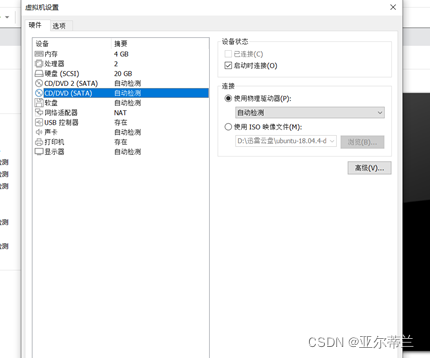

点击 创建新的虚拟机 创建虚拟机,命名为ubuntu,选择ubuntu镜像文件,设置虚拟机硬盘容量等

打开虚拟机时遇到问题:

解决办法:禁用hyper-v相关服务,失败,将Vmware软件升级至16.1.1版本,可正常启动虚拟机

1.3.VMware tools的安装

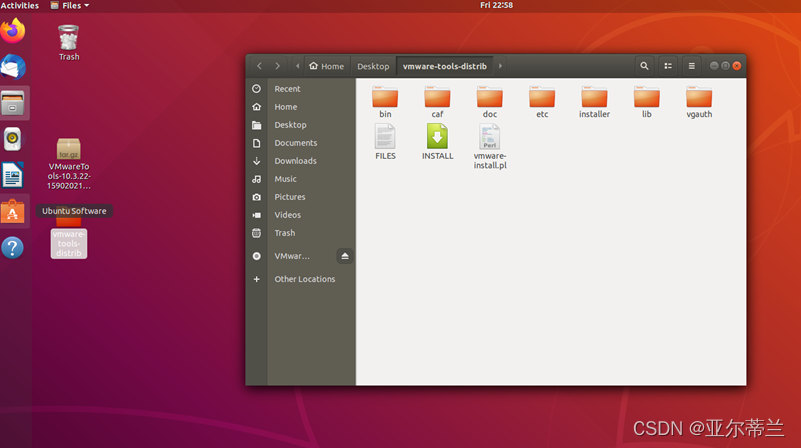

在VMware界面点击虚拟机,选择 安装VMware tools,ubuntu界面出现VMware toolsDVD文件,使用tar命令解压,解压后出现vmware-tools-distrib文件夹,使用cd命令跳转至该文件夹,执行vmware-install.pl 安装完成后重启虚拟机

2.Linux的常用命令

//进入文件夹命令cd

cd /home/hadoop //进入路径为/home/hadoop的文件夹

//列举命令ls

ls /home/hadoop //列举/home/hadoop目录中的所有文件

//复制命令cp

cp /home/example.txt /home/data //将/home/目录下example.txt文件复制到/home/data目录

//移动文件命令mv

mv /home/example.txt /home/data //将/home目录下example.txt文件移到/home/data目录

//重命名命令mv

mv example.txt example2.txt //将当前目录下的example.txt文件重命名为example2.txt

//解压命令tar

sudo tar –zxvf file.tar.gz –C /home/data //将当前目录下的file.tar.gz文件解压到/home/data目录下

//编辑文件命令 vim

vim example.txt //使用vim打开当前目录下的example.txt文件,并进行编辑

//删除文件和目录命令rm

//rm –r /home/data //删除/home/data目录以及其下的所有文件

//建立目录命令mkdir

mkdir /home/data //在home目录下建立data目录

//安装软件命令apt-get install

apt-get install vim //安装软件vim

3.JDK的安装

打开终端,执行 sudo apt-get install default-jre 以安装JRE

执行 sudo apt-get install default-jdk 以安装OpenJDK

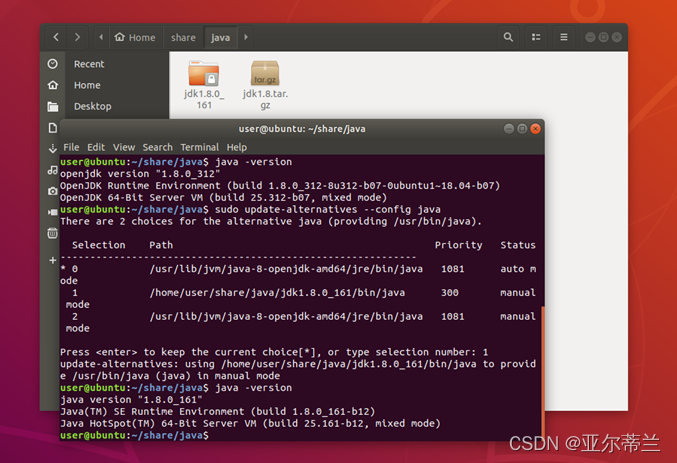

使用bin包安装Oracle JDK:将下载好的jdk 文件传入虚拟机,使用tar 命令解压,创建/home/share/java文件夹,将解压后的文件放入该文件夹。

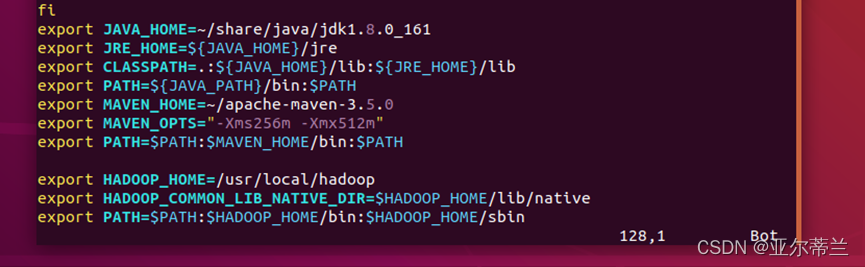

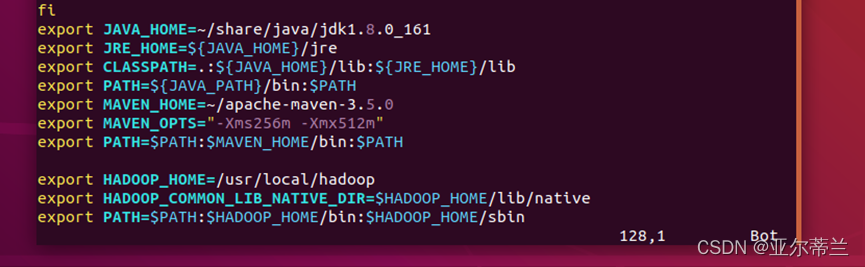

设置环境变量:执行 sudo vim ~/.bashrc 在bashrc文件中添加下图中的前4行内容:

执行 source ~/.bashrc使文件生效,执行 java -vesion验证JDK以安装完成:

问题:vim 未安装

解决办法:使用gedit或执行 sudo apt-get install vim进行安装

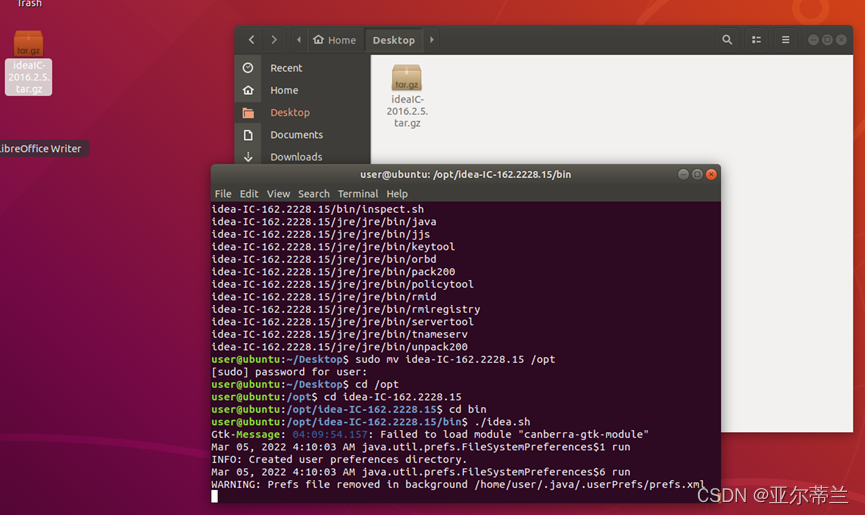

4.IDEA和Maven的安装

将下载好的IDEA压缩包传入虚拟机,使用tar命令解压至/opt目录,进入idea-IC-162.222.15/bin 目录,执行./idea.sh即可安装IDEA

Maven的配置:

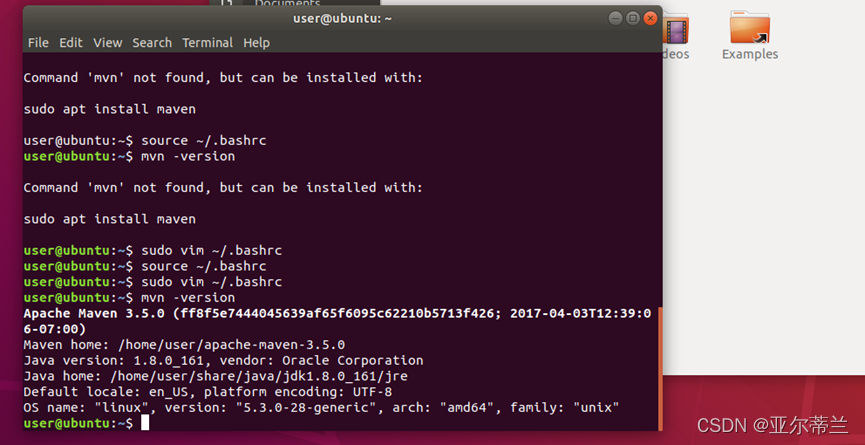

将maven压缩包下载至虚拟机,使用如下命令解压并移动到新建的目录下,同样编辑bashrc文件将环境变量配置好,执行mvn -version查看是否安装成功

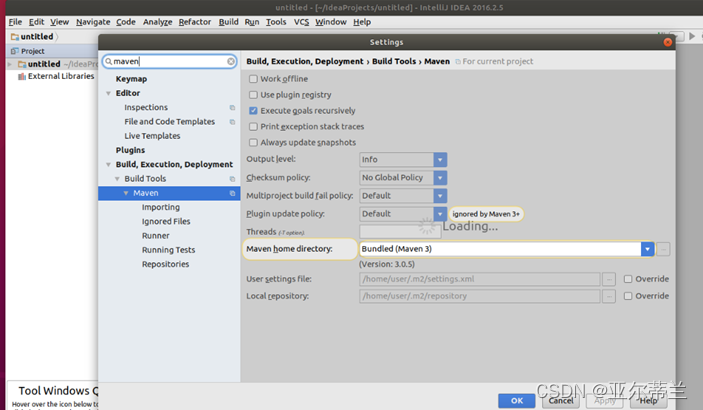

在IDEA中配置Maven:点击file,Setting,maven,如下图配置maven:

5.Hadoop的安装

使用useradd创建hadoop用户并为该用户增加管理员权限,登录该用户,执行 sudo apt-get install openssh-server安装ssh,执行 sudo localhost登录ssh,首次登陆输入yes,执行exit退出登录

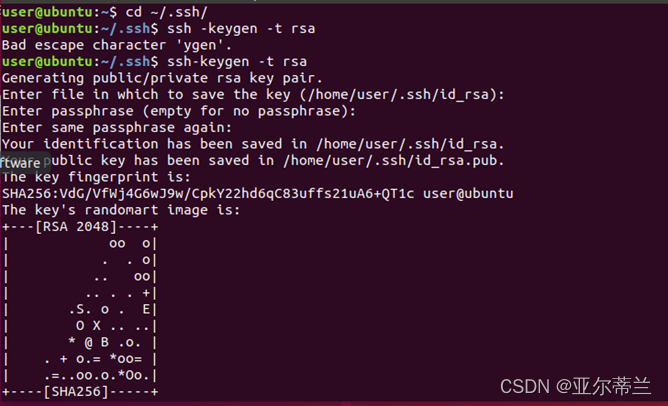

执行 ssh-keygen -t rsa 设置无密码登录

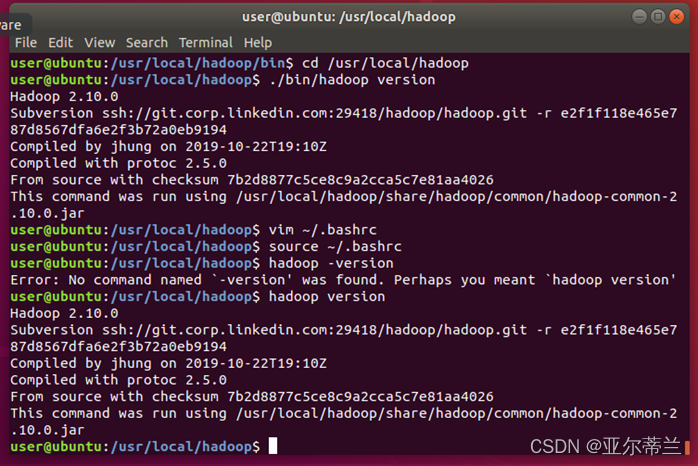

安装hadoop:将Hadoop软件压缩包传入虚拟机,使用tar命令解压至/usr/local目录,使用chown修改文件权限

配置hadoop的环境变量:打开bashrc文件,添加相关路径:

执行 source ~/.bahsrc使文件生效,执行 hadoop version查看是否安装成功

Hadoop的伪分布式配置:

跳转至/usr/local/hadoop/etc/hadoop目录,使用vim将jdk1.8的路径添加至hadoop-env.sh文件中

修改core-site.xml文件,将以下内容添加至该文件:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改hdfs-site.xml文件,将以下内容添加至该文件:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

跳转至/usr/local/hadoop目录,执行 ./bin/hdfs namenode -format 完成namenode 的格式化

执行 ./sbin/start-dfs.sh 启动namenode和datanode进程,执行 jps查看是否启动成功