大并发服务器架构设计

如何降低数据库(提高数据库的并发能力)的方法:

1、队列+连接池(DAL)

2、主要的业务逻辑挪到应用服务器处理,数据库只做辅助的业务处理

3、缓存(使用缓存的问题:缓存更新(同步))【见链接】

分布式缓存:非关系型数据库如redis,memcatched等

如果缓存跟应用服务器部署在同一台机器上,就只是局部缓存(只缓存在一台机器上),而非全局的缓存。假设有两台应用服务器,如果将缓存部署在不同的应用服务器上,那么不同的应用服务器很难访问彼此的缓存,非常不方便。将缓存部署在单独服务器上,各个应用服务器都能访问该缓存服务器。

任务服务器(比如可以通过一个http协议的接口来)监控各个应用服务器的负载情况(比如是IO高,CPU高,并发高,内存换页高)

另外服务器开发的几个性能杀手:

1 数据拷贝,数据从内核态copy到用户态,或者在用户态之间copy会造成性能损失,尽量采用缓存的方式解决。

2 环境切换 (理性创建线程),多线程上下文切换造成开销。如果服务器是单核的,那么采用状态机方式单线程效果最佳。如果是多核的,合理采用多线程,可以提升性能。

3 内存分配,可以采用内存池,提前分配。

4 锁竞争,加锁解锁会造成一定的效率衰减。

大型网站架构的演变过程

大型网站是大并发服务器的一个典型事例

一、初始阶段的架构

web服务器(包括http和应用服务器)和数据服务器一体

二、web服务器与数据库分离

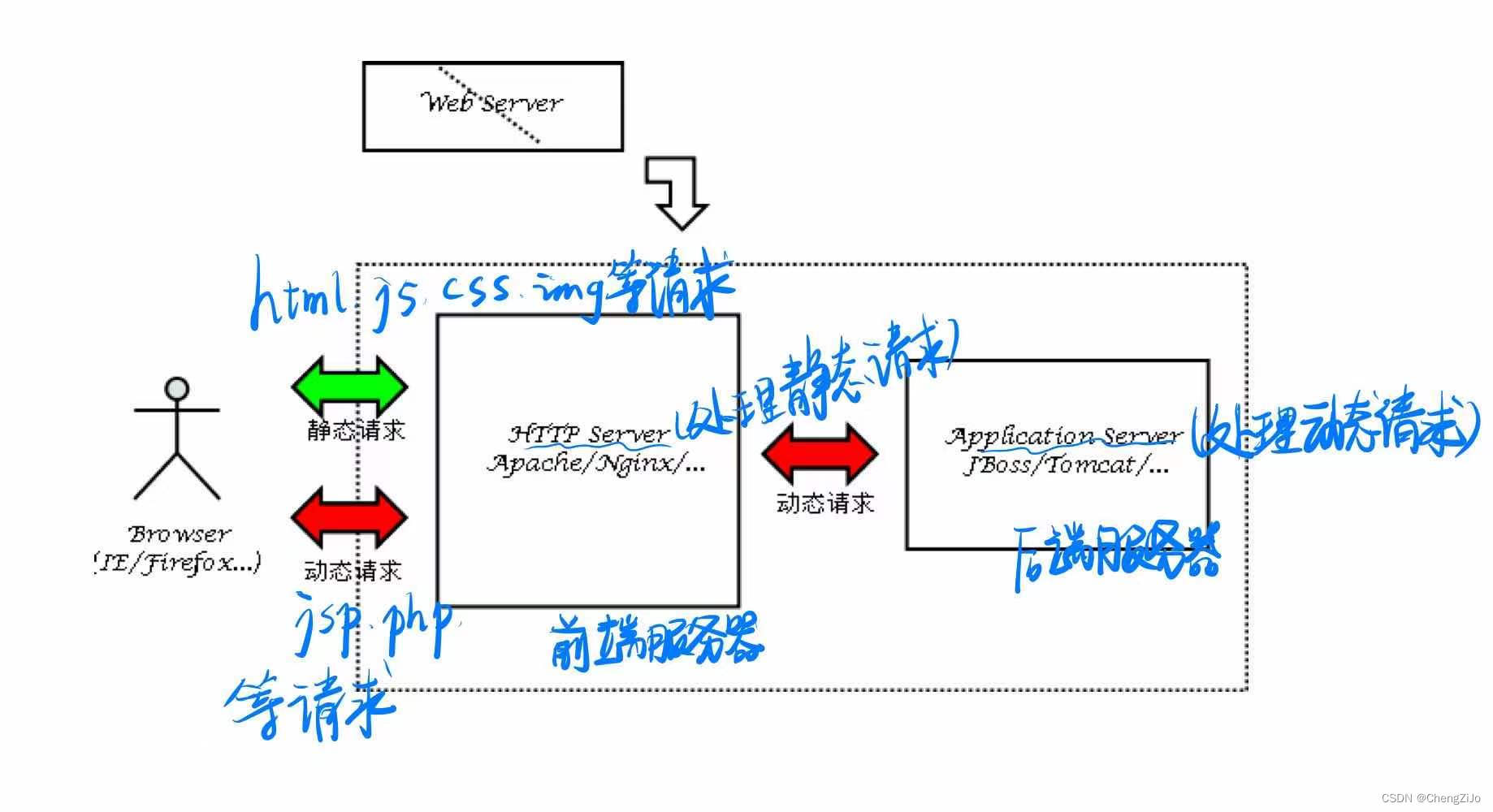

其中,web服务器还采用动静资源分离

三、采用缓存处理

通过客户端(浏览器)的缓存减少对网站的访问

通过前端页面缓存(静态页面缓存)减少对Web应用服务器的请求

页面片段缓存ESI

本地数据缓存减少对数据库的查询

四、Web服务器集群+读写分离

流量越来越大,一台应用服务器肯定是扛不住的,这个时候需要多台服务器一起分配流量,处理问题。

前端http服务器负载均衡(DNS负载均衡、反向代理)

后端应用服务器负载均衡(增加任务服务器)

数据库负载均衡(读写分离,replication机制)

五、使用CDN(内容分发网络)加速访问+分布式缓存+数据库分库分表

本地数据缓存变成分布式缓存(memcached,redis等,当前的noSql方案都可以做分布式缓存方案)

数据量较大会造成锁竞争(服务器性能四大杀手之一),因此需要数据库分库分表

六、多数据中心+分布式存储与计算

关系数据库中的事务处理,大表join是服务器的性能杀手,因此一些对一致性要求不高的数据没必要保存在关系数据库中,可以采用基于分布式文件系统计算架构建立数据中心,就可以对一致性要求不高的数据采用noSql(基于key_val的数据库(哈希算法))存储。