本地启动

1. 下载安装包

进入 Flink 官网,下载 1.13.0 版本安装包 flink-1.13.0-bin-scala_2.12.tgz,注意此处选用对

应 scala 版本为 scala 2.12 的安装包。

2. 解压

在 hadoop102 节点服务器上创建安装目录/opt/module,将 flink 安装包放在该目录下,并

执行解压命令,解压至当前目录。

$ tar -zxvf flink-1.13.0-bin-scala_2.12.tgz -C /opt/module/

flink-1.13.0/

flink-1.13.0/log/

flink-1.13.0/LICENSE

flink-1.13.0/lib/

……

3. 启动

进入解压后的目录,执行启动命令,并查看进程。

$ cd flink-1.13.0/

$ bin/start-cluster.sh

Starting cluster.

Starting standalonesession daemon on host hadoop102.

Starting taskexecutor daemon on host hadoop102.

$ jps

10369 StandaloneSessionClusterEntrypoint

10680 TaskManagerRunner

10717 Jps

5. 关闭集群

如果想要让 Flink 集群停止运行,可以执行以下命令:

$ bin/stop-cluster.sh

Stopping taskexecutor daemon (pid: 10680) on host hadoop102.

Stopping standalonesession daemon (pid: 10369) on host hadoop102.

集群启动

1. 下载并解压安装包:具体操作与上节相同。

2. 修改集群配置

2.1进入 conf 目录下,修改 flink-conf.yaml 文件,修改 jobmanager.rpc.address 参数为

hadoop102,如下所示:

$ cd conf/

$ vim flink-conf.yaml

# JobManager 节点地址.

jobmanager.rpc.address: hadoop102

这就指定了 hadoop102 节点服务器为 JobManager 节点。

2.2修改 workers 文件,将另外两台节点服务器添加为本 Flink 集群的 TaskManager 节点,

具体修改如下:

$ vim workers

hadoop103

hadoop104

这样就指定了 hadoop103 和 hadoop104 为 TaskManager 节点。

3.分发安装目录

配置修改完毕后,将 Flink 安装目录发给另外两个节点服务器。

$ scp -r ./flink-1.13.0 atguigu@hadoop103:/opt/module

$ scp -r ./flink-1.13.0 atguigu@hadoop104:/opt/module

4. 启动集群

4.1在 hadoop102 节点服务器上执行 start-cluster.sh 启动 Flink 集群:

$ bin/start-cluster.sh

Starting cluster.

Starting standalonesession daemon on host hadoop102.

Starting taskexecutor daemon on host hadoop103.

Starting taskexecutor daemon on host hadoop104.

4.2查看进程情况:

[atguigu@hadoop102 flink-1.13.0]$ jps

13859 Jps

13782 StandaloneSessionClusterEntrypoint

[atguigu@hadoop103 flink-1.13.0]$ jps

12215 Jps12124 TaskManagerRunner

[atguigu@hadoop104 flink-1.13.0]$ jps

11602 TaskManagerRunner

11694 Jps

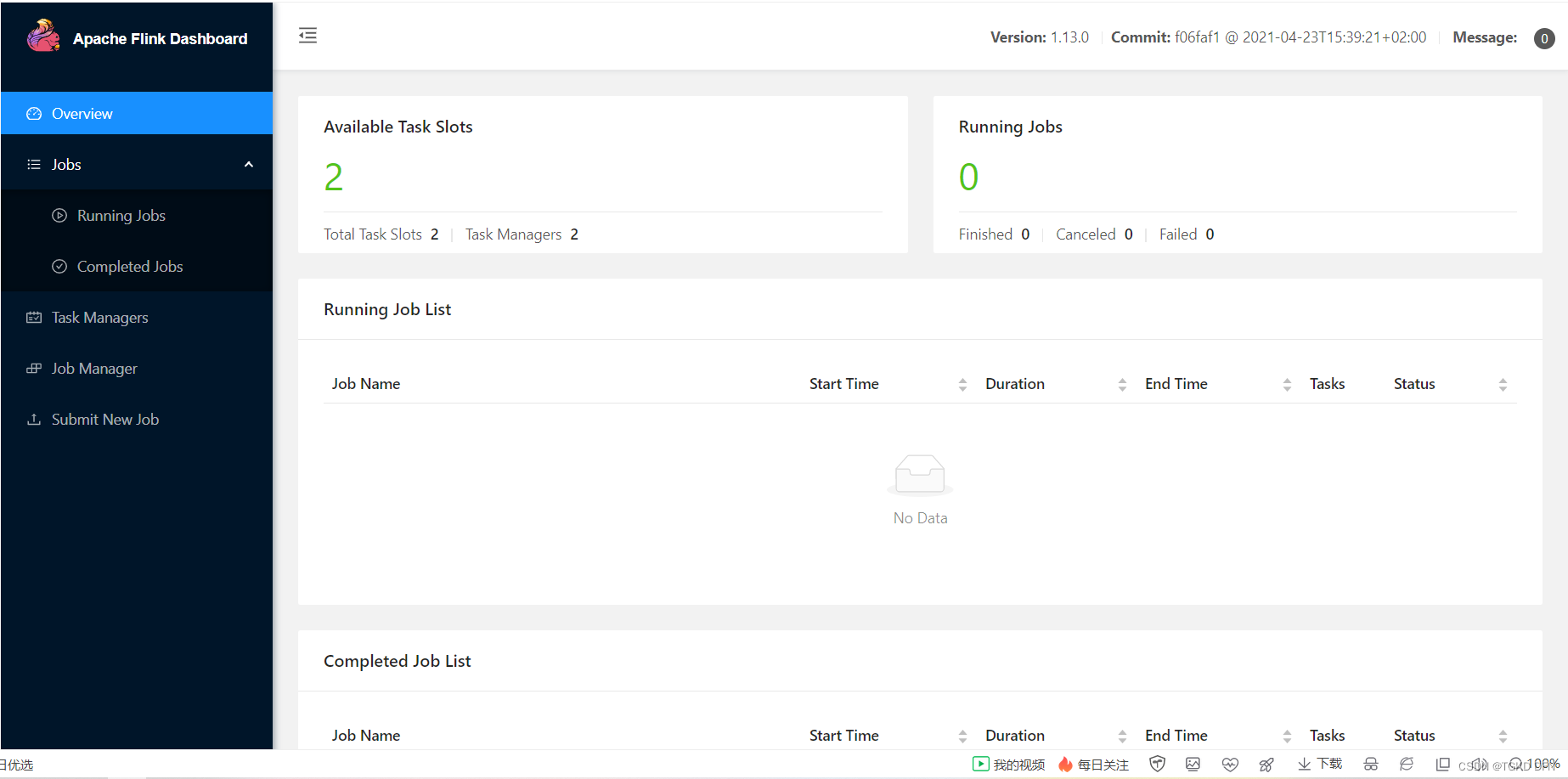

5. 访问 Web UI

启动成功后,同样可以访问 http://hadoop102:8081 对 flink 集群和任务进行监控管理,如图

所示。

这里可以明显看到,当前集群的 TaskManager 数量为 2;由于默认每个 TaskManager 的 Slot

数量为 1,所以总 Slot 数和可用 Slot 数都为 2。