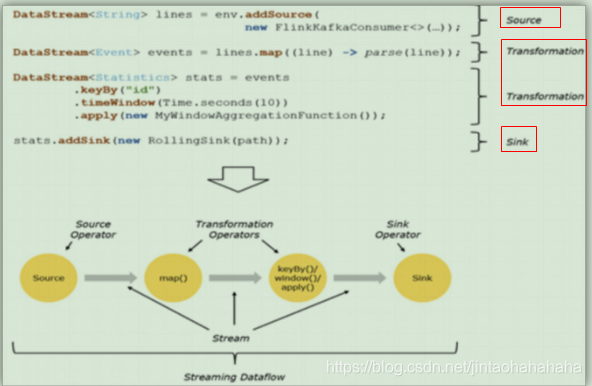

一、程序与数据流转换(DataFlow)

• 所有的Flink程序都是由三部分组成的: Source 、Transformation 和 Sink。

• Source 负责读取数据源,Transformation 利用各种算子进行处理加工,Sink 负责输出

• 在运行时,Flink上运行的程序会被映射成“逻辑数据流”(dataflows),它包含了这三部分

• 每一个dataflow以一个或多个sources开始以一个或多个sinks结束。dataflow类似于任意的有向无环图(DAG)

• 在大部分情况下,程序中的转换运算(transformations)跟dataflow中的算子(operator)是一一对应的关系

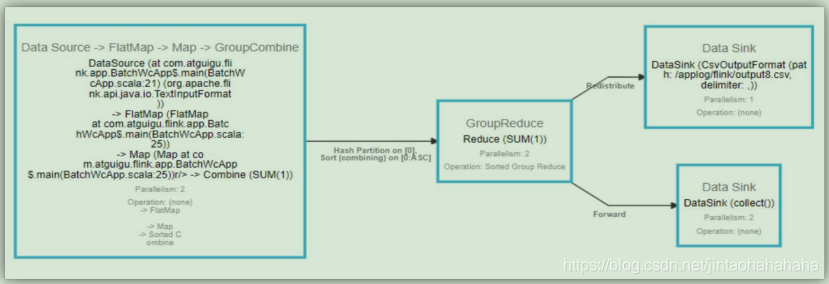

二、执行图

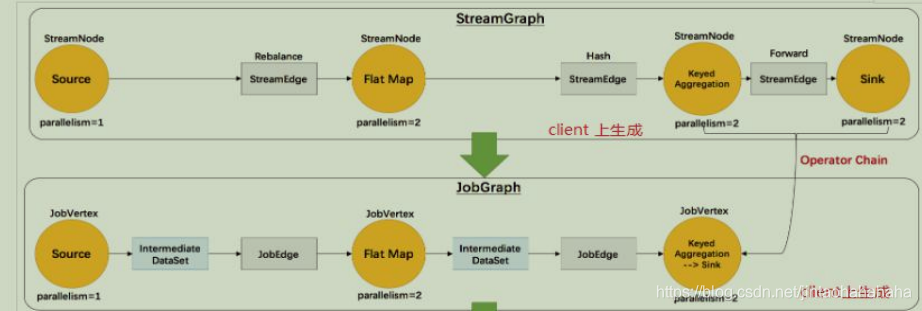

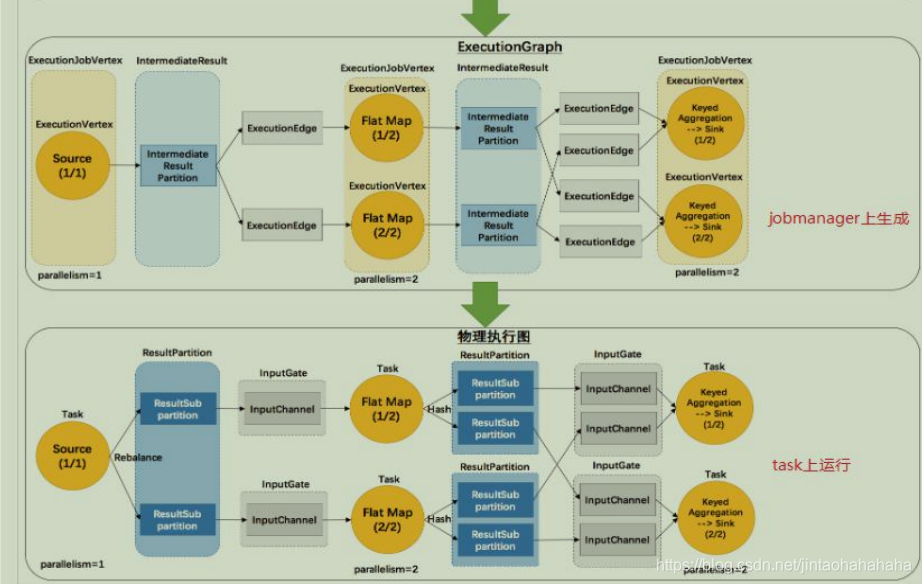

• Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph-> 物理执行图

Ø StreamGraph:是根据用户通过 Stream API 编写的代码生成的最初的图。用来表示程序的拓扑结构。

Ø JobGraph:StreamGraph经过优化后生成了 JobGraph,提交给 JobManager 的数据结构。主要的优化为,将多个符合条件的节点 chain 在一起作为一个节点

Ø ExecutionGraph:JobManager 根据 JobGraph 生成ExecutionGraph。ExecutionGraph是JobGraph的并行化版本,是调度层最核心的数据结构。

Ø 物理执行图:JobManager 根据 ExecutionGraph 对 Job 进行调度后,在各个TaskManager 上部署 Task 后形成的“图”,并不是一个具体的数据结构。

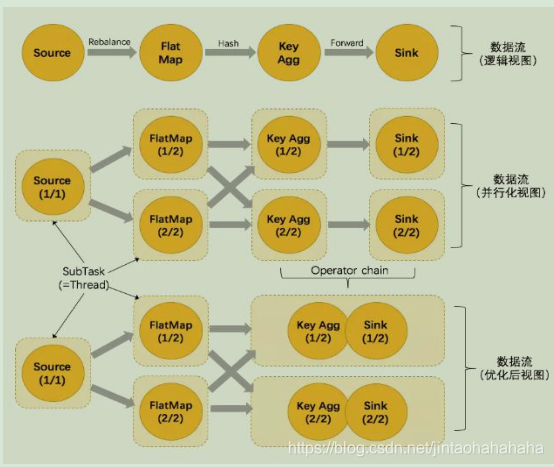

从上图我们可以看出aggregation和sink两个步骤合并了,那么为什么会合并呢,这就引出了数据传输形式。

数据传输形式

• 一个程序中,不同的算子可能具有不同的并行度

• 算子之间传输数据的形式可以是 one-to-one (forwarding) 的模式也可以是redistributing 的模式,具体是哪一种形式,取决于算子的种类

Ø One-to-one(不涉及shuffle过程):stream维护着分区以及元素的顺序(比如source和map之间)。这意味着map 算子的子任务看到的元素的个数以及顺序跟 source 算子的子任务生产的元素的个数、顺序相同。map、fliter、flatMap等算子都是one-to-one的对应关系。

Ø Redistributing(涉及shuffle过程):stream的分区会发生改变。每一个算子的子任务依据所选择的transformation发送数据到不同的目标任务。例如,keyBy 基于 hashCode 重分区、而 broadcast 和 rebalance 会随机重新分区,这些算子都会引起redistribute过程,而 redistribute 过程就类似于 Spark 中的 shuffle 过程。

任务链(Operator Chains)

• Flink 采用了一种称为任务链的优化技术,可以在特定条件下减少本地通信的开销。为了满足任务链的要求,必须将两个或多个算子设为相同的并行度,并通过本地转发(local forward)的方式进行连接

• 相同并行度的 one-to-one 操作,Flink 这样相连的算子链接在一起形成一个 task,原来的算子成为里面的 subtask

• 并行度相同、并且是 one-to-one 操作,两个条件缺一不可