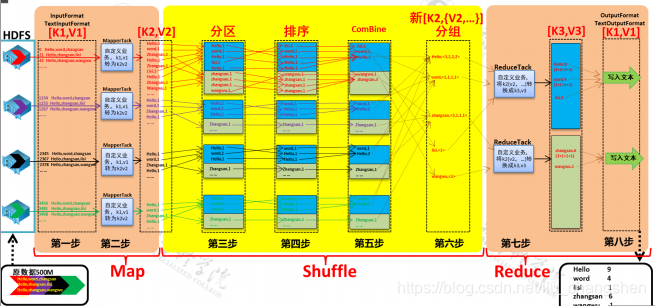

图示:

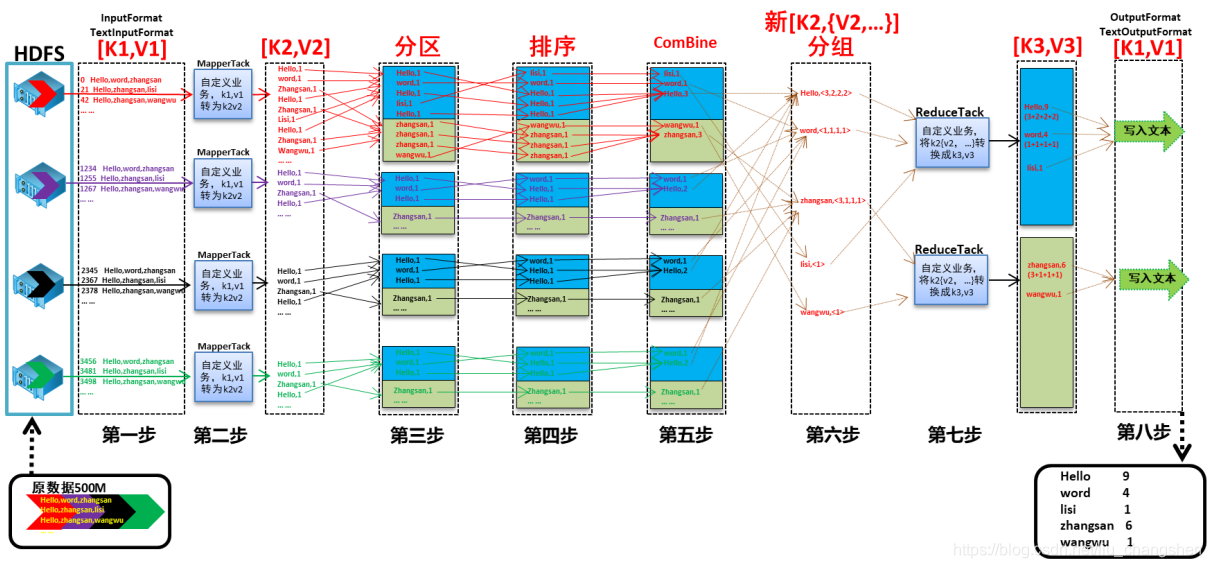

第1步:InputFormat

InputFormat 到HDFS上读取数据,将数据传给Split

第2步:Split

Split将数据进行逻辑切分,将数据传给RR

第3步:RR

RR:将传入的数据转换成一行一行的数据,输出行首字母偏移量和偏移量对应的数据,将数据传给MAP

第4步:MAP

MAP:根据业务需求实现自定义代码,将数据传给Shuffle的partition

第5步:partition

partition:按照一定的分区规则,将key value的list进行分区.将数据传给Shuffle的Sort

第6步:Sort

Sort:对分区内的数据进行排序,将数据传给Shuffle的combiner

第7步:combiner

combiner:对数据进行局部聚合.将数据传给Shuffle的Group

第8步:Group

Group:将相同key的key提取出来作为唯一的key,将相同key对应的value获取出来作为value的list,将数据传给Reduce

第9步:Reduce

Reduce:根据业务需求进行最终的合并汇总,将数据传给outputFormat

第10步:outputFormat

outputFormat:将最终的数据写入HDFS

在代码中添加 job.setJarByClass(WordCountDriver.class);

打包提交(Clean Package)

MAPREDUCE程序的输入:若是一个路径,那么程序会计算路径下的所有文件。若是一个文件,那么只计算这个文件。

MAPREDUCE程序的输出:输出的路径必须不能存在

Map的数量不能人为设置,reduce的数量可以人为设置。

job.setNumReduceTasks(2);

reduce数量越多,计算速度越快。

combinner的添加

在map端局部聚和,设置reduce的class

job.setCombinerClass(WordCountReduce.class);

算法:对map输出的key 进行哈希,获取到一个哈希值,用这个哈希值与reducetask的数量取余。余几,这个数据就放在余数编号的分区(partition)中。

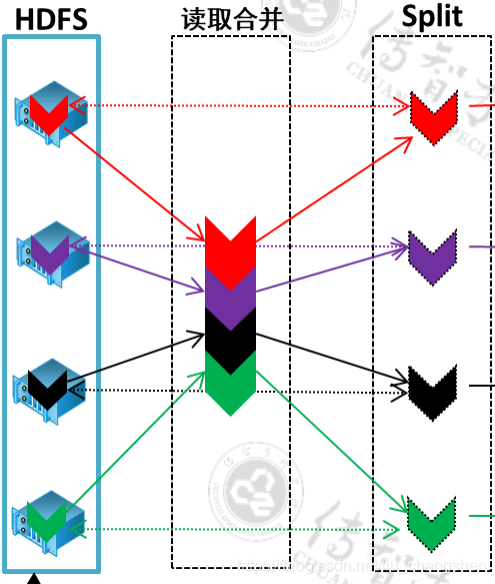

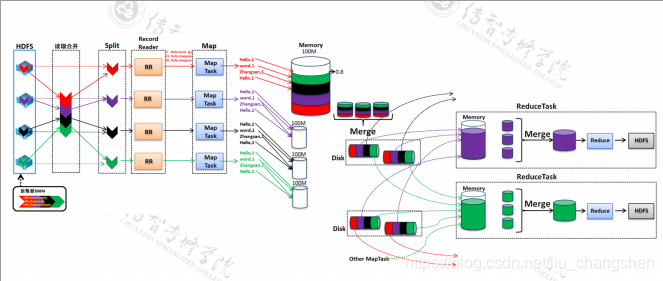

图示:

获取到读取到的数据,对数据进行逻辑切分,切分的大小是128M.这里的128 与HDFS数据块的128没有任何关系

HDFS 128 是存储层面的数据切分split128 是计算层面的128,只不过数据恰好相等。

两个128相同的原因是,一个集成程序能够正好计算一个数据块。这样做的好处是节省了计算时间

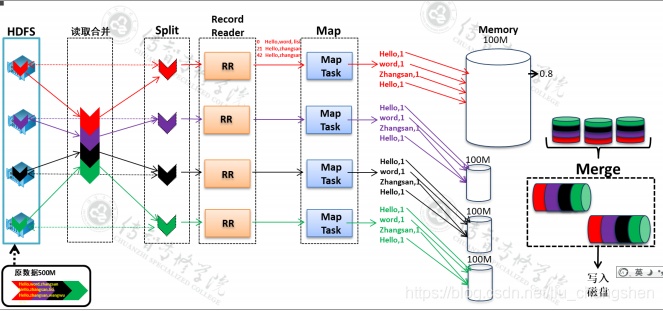

图示:

Map的输出先写入环形缓冲区(默认大小100M-可以认为调整)(可以再输出的同时写入数据),当缓冲区内的数据

达到阈值(默认0.8-可以人为调整)时,对数据进行flash。flash 出去的数据的数量达到一定量(默认4个)时,进行数据的合并。

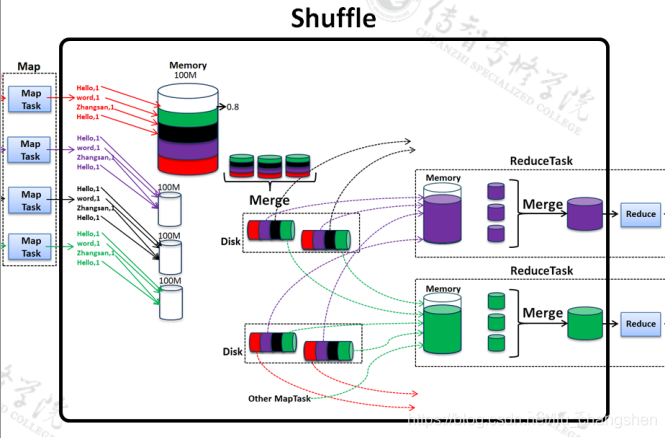

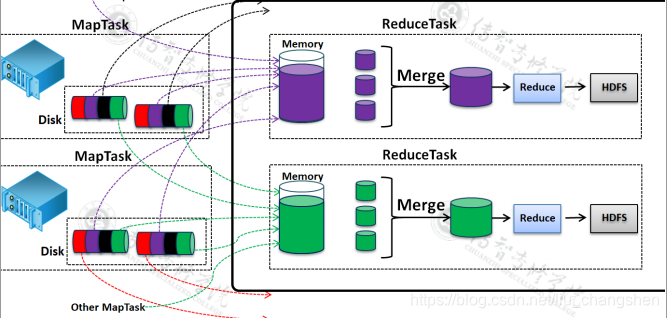

图示:

Reduce 主动发出拷贝进程(默认5个copy进程)到Map端获取数据。

获取到数据后,将数据写入内存,当数据达到阈值,将数据flash出去。

当flash出去文件达到一定的量时,进行数据的合并。最终将数据发送给reduce

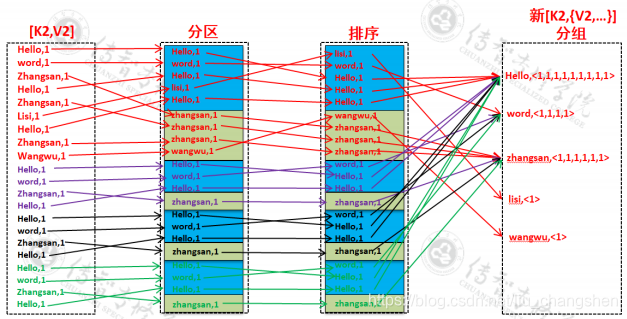

从Map的输出到reduce的输入之间的处理过程

- 流程角度

- 内存角度