代码参考:

讲解参考:

报错解决参考:

部分配置推荐

Dataloader:

number_worker:CPU核数的一半(8核CPU的number_worker为4)pin_mode:内存大的情况下可以开启

分布式代码模板

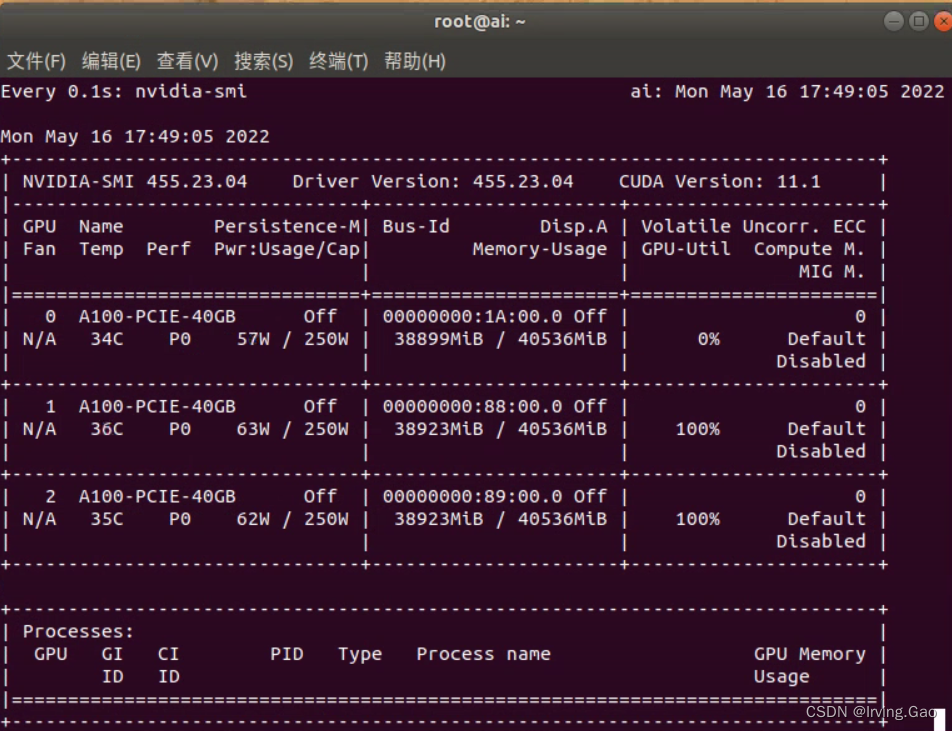

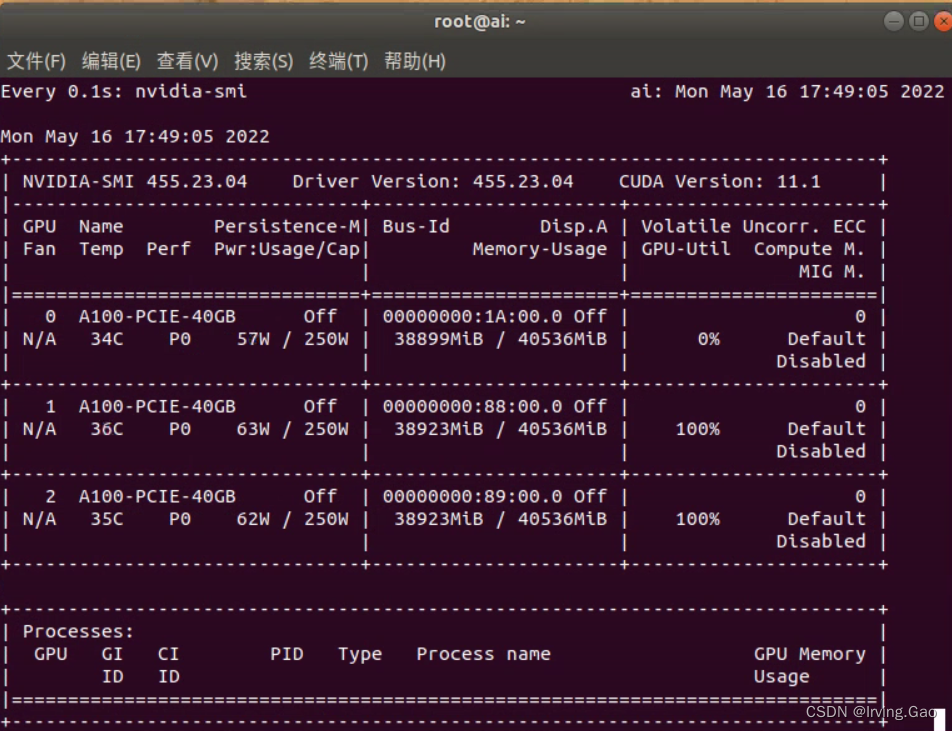

实际运行效果

训练拉满,基本能达到单卡的三倍:

多卡训练的模型,单卡环境评估或使用

版权声明:本文为qq_45779334原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。

代码参考:

讲解参考:

报错解决参考:

Dataloader:

number_worker:CPU核数的一半(8核CPU的number_worker为4)pin_mode:内存大的情况下可以开启

训练拉满,基本能达到单卡的三倍: