写在文章开头

这篇文章本质上是我的学习笔记,因此并不会纠结于一些我已经明白的知识点,所以文章的知识框架会显得不够系统。

本篇文章参考GCN这篇论文。

分类,还是定位

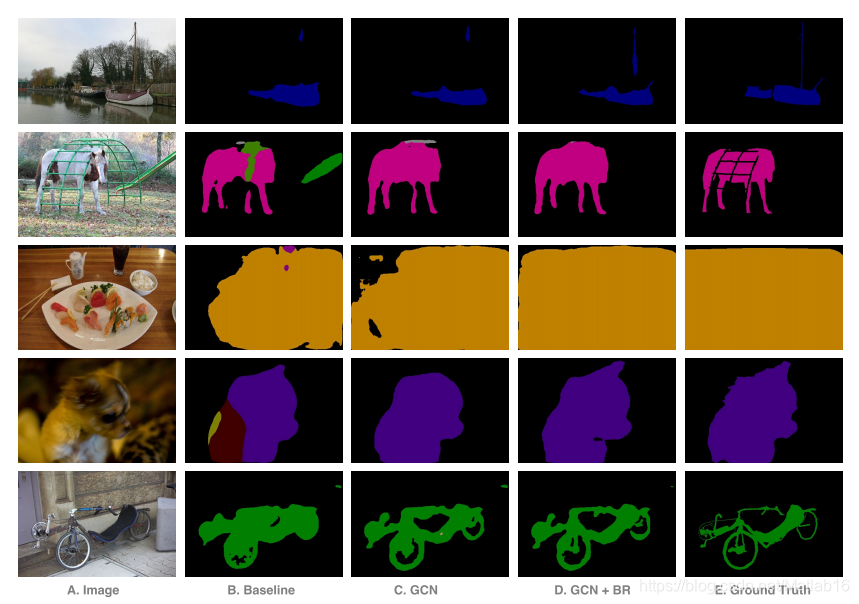

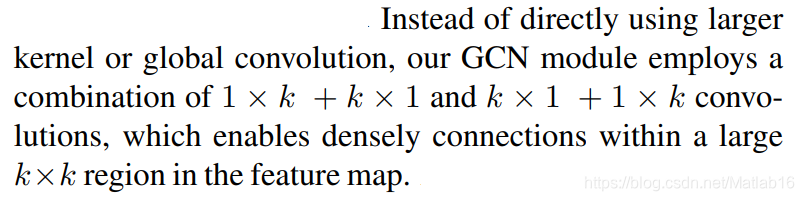

作者在介绍部分指出,语义分割领域往往面临着两个方面的权衡:分类和定位。对此,作者给出了二者的结构对比,顺带也提出了他们的模型:

上图中,红色部分可以理解为经过卷积的特征图。可以看到,分类问题实际上将特征图的所有像素进行了某种“整合”,然后再送入分类器;而定位问题或者叫图像分割问题,实际上就是将特征图的所有像素逐个送入分类器进行分类。

至于作者提出的模型,我到这里还没有看明白,先说说我暂时的理解吧:作者的模型结构中,相邻的两列像素似乎进行了类似第一幅图的“整合”操作(注意只是相邻的两列,相隔的像素列之间似乎并没有进行“整合”操作。)此外,观察所有的像素,它们又进行了类似图像分割问题的操作。所以,目前来看,我认为作者的模型实际上就是“半整合+逐分类”模式。不知道对不对,接着往下读。

事实上,GCN的设计初衷就是对分类和定位两类矛盾问题的统一。

GCN之道

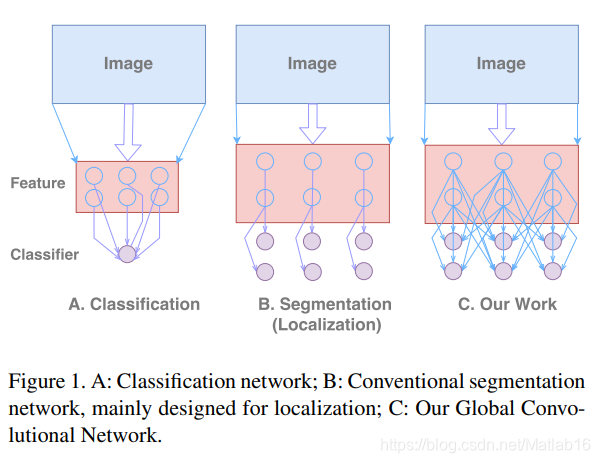

作者指出,传统的语义分割模型中,由于分类器与特征图之间仅仅是局部连接而非全局连接,因此会造成分类器没办法处理输入的各种变形形式(如输入图像的缩放变形)。针对这一点,作者引入了有效接受域(valid receptive field)的概念来进行说明,与其有关的问题可以参看下图:

接着,作者提出了他们的方法。

GCN遵从以下两个设计原则:

- 定位角度:无全连接、全局池化的全卷积结构

- 分类角度:卷积层具有较大的卷积核,并且尽可能的大

作者称,当卷积核的大小达到了特征图的大小时,此时的卷积实际上就是全局卷积,这类似于全局池化的定义。而当实现全局卷积时,此时网络的效果将与单纯的分类网络一致,这一点结合Figure 1便可以很容易理解。但需要注意的是,全局卷积的实现并不是直接给特征图添置一个大卷积核,这一点将在接下来说明。

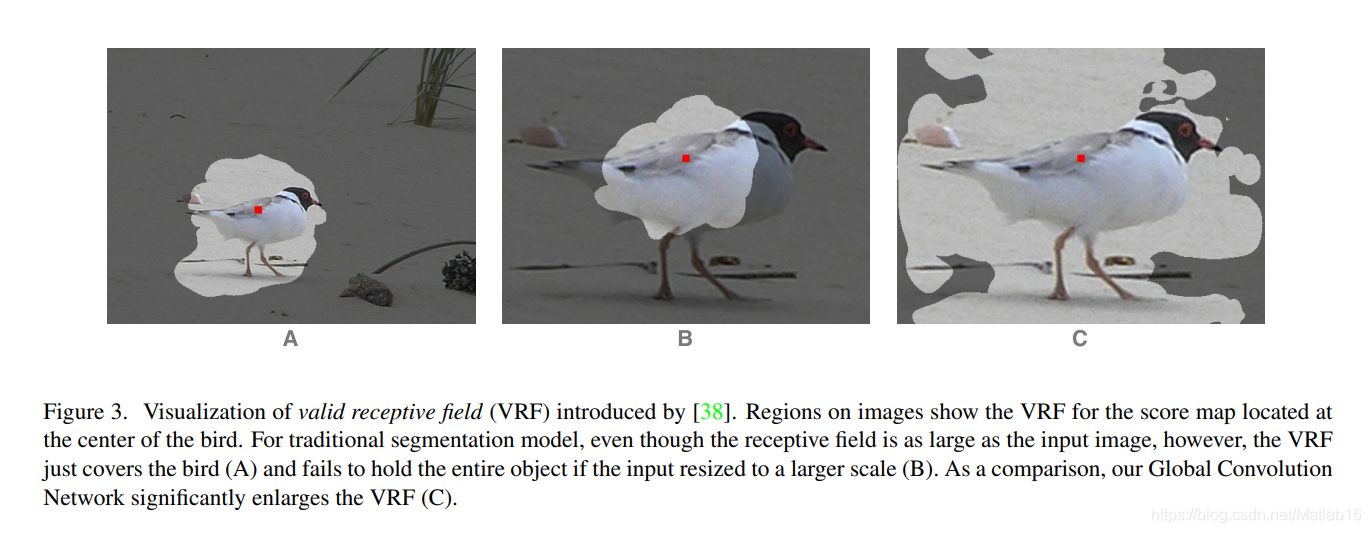

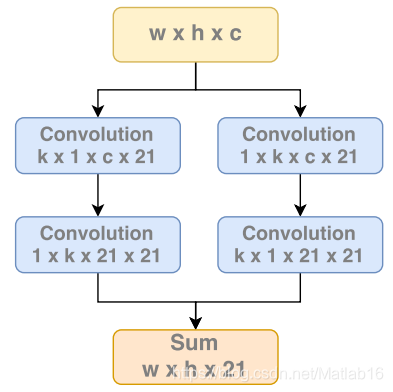

全局卷积的实现并不是直接给特征图添置一个大卷积核,相反,它使用了“分-合”的形式,原论文对此的阐述如下:

我们将这段话进行可视化,便有如下示意图:

注意,上图中张量的维度分布形式为[width , height , channel , filters]。此外,在上图示意的全局卷积中,作者并没有在卷积层后施加任何非线性函数。作者称,这种方法相比于直接施予全局卷积,让计算量得到了降低。

进一步,GCN还具备以下的设计模式:

- 模型的基本框架遵从FCN型网络结构,并且网络可用于生成semantic score maps。

- 采用对称、可分离、大规模的滤波器(减少模型参数和计算量)。

- 采用边界细化模块(boundary refinement block,BR)。(用以对物体边界的编排进行建模,需要注意的是该模块并不像条件随机场型处理方式那样是与网络训练分离的,相反,BR模块是端到端训练的结果。)

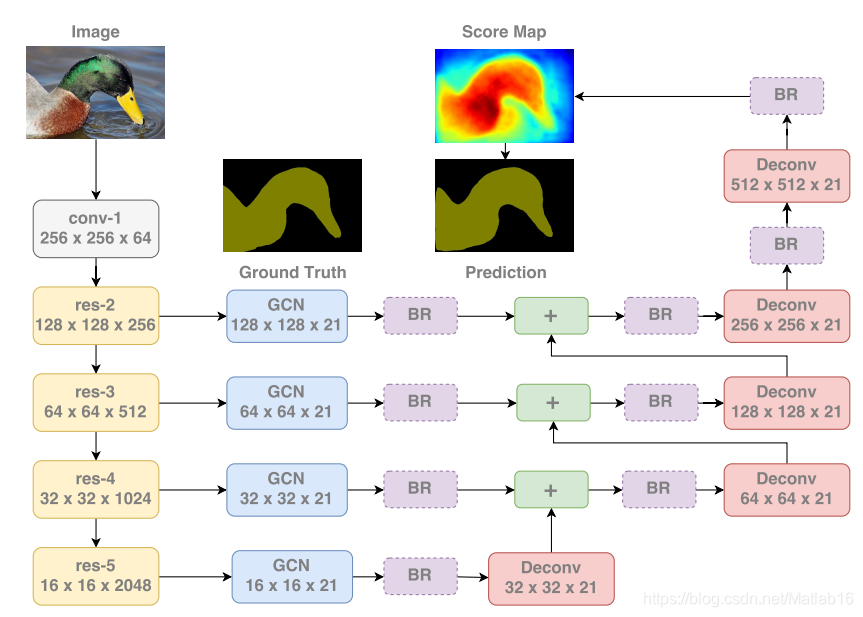

具体来说,GCN的总体网络结构可以简单表示为ResNet-FCN4,前者作为特征网络,后者作为语义分割框架。全局卷积用以产生semantic score maps,并且低分辨率的分数图通过上采样和反卷积层后将与高分辨率的分数图进行相加,模型最终的预测输出则来自最后一层分数图与前面产生的分数图的融合结果。

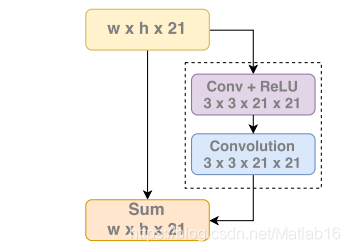

在看GCN的整体结构之前,我们先来具体说明BR模块即前面所说的边界细化模块,它的结构如下:

很容易发现,BR模块与ResNet的残差模块非常相似,在论文里作者将虚线框内的部分称作残差分枝(residual branch),并且用R ( . ) R(.)R(.)表示。此外,我们再用S SS表示未经BR模块处理的分数图(即前一个相连的GCN模块生成的分数图,见模型整体结构图)。那么,基于上述符号定义,作者给出了经过提炼(refine)后的分数图S ^ \hat{S}S^(即BR模块所生成的分数图)表达式:S ^ \hat{S}S^=S SS+R ( S ) R(S)R(S)。

接下来便是GCN的整体长相:

总结

对于GCN论文的实验部分我在这里就不再赘述。说说自己的一些感想吧。总感觉许多语义分割领域许多模型的改进都是基于结构来调整,并且对于诸多操作的解释也更多是直观理解而不是定量分析,这也是语义分割论文里公式很少相对易读的原因,因为大家都把注意力放在了结构调整上了,不管这个结构在数学上是否具有可解释性,只要mIoU或其他指标高于已有模型即可。显然,模型结构谁都会调整,可是将来是否有人会从数学上来讲述语义分割的故事呢?或许有,或许没有,我们拭目以待吧。