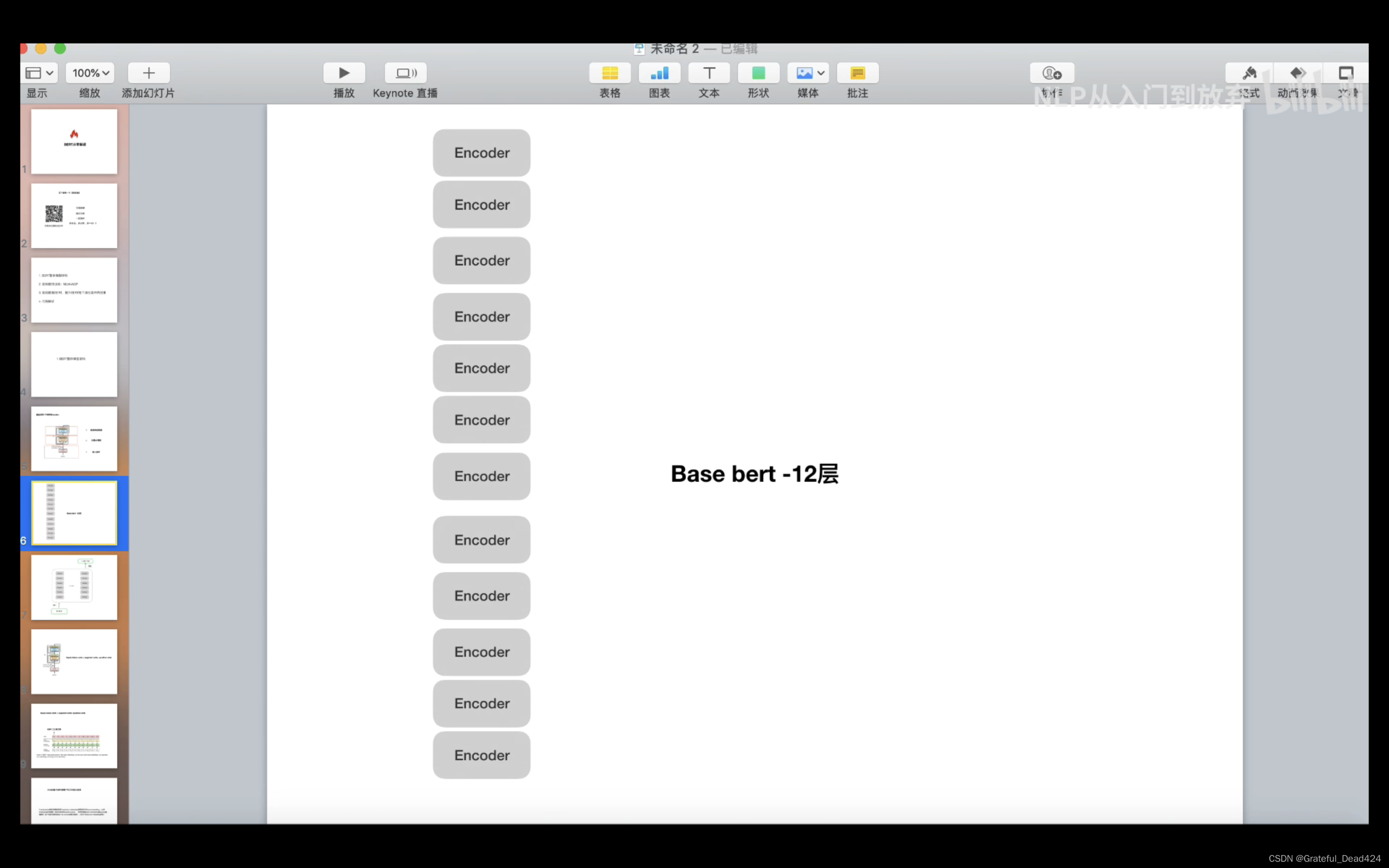

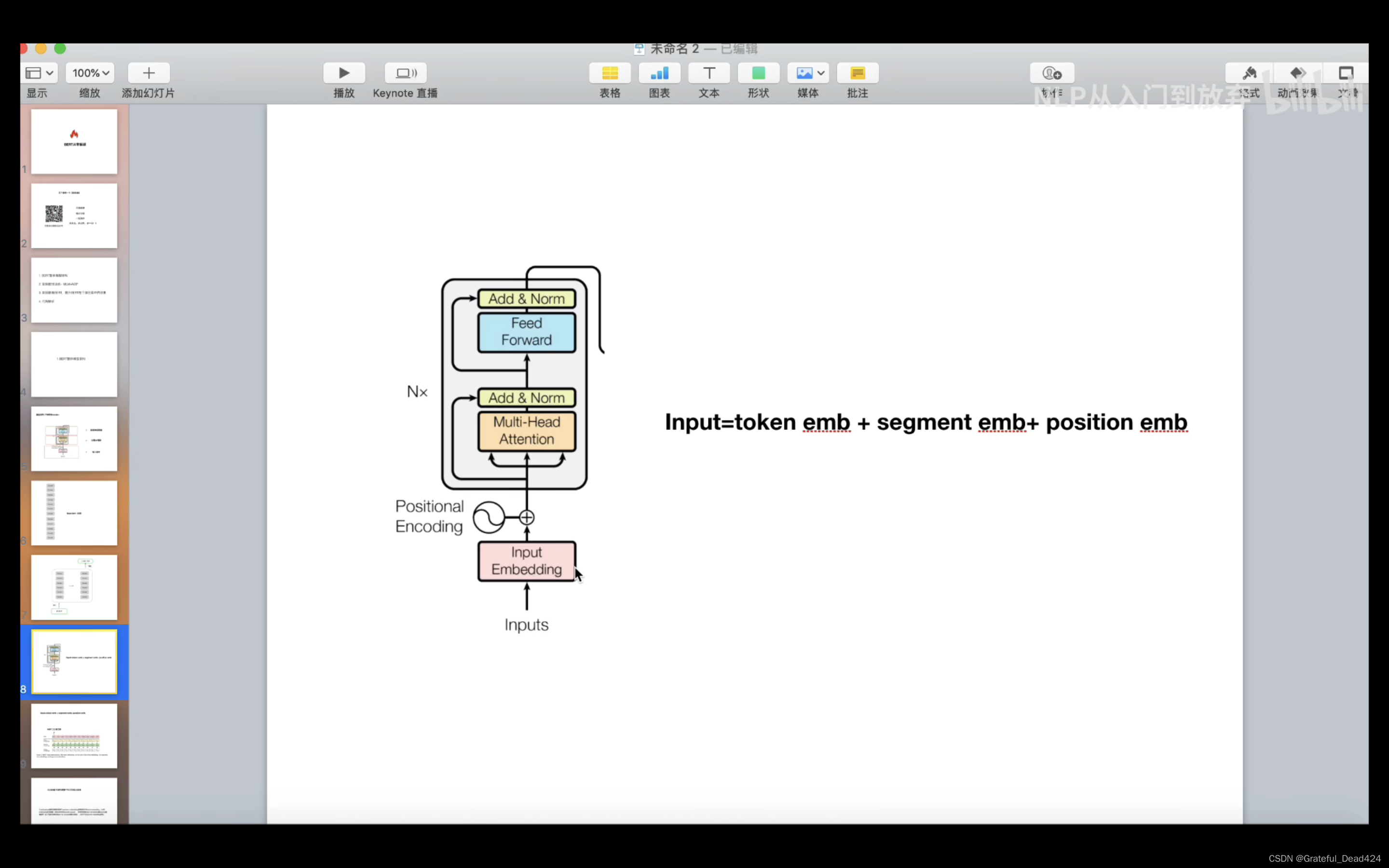

bert base使用12层encoder(不是transformer)

bert large使用24层encoder

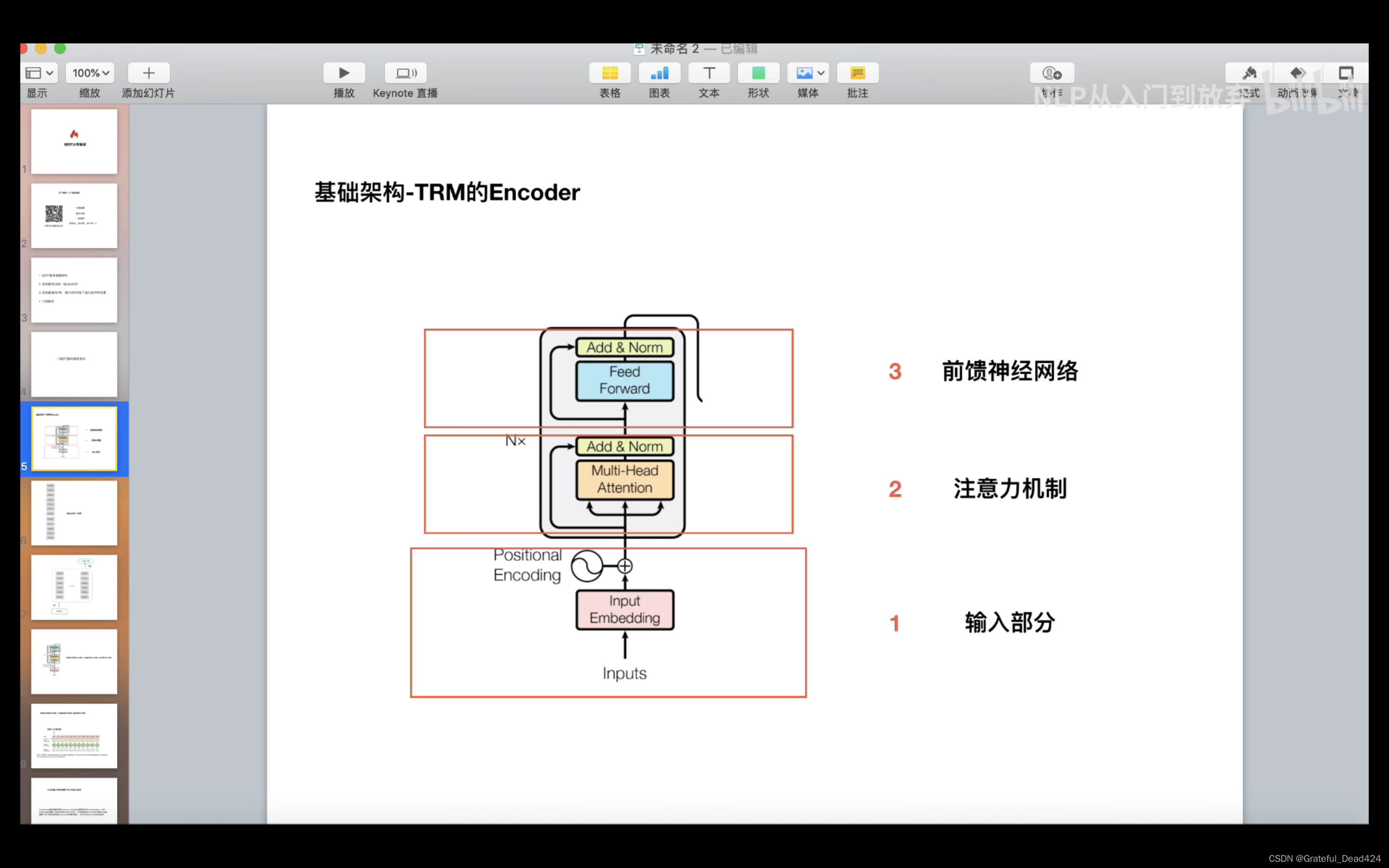

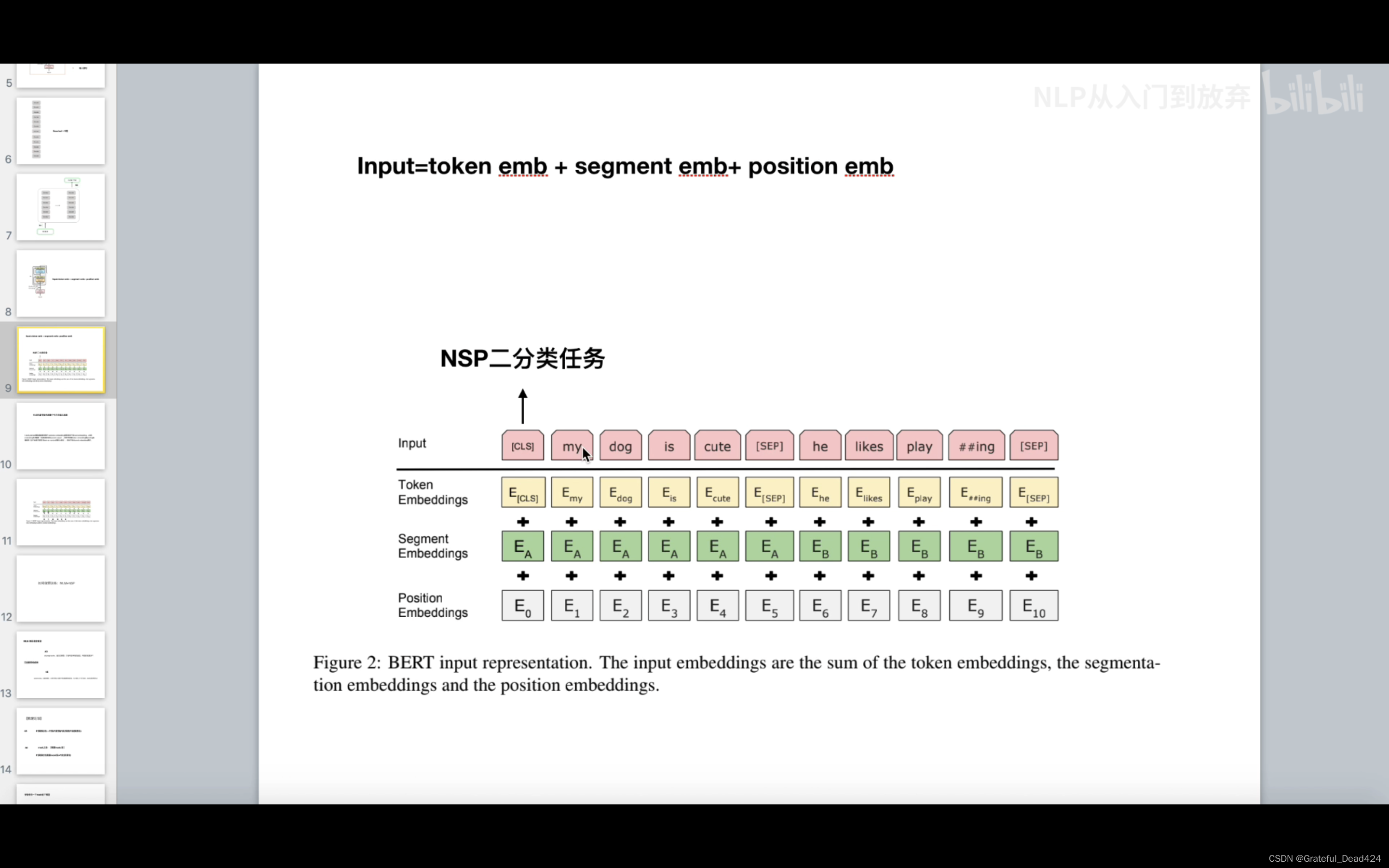

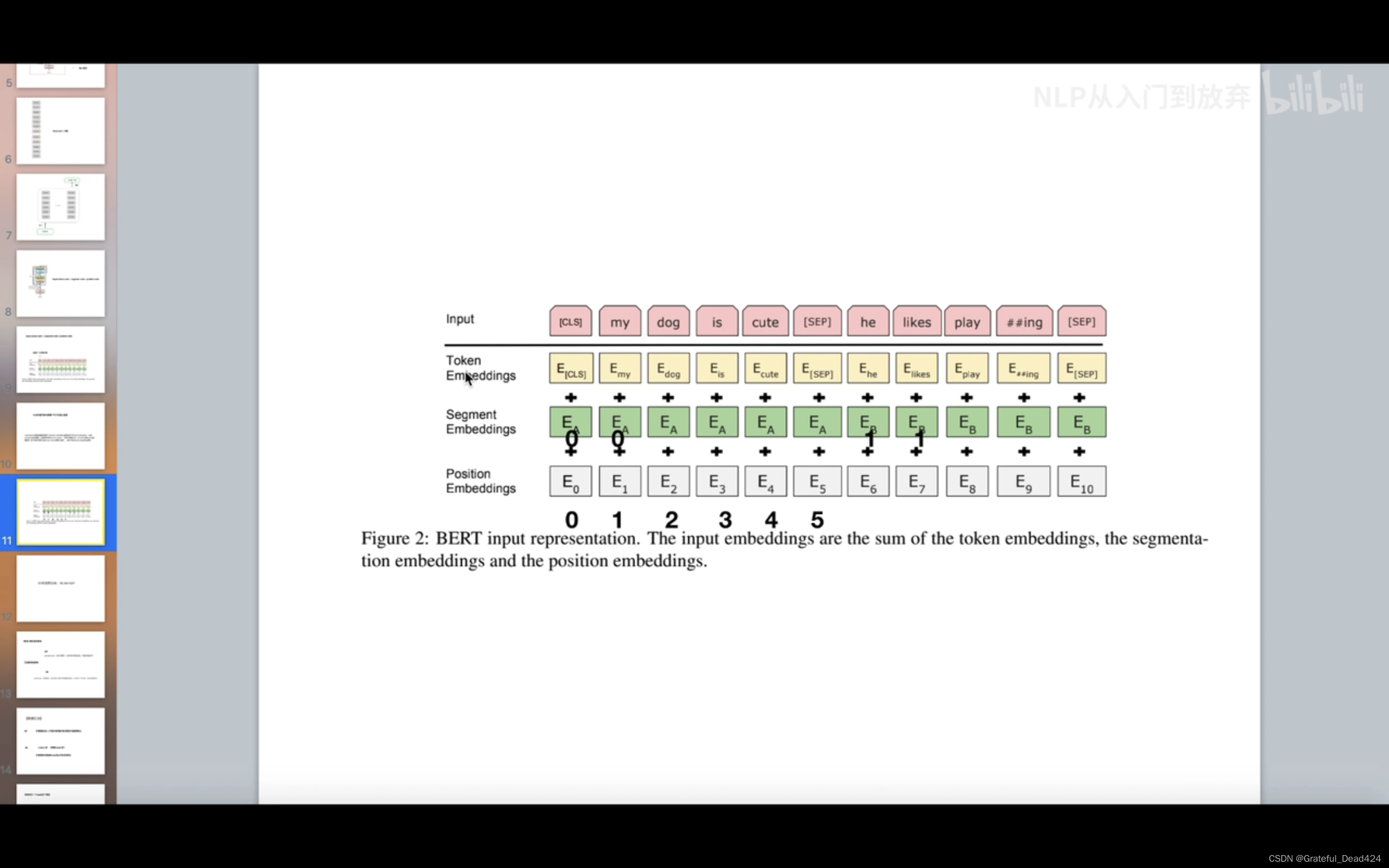

Bert输入部分详细解读

cls、sep存在因为bert预训练任务中有nsp任务(判断两个句子之间的关系)

将cls的输出向量接一个二分类器,去做一个二分类任务

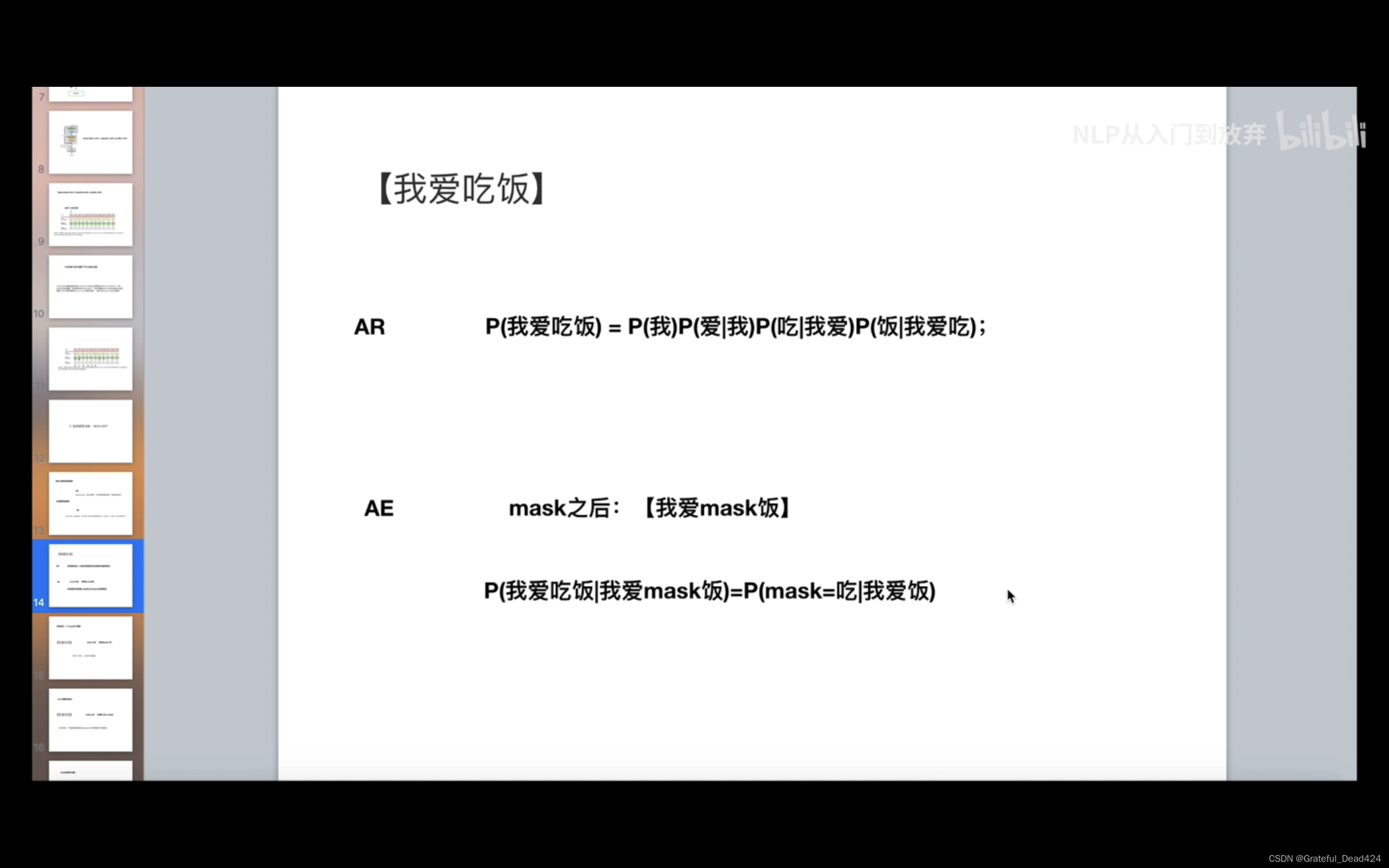

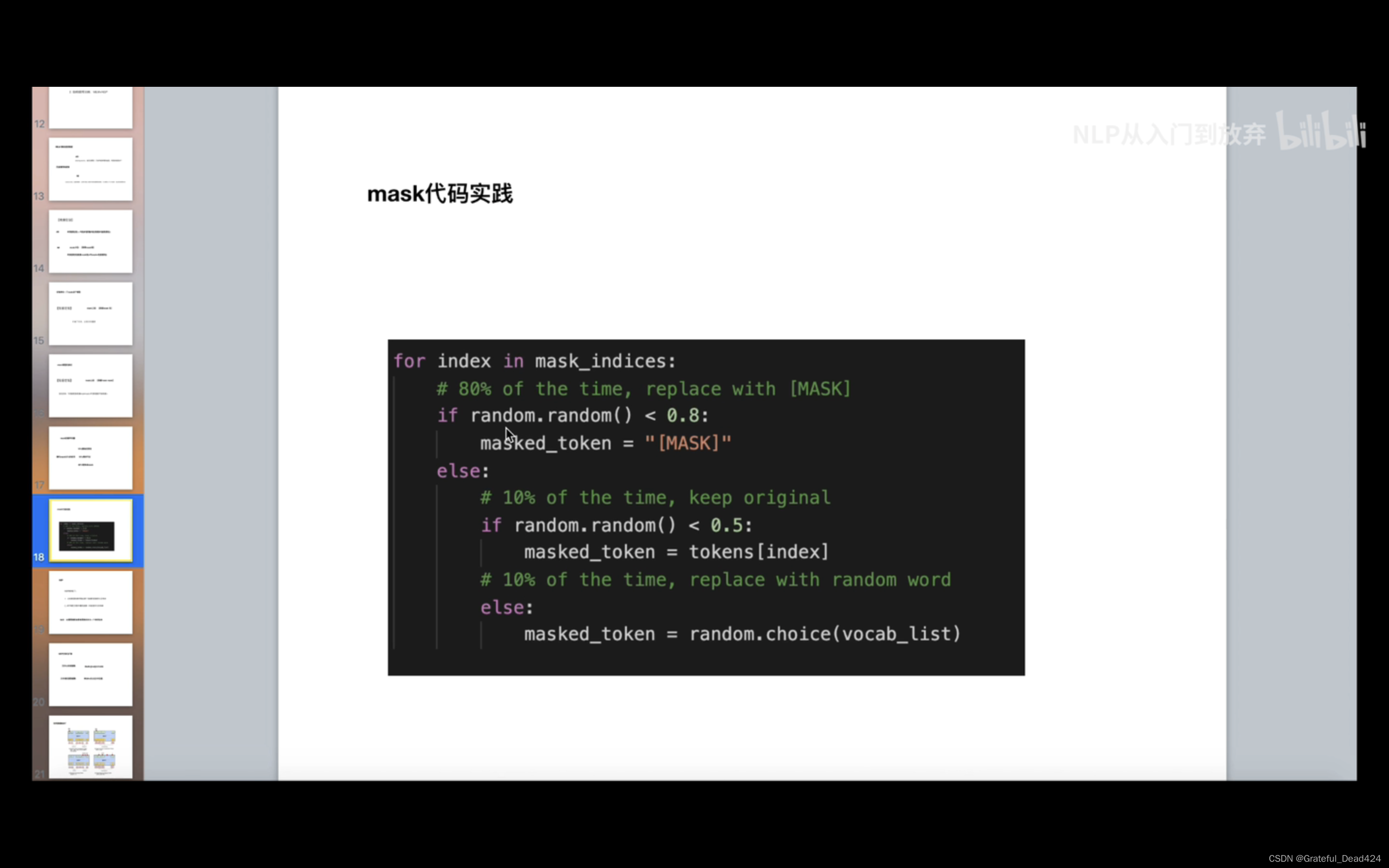

预训练之MLM详解

bert在预训练的时候,使用的是大量的无标注的语料

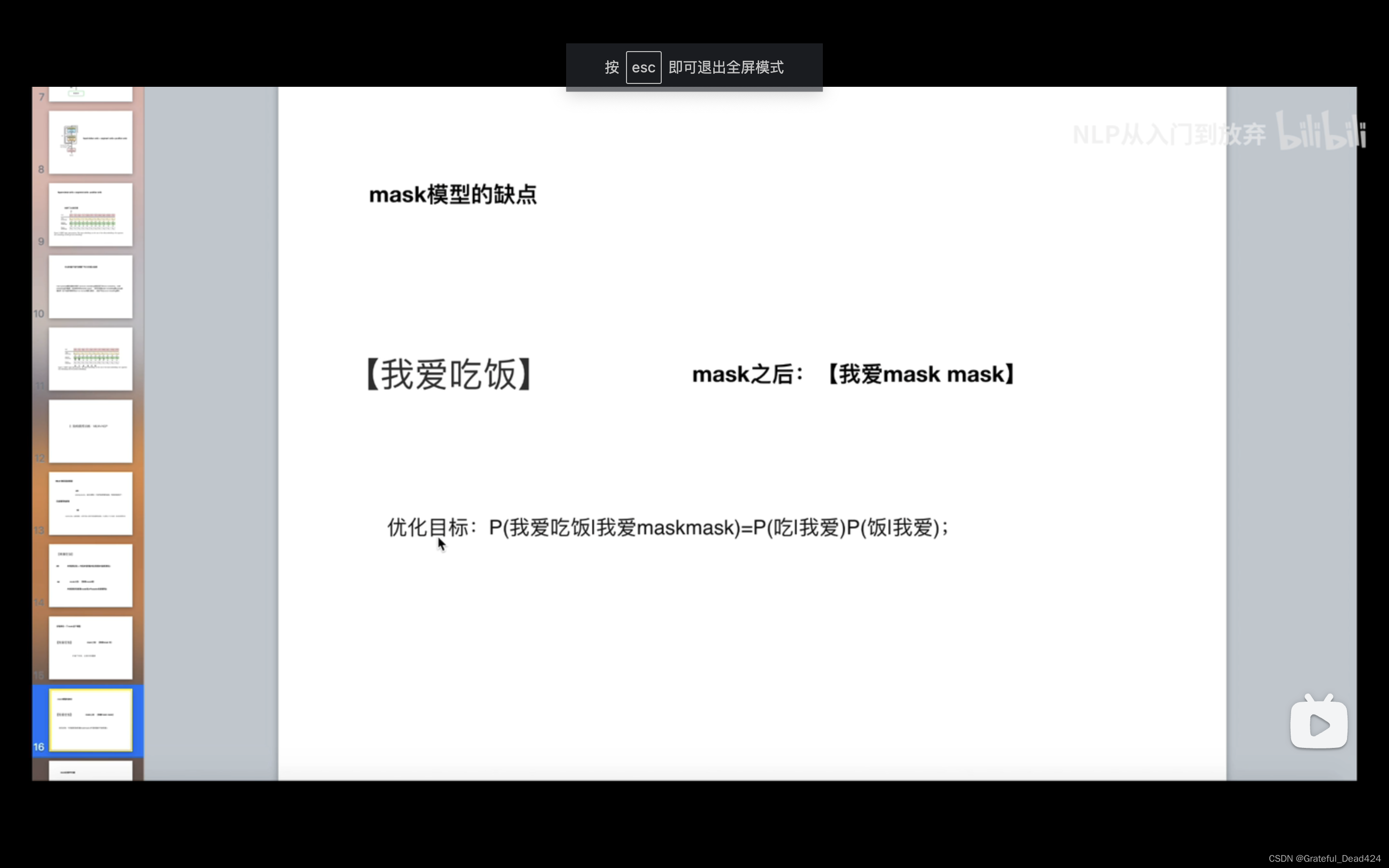

认为mask是相互独立的,然而mask不是相互独立的

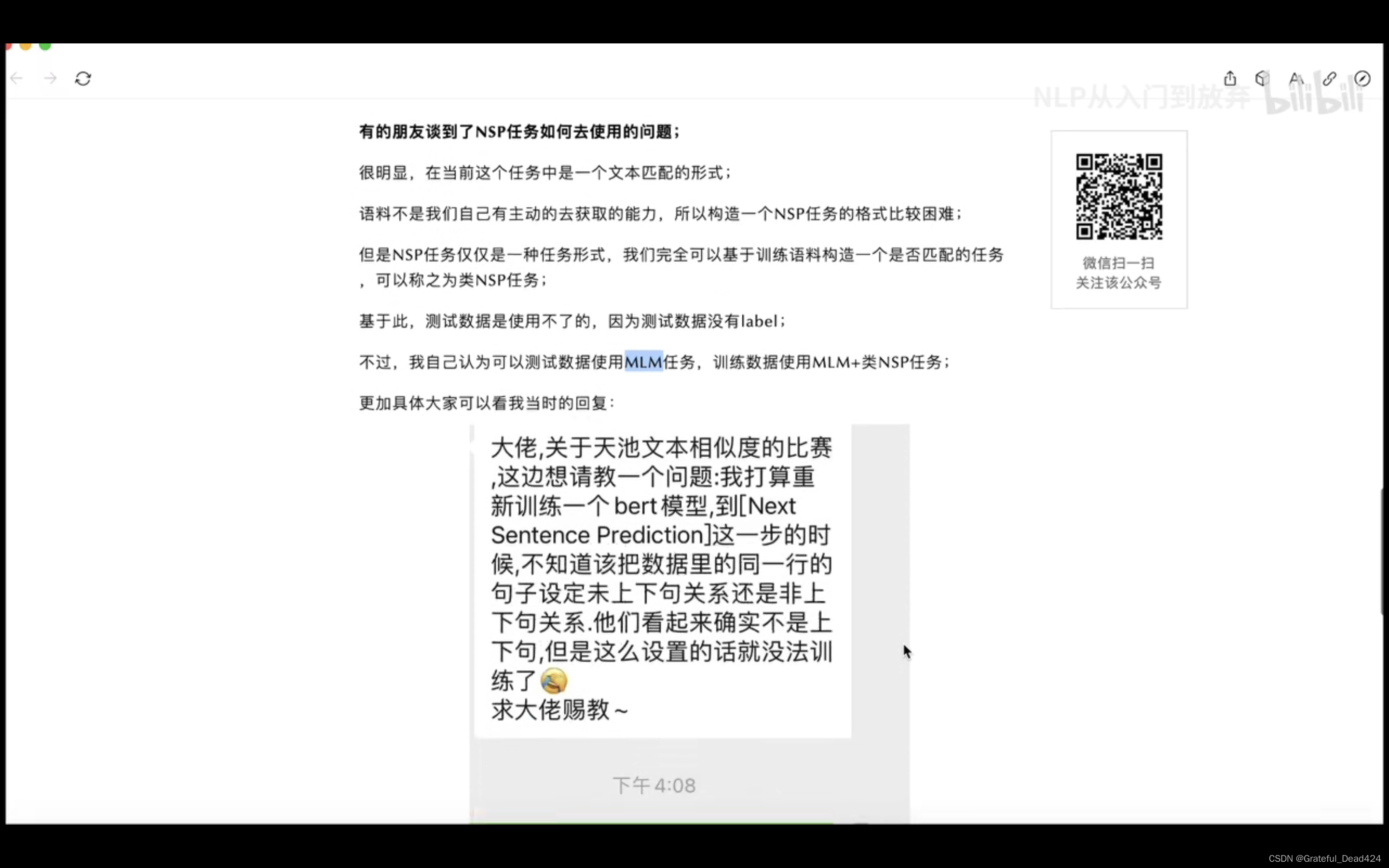

预训练之NSP任务详解

主题预测:两个样本是不是来自同一文档(很简单)

连贯性预测:两个段落是不是上下文关系

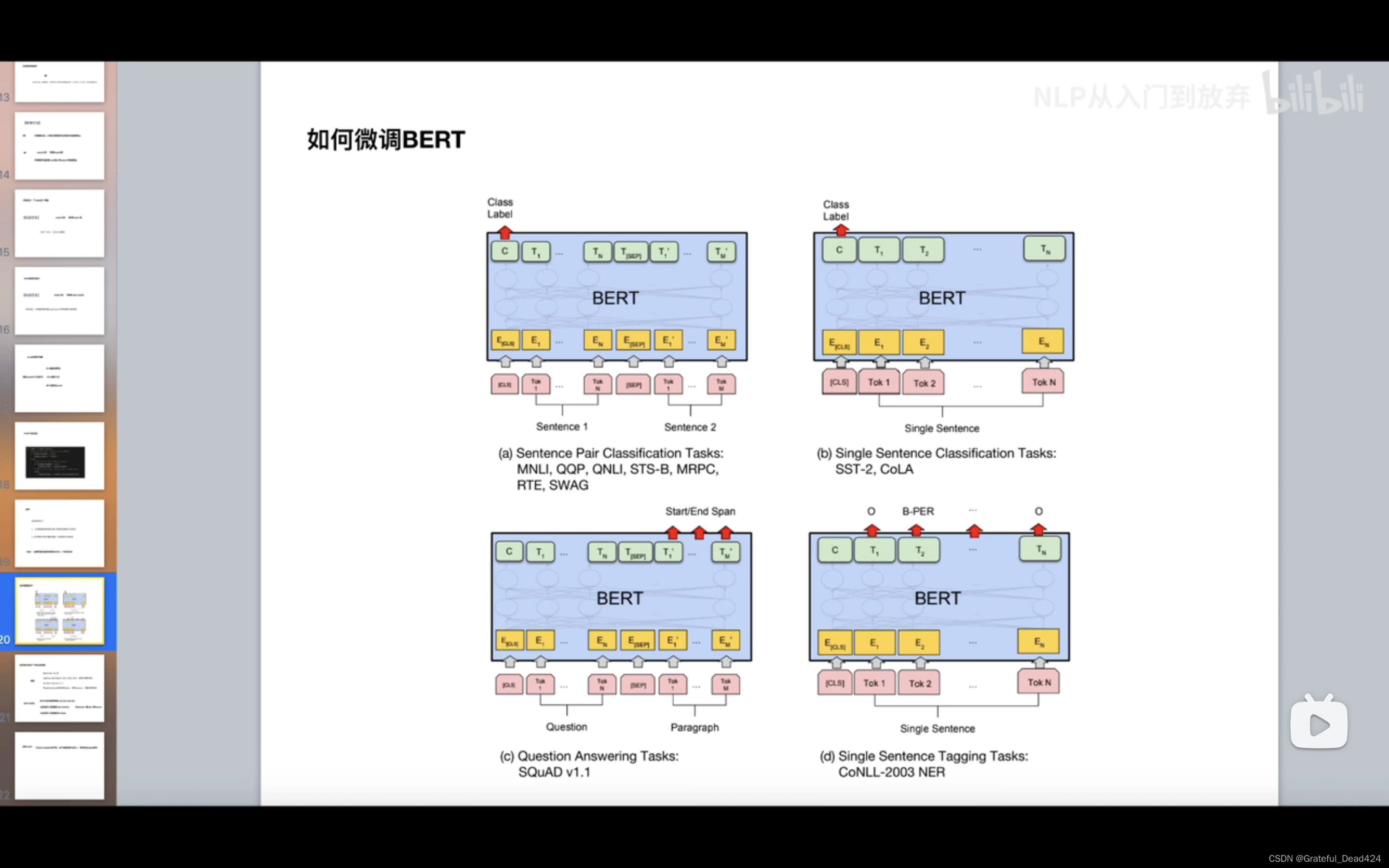

如何提升Bert下游任务表现

领域——>任务——>微调

bert是静态mask,我爱吃饭每次mask吃

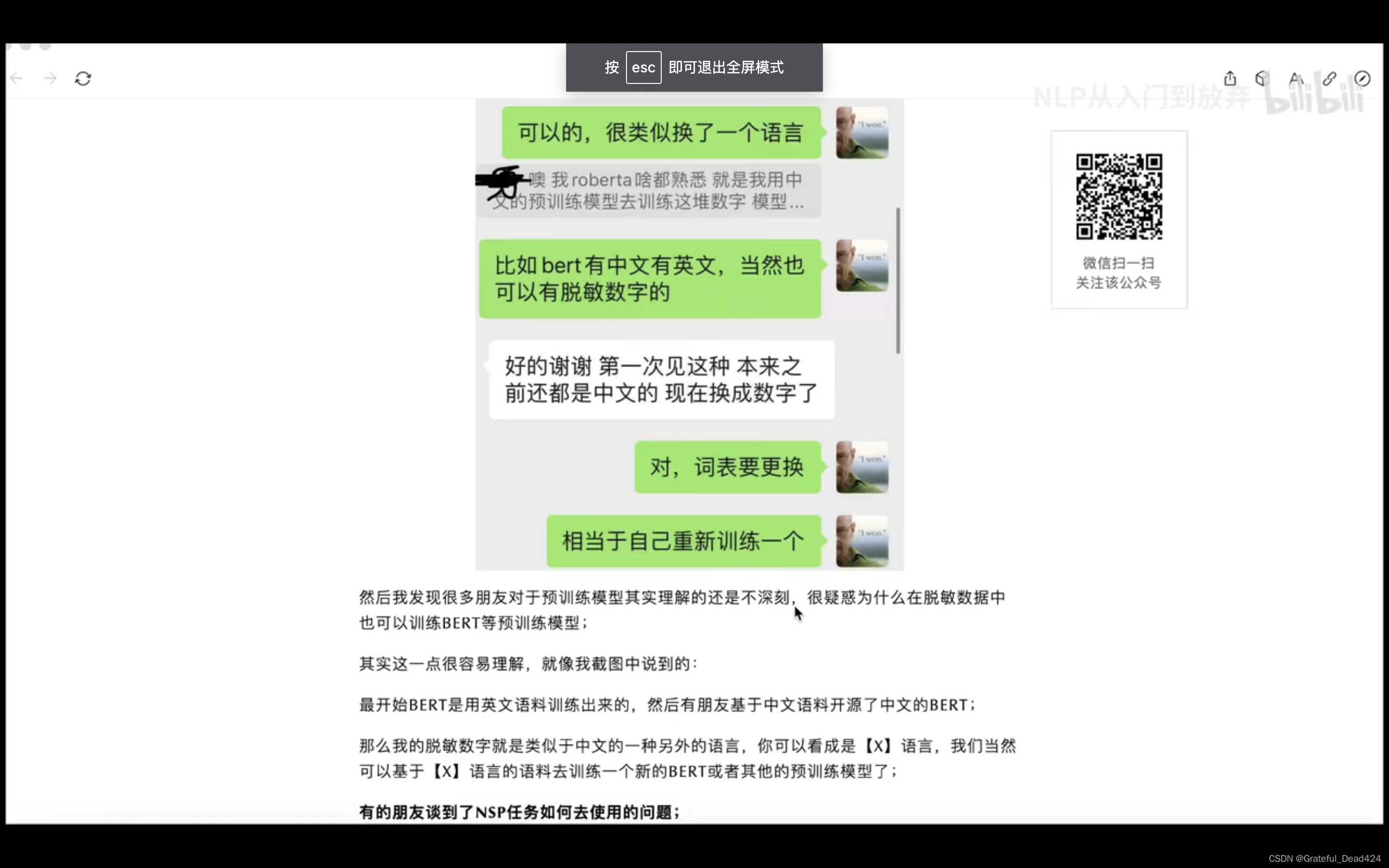

脱敏数据如何使用bert

版权声明:本文为Grateful_Dead424原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。