目录

卷积神经网络(CNN)

卷积网络,由卷积层、池化层、全连接层组成。其中卷积层与池化层配合,组成多个卷积组,逐层提取特征,最终通过若干个全连接层完成分类。

CNN通过卷积来模拟特征区分,并且通过卷积的权值共享及池化,来降低网络参数的数量级,最后通过传统神经网络完成分类等任务。

卷积:一组固定的权重和不同窗口内数据做内积

卷积网络在本质上是一种输入到输出的映射,它能够学习大量的输入与输出之间的映射关系,而不需要任何输入和输出之间的精确的数学表达式,只要用已知的模式对卷积网络加以训练,网络就具有输入输出对之间的映射能力。

CNN网络一共有5个层级结构:

- 输入层

- 卷积层

- 激活层

- 池化层

- 全连接FC层

卷积层

卷积层中每一个节点的输入只是上一层神经网络的一小块,一般为3x3或者5x5。

卷积层试图将神经网络中的每一小块进行更加深入的分析从而得到抽象程度更高的特征。

卷积层尺寸的计算原理

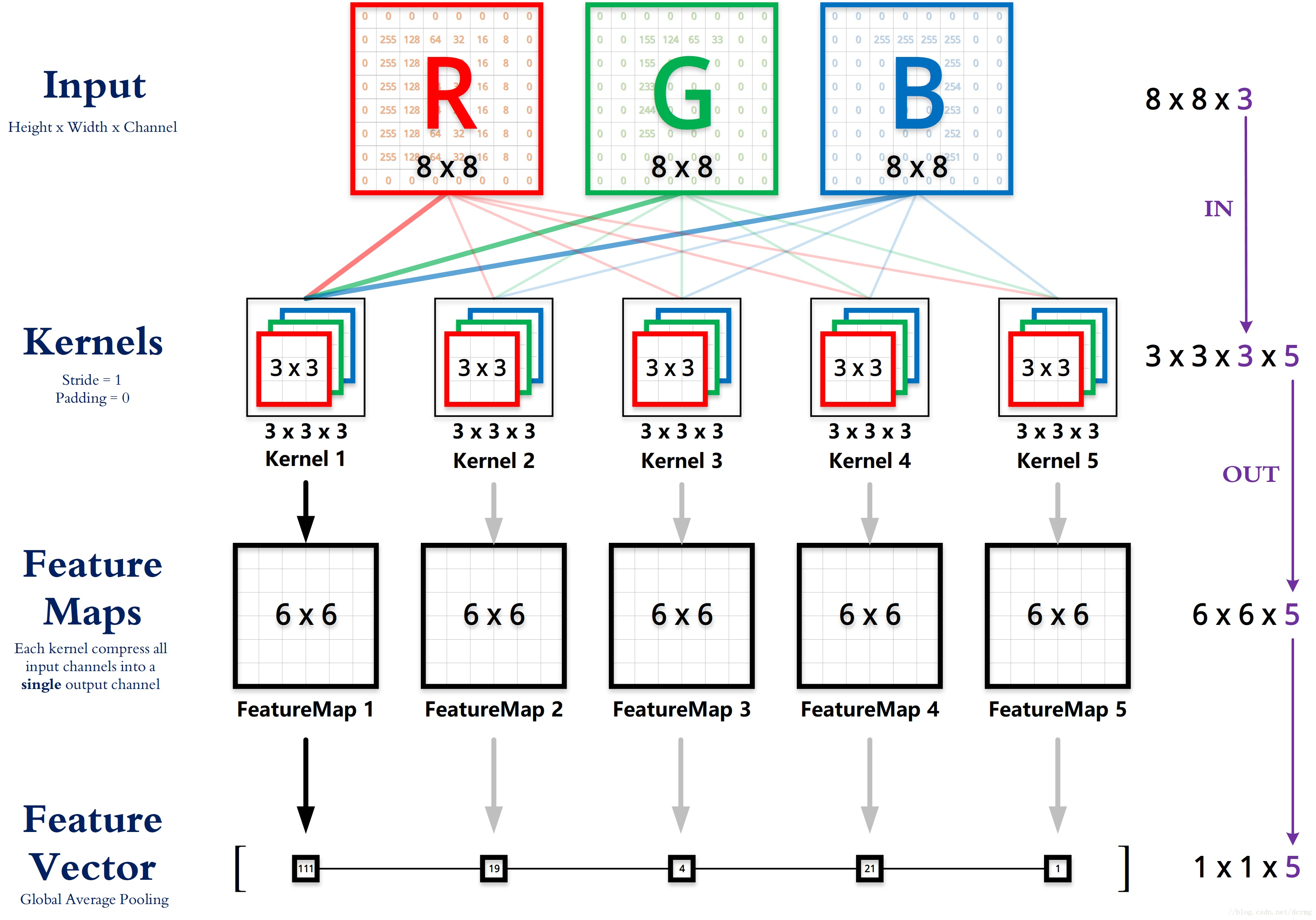

- 输入矩阵格式:四个维度,依次为:样本数、图像高度、图像宽度、图像通道数

- 输出矩阵格式:与输出矩阵的维度顺序和含义相同,但是后三个维度(图像高度、图像宽度、图像通道数)的尺寸发生变化。

- 权重矩阵(卷积核)格式:同样是四个维度,但维度的含义与上面两者都不同,为:卷积核高度、卷积核宽度、输入通道数、输出通道数(卷积核个数)

- 输入矩阵、权重矩阵、输出矩阵这三者之间的相互决定关系

- 卷积核的输入通道数(in depth)由输入矩阵的通道数所决定。(红色标注)

- 输出矩阵的通道数(out depth)由卷积核的输出通道数所决定。(绿色标注)

- 输出矩阵的高度和宽度(height, width)这两个维度的尺寸由输入矩阵、卷积核、扫描方式所共同决定。计算公式如下。(蓝色标注)

* 注:以下计算演示均省略掉了 Bias ,严格来说其实每个卷积核都还有一个 Bias 参数。

padding是增加各个边的pixels的数量,目的是保持feature map 不要太小,但也没必要超过原图的大小,所以不可以任意数量;

padding的上限是维持feature map 大小与原图大小一致,具体增加pixel的数量多少,由filter(滤波器)的尺寸【也就是卷积核的大小】和stride大小共同决定;

输出层每一个深度的计算过程。

比如,输入层是28*28*3的图像,filter为3*3*3的滤波器。那么3个通道的filter会相应的每一个通道相互独立计算,然后再将3个通道的值相加在一起。下图是每一个filter的计提的计算过程。现在就是CNN卷积的处理过程。

标准卷积计算举例

以 AlexNet 模型的第一个卷积层为例,

- 输入图片的尺寸统一为 227 x 227 x 3 (高度 x 宽度 x 颜色通道数),

- 本层一共具有96个卷积核,

- 每个卷积核的尺寸都是 11 x 11 x 3。

- 已知 stride = 4, padding = 0,

- 假设 batch_size = 256,

- 则输出矩阵的高度/宽度为 (227 - 11) / 4 + 1 = 55

1 x 1 卷积计算举例

后期 GoogLeNet、ResNet 等经典模型中普遍使用一个像素大小的卷积核作为降低参数复杂度的手段。

从下面的运算可以看到,其实 1 x 1 卷积没有什么神秘的,其作用就是将输入矩阵的通道数量缩减后输出(512 降为 32),并保持它在宽度和高度维度上的尺寸(227 x 227)。

全连接层计算举例

实际上,全连接层也可以被视为是一种极端情况的卷积层,其卷积核尺寸就是输入矩阵尺寸,因此输出矩阵的高度和宽度尺寸都是1。

总结下来,其实只需要认识到,虽然输入的每一张图像本身具有三个维度,但是对于卷积核来讲依然只是一个一维向量。卷积核做的,其实就是与感受野范围内的像素点进行点积(而不是矩阵乘法)。

附:TensorFlow 中卷积层的简单实现

def conv_layer(x, out_channel, k_size, stride, padding):

in_channel = x.shape[3].value

w = tf.Variable(tf.truncated_normal([k_size, k_size, in_channel, out_channel], mean=0, stddev=stddev))

b = tf.Variable(tf.zeros(out_channel))

y = tf.nn.conv2d(x, filter=w, strides=[1, stride, stride, 1], padding=padding)

y = tf.nn.bias_add(y, b)

y = tf.nn.relu(y)

return x

- 输入 x:[batch, height, width, in_channel]

- 权重 w:[height, width, in_channel, out_channel]

- 输出 y:[batch, height, width, out_channel]

局部感知:人的大脑识别图片的过程中,并不是一下子整张图同时识别,而是对于图片中的每一个特征首先局部感知,然后更高层次对局部进行综合操作,从而得到全局信息。

卷积层使用“卷积核”进行局部感知。举个例子来讲,一个32×32×3的RGB图经过一层5×5×3的卷积后变成了一个28×28×1的特征图,那么输入层共有32×32×3=3072个神经元,第一层隐层会有28×28=784个神经元,这784个神经元对原输入层的神经元只是局部连接,如下图所示:

通过局部感知特性,大大减少了模型的计算参数。但是仅仅这样还是依然会有很多参数。这就有了权值共享机制:

在上面的局部感知中,假设有1m的隐层神经元,每个神经元10*10的连接,这样就会有1m*10*10个参数。实际上,对于每一层来讲,所有神经元对应的权值应该是相等的,也就是说,第一个神经元的参数向量为[w1,w2,…,w100],那么其他同层的神经元也是[w1,w2,…,w100],这就是权值共享。

为什么需要权值共享呢?同一层下的神经元的连接参数只与特征提取的有关,而与具体的位置无关,因此可以保证同一层中所有位置的连接是权值共享的。例如:第一层隐层是一般用边缘检测,第二层是对第一层学到的边缘曲线组合得到一些特征,比如:角度、线形等;第三层会学到更加复杂的特征,比如:眼睛、眉毛等。对于同一层来说,他们提取特征的方式是一样的,第三层的神经元都是用来提取“眼睛”的特征,因此,需要计算的参数是一样的。

激励层

所谓激励,实际上是对卷积层的输出结果做一次非线性映射。

池化层

池化(Pooling):也称为欠采样或下采样。主要用于特征降维,压缩数据和参数的数量,减小过拟合,同时提高模型的容错性。主要有:

- Max Pooling:最大池化

- Average Pooling:平均池化

通过池化层,使得原本4*4的特征图压缩成了2*2,从而降低了特征维度。

池化层的作用

1. 不变性,更关注是否存在某些特征而不是特征具体的位置。可以看作加了一个很强的先验,让学到的特征要能容忍一些的变化。

2. 减小下一层输入大小,减小计算量和参数个数。

3. 获得定长输出。(文本分类的时候输入是不定长的,可以通过池化获得定长输出)

4. 防止过拟合或有可能会带来欠拟合。

输出层

经过前面若干次卷积+激励+池化后,终于来到了输出层,模型会将学到的一个高质量的特征图片全连接层。

当来到了全连接层之后,可以理解为一个简单的多分类神经网络(如:BP神经网络),通过softmax函数得到最终的输出。整个模型训练完毕。

从图像中提取CNN特征,VGG模型是首选算法。

VGG的特点:

- 小卷积核。作者将卷积核全部替换为3x3(极少用了1x1);

- 小池化核。相比AlexNet的3x3的池化核,VGG全部为2x2的池化核;

- 层数更深特征图更宽。基于前两点外,由于卷积核专注于扩大通道数、池化专注于缩小宽和高,使得模型架构上更深更宽的同时,计算量的增加放缓;

- 全连接转卷积。网络测试阶段将训练阶段的三个全连接替换为三个卷积,测试重用训练时的参数,使得测试得到的全卷积网络因为没有全连接的限制,因而可以接收任意宽或高为的输入。

感受野:在卷积神经网络CNN中,决定某一层输出结果中一个元素所对应的输入层的区域大小,被称作感受野receptive field。我们看这段定义非常简单,用数学的语言就是感受野是CNN中的某一层输出结果的一个元素对应输入层的一个映射。再通俗点的解释是,feature map上的一个点对应输入图上的区域。

全卷积网络(FCN)

全卷积网络(FCN)是从抽象的特征中恢复出每个像素所属的类别。即从图像级别的分类进一步延伸到像素级别的分类。

核心思想

1.不含全连接层(fc)的全卷积(fully conv)网络。可适应任意尺寸输入。

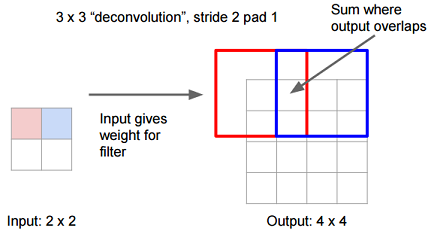

2.增大数据尺寸的反卷积(deconv)层。能够输出精细的结果。

3.结合不同深度层结果的跳级(skip)结构。同时确保鲁棒性和精确性。

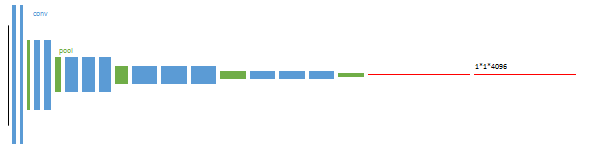

1.卷积化(convolutionalization)

分类所使用的网络通常会在最后连接全连接层,它会将原来二维的矩阵(图片)压缩成一维的,从而丢失了空间信息,最后训练输出一个标量,这就是我们的分类标签。FCN对图像进行像素级的分类,从而解决了语义级别的图像分割问题。FCN可以接受任意尺寸的输入图像,但是至少是二维的。所以,我们丢弃全连接层,换上卷积层,而这就是所谓的卷积化了。

这幅图显示了卷积化的过程,图中显示的是AlexNet的结构,简单来说卷积化就是将其最后三层全连接层全部替换成卷积层。

2.上采样(Upsampling)

采用反卷积层对最后一个卷基层的特征图(feature map)进行上采样,使它恢复到输入图像相同的尺寸,从而可以对每一个像素都产生一个预测,同时保留了原始输入图像中的空间信息,最后奇偶在上采样的特征图进行像素的分类。

输入:每个像素值等于filter的权重

输出:步长为stride,截取的宽度为pad。

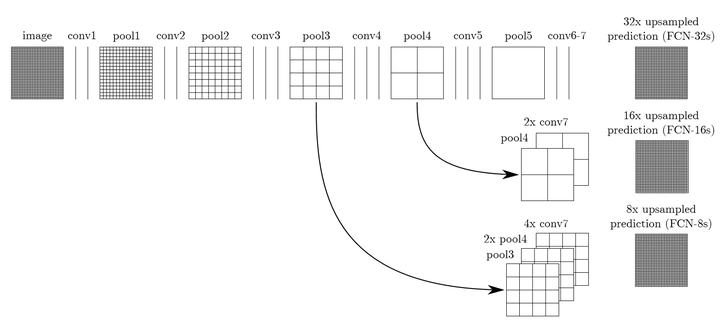

3.跳跃结构(Skip Architecture)

直接将全卷积后的结果上采样后得到的结果通常是很粗糙的。所以这一结构主要是用来优化最终结果的,思路就是将不同池化层的结果进行上采样,然后结合这些结果来优化输出,具体结构如下:

对原图进行卷积conv1、pool1后图像缩小为1/2;对图像进行第二次卷积conv2、pool2后图像缩小为1/4;对图像进行第三次卷积conv3、pool3后图像缩小为1/8,此时保留pool3的featuremap;对图像进行第四次卷积conv4、pool4后图像缩小为1/16,此时保留pool4的featuremap;对图像进行第五次卷积conv5、pool5后图像缩小为1/32,然后把原来CNN操作过程中的全连接变成卷积操作的conv6、conv7,图像的featuremap的大小依然为原图的1/32,此时图像不再叫featuremap而是叫heatmap(热力图)。

其实直接使用前两种结构就已经可以得到结果了,这个上采样是通过反卷积(deconvolution)实现的,对第五层的输出(32倍放大)反卷积到原图大小。但是得到的结果还上不不够精确,一些细节无法恢复。于是将第四层的输出和第三层的输出也依次反卷积,分别需要16倍和8倍上采样,结果过也更精细一些了。这种做法的好处是兼顾了local和global信息。

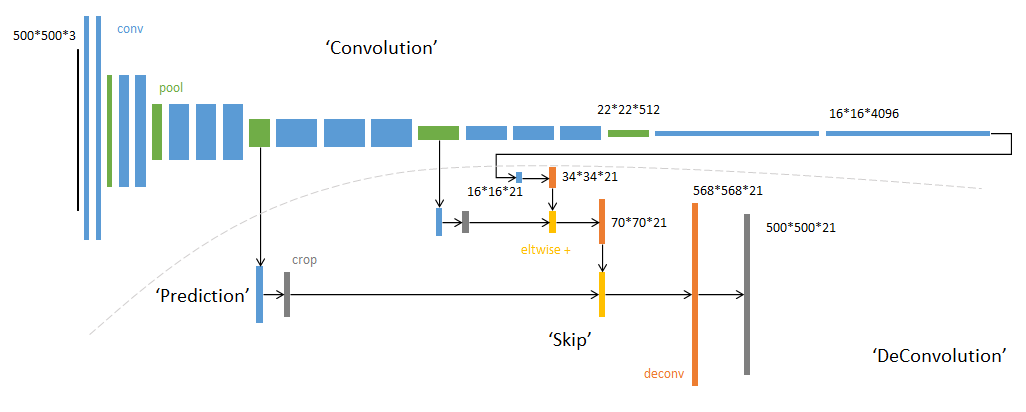

网络结构

输入可为任意尺寸图像彩色图像;输出与输入尺寸相同,深度为:20类目标+背景=21。 (在PASCAL数据集上进行的,PASCAL一共20类)

全卷积-提取特征:虚线上半部分为全卷积网络。(蓝:卷积,绿:max pooling)。对于不同尺寸的输入图像,各层数据的尺寸(height,width)相应变化,深度(channel)不变。

逐像素预测 :虚线下半部分中,分别从卷积网络的不同阶段,以卷积层(蓝色×3)预测深度为21的分类结果。其中的crop层的作用是指从图像中移除不需要的信息,只保留需要的部分。

例:第一个预测模块

输入16*16*4096,卷积模板尺寸1*1,输出16*16*21。相当于对每个像素施加一个全连接层,从4096维特征,预测21类结果。

经过多次卷积和pooling以后,得到的图像越来越小,分辨率越来越低。其中图像到 H/32∗W/32 的时候图片是最小的一层时,所产生图叫做heatmap热图,热图就是我们最重要的高维特征图,得到高维特征的heatmap之后就是最重要的一步也是最后的一步对原图像进行upsampling,把图像进行放大、放大、放大,到原图像的大小。最后的输出是21张heatmap经过upsampling变为原图大小的图片,为了对每个像素进行分类预测label成最后已经进行语义分割的图像,这里有一个小trick,就是最后通过逐个像素地求其在21张图像该像素位置的最大数值描述(概率)作为该像素的分类。因此产生了一张已经分类好的图片,如上图右侧有狗狗和猫猫的图。

训练

训练过程分为四个阶段,也体现了作者的设计思路,值得研究。

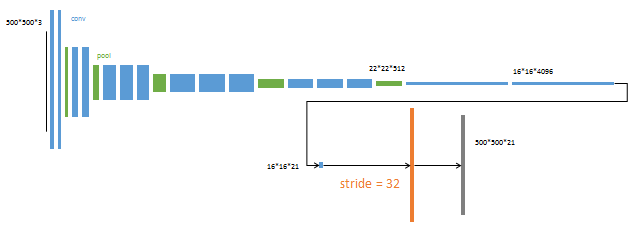

第1阶段

以经典的分类网络为初始化。最后两级是全连接(红色),参数弃去不用。

第2阶段

从特征小图(16*16*4096)预测分割小图(16*16*21),之后直接升采样为大图。

反卷积(橙色)的步长为32,这个网络称为FCN-32s。

这一阶段使用单GPU训练约需3天。

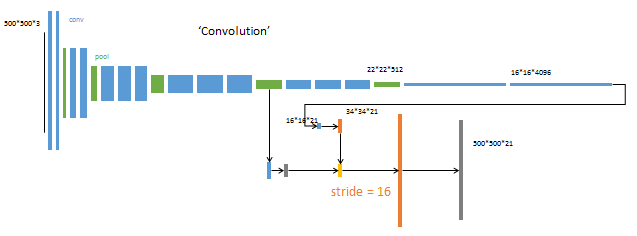

第3阶段

升采样分为两次完成(橙色×2)。

在第二次升采样前,把第4个pooling层(绿色)的预测结果(蓝色)融合进来。使用跳级结构提升精确性。

第二次反卷积步长为16,这个网络称为FCN-16s。

这一阶段使用单GPU训练约需1天。

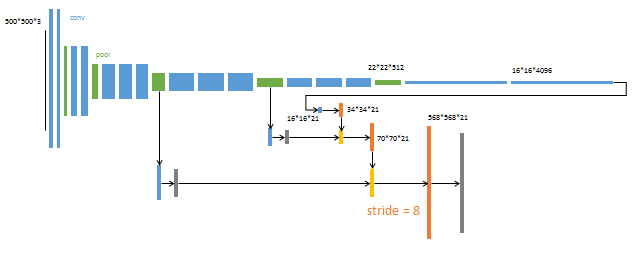

第4阶段

升采样分为三次完成(橙色×3)。

进一步融合了第3个pooling层的预测结果。

第三次反卷积步长为8,记为FCN-8s。

这一阶段使用单GPU训练约需1天。

较浅层的预测结果包含了更多细节信息。比较2,3,4阶段可以看出,跳级结构利用浅层信息辅助逐步升采样,有更精细的结果。

FCN与CNN的区别在于FCN把CNN最后的全连接层换成卷积层,输出一张已经label好的图。

扩展阅读

https://blog.csdn.net/yjl9122/article/details/70198357

https://blog.csdn.net/qq_36269513/article/details/80420363

配置caffe运行FCN:http://melonteam.com/posts/quan_juan_ji_shen_jing_wang_luo_fcn_xue_xi_bi_ji/

https://blog.csdn.net/qq_37274615/article/details/73251503