1、文件归档及透明访问

归档:Hadoop Archives

设置归档:hadoop archive -archiveName pksmall.har -p /small /pksmall

查看归档:hadoop fs -ls har:pksmall/pksmall.har

执行归档:hadoop jar hadoop-mapreduce-examples-2.6.0-cdh5.15.1.jar wordcount har:///pksmall/pksmall.har /harwcount/

我们在使用文件归档的原因虽然最终跑的还是4个文件采用透明访问的方式虽然从Mpaper来讲并没有减少压力,但是HDFS的压力小了很多因为元数据本来需要记录4个现在只需要一个,这样对于内存压力就会小很多。

2、distcp及scp

Flume–>HDFS–>MR/spark/Flink–>Hive/spark SQL/HBase

1分钟 200G

10条业务线 3副本

HDFS 删除 定时备份

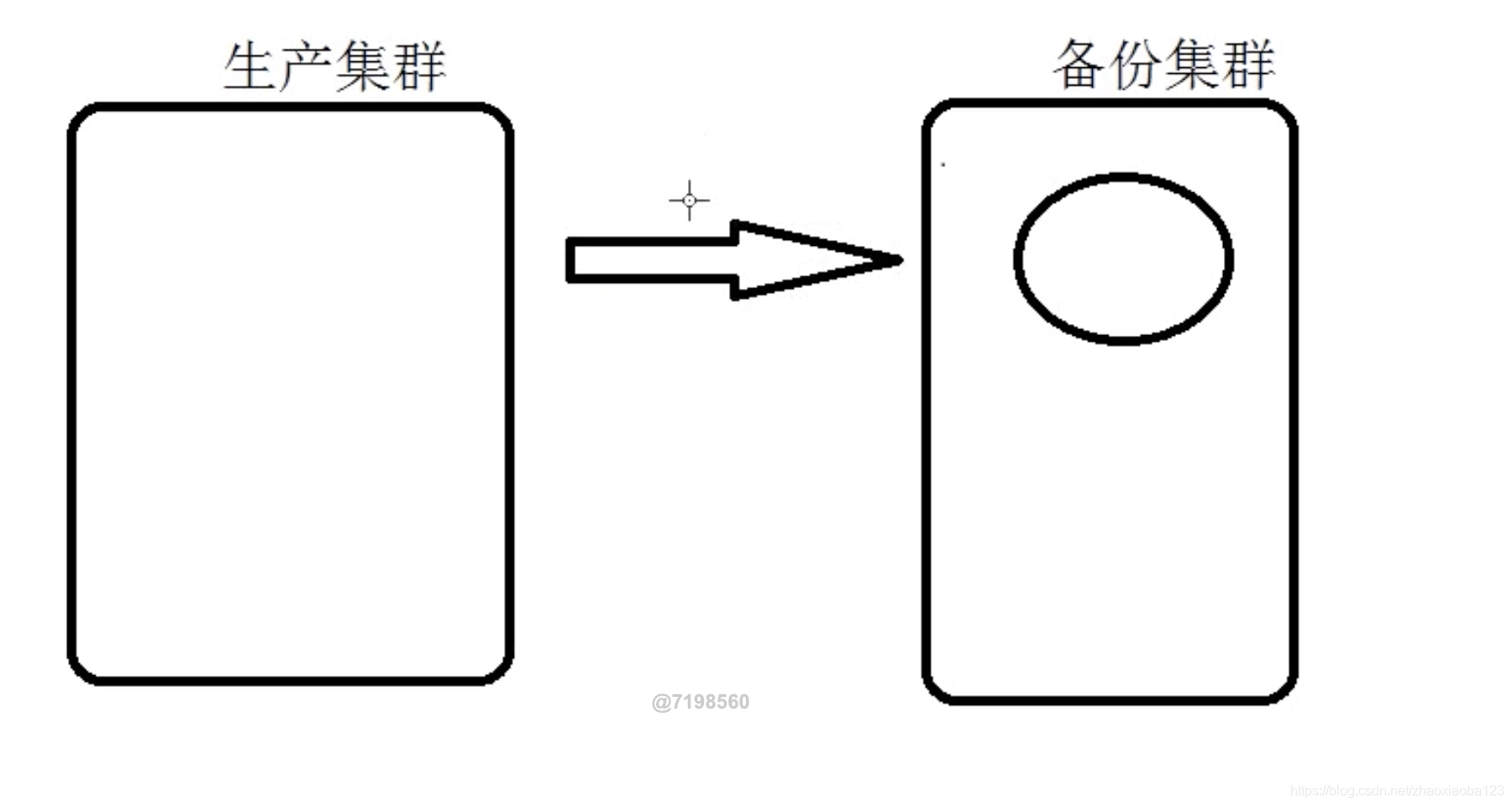

集群间备份数据传输

hadoop distcp hdfs://nn1:8020/foo/bar hdfs://nn2:8020/bar/foo

生产集群 Hive/Spark sql emp/day=20190101==> hadoop distcp ==> 备份到备份集群中去

问题来了:数据=数据(hdfs)+ 元数据(mysql)

生产 备份

1、 元数据还在,数据没了 数据还在原数据没了

2、有一天我真的真的有着需求了想用怎么办

3、回收站

core-site.xml

fs.trash.interval

2

fs.trash.checkpoint.interval

1

版权声明:本文为zhaoxiaoba123原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。