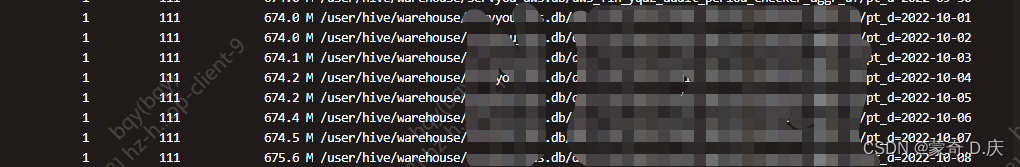

查看原表文件大小

hadoop fs -count -h /user/hive/warehouse/库名.db/表名/*

由上图可知,小文件为111,分区文件为600多m,即一个文件只有6m左右。

操作:

create table tmp_a

as

select

*

from a

将原表数据插入临时表里

hadoop fs -count -h /user/hive/warehouse/库名.db/表名/pt_d=日期

经过这个操作,小文件变成38个,每个大概占10几兆内存,比之前要好的多了。

insert overwrite table a

select

*

from tmp_a

再把数据反插回来

升级

当涉及到动态分区时

insert overwrite table tmp_a partition(pt_d)

as

select

*,pt_d

from a DISTRIBUTE BY pt_d,pmod(hash(1000*rand(1)),10)

分成10个分区,这个要看原有所占内存大小,如果分配过少,每个文件超过128M,会报错

版权声明:本文为qq_45292079原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。