一、pytorch模型转为tensorrt模型

1.yololayer.h中修改class_num

2.Cmakelist中修改cuda路径

3.build中编译生成yolov5文件

4.sudo ./yolov5 -s [.wts] [.engine] [s/m/l/x/s6/m6/l6/x6 or c/c6 gd gw] // serialize model to plan file 生成.engine文件

5.sudo ./yolov5 -d yolov5.engine …/samples 确定.engine文件正确

二、Tensorrt模型nvinfer运行 (.engine = .trt)

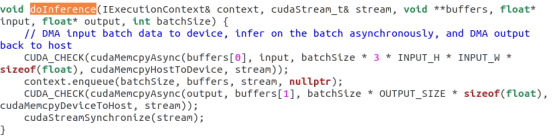

1.通过opencv取流并推理

2…engine推理流程 : blog.csdn.net/qq_33120609/article/details/96578190

三、Tensorrt模型nvinfer+deepstream运行

nvdsinfer_yolo_engine.cpp 根据网络类型创建引擎

nvdsparsebbox_Yolo.cpp yolo目标检测结果的输出

yoloPlugins.cpp 模型搭建的一些组件以及相应的实现

kernels.cu cuda核最底层的实现

trt_utils.cpp 建立tensorRT网络的部分,已经支持的部分

yolo.cpp 创建引擎、创建网络等的具体实现

deepstream_app.c pipeline的一些操作在这里

deepstream_app_config_parser.c 配置文件的解析

deepstream_app_main.c deepstream主函数

deepstream会调用动态库文件libnvdsinfer_custom_impl_Yolo.so实现网络层的搭建等功能。

deepstream_app_main.c 主要完成的功能是

1.配置文件的解析。deepstream_app_config_parser.c文件完成

2.pipeline的建立。 deepstream_app.c 文件完成

3.图像的显示。

四、参考

https://github.com/ultralytics/yolov5

https://github.com/wang-xinyu/tensorrtx.git

https://github.com/DanaHan/Yolov5-in-Deepstream-5.0

五、总结

基于以上可以达到自定义yolov5模型(pytorch->wts->engine)模型转换,并且可以通过NVIDIA AGX XAVIER 进行硬解码推理 过程没有很详细 其实每一部分的readme都介绍很清楚了