1.下载VMware

2.下载CentOs镜像

阿里云站点:阿里云开源镜像站资源目录

CentOS-7-x86_64-Minimal-1708.iso 精简版,自带的软件最少

3.安装镜像

4.安装ping命令相关包

yum install -y iputils时发现报错

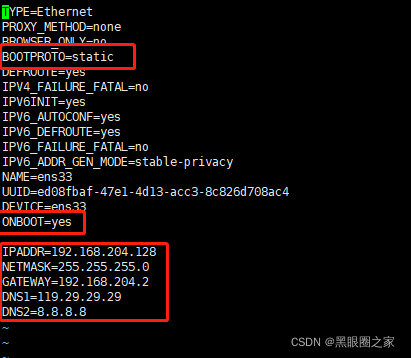

a)ip addr 命令查自己的网卡

b)cd /etc/sysconfig/network-scripts

c)ls 找到自己的网卡

d)vi 自己的网卡 ONBOOT改为yes

e)systemctl restart Network 重启网络后再安装 不再报错

5.ssh客户端使用Xshell

6.修改ip地址

a)ifconfig查看ip地址 报错: yum install -y net-tools

b)route -n查看gateway

c)vi /etc/sysconfig/network-scripts/ifcfg-ens33 编辑静态ip

IPADDR=192.168.204.128

NETMASK=255.255.255.0

GATEWAY=192.168.204.2

DNS1=119.29.29.29

DNS2=8.8.8.87.关闭防火墙

systemctl stop firewalld.service systemctl disable firewalld.service(永久关闭)

查看状态systemctl status firewalld.service

8.禁用selinux

vi /etc/selinux/config

9.设置主机名

hostnamectl set-hostname hadoop

10.主机映射

vim /etc/hosts

11.配置免密登录

a)生成密钥 ssh-keygen

b)发送密钥ssh-copy-id hadoop(主机名) 本机也需要发送

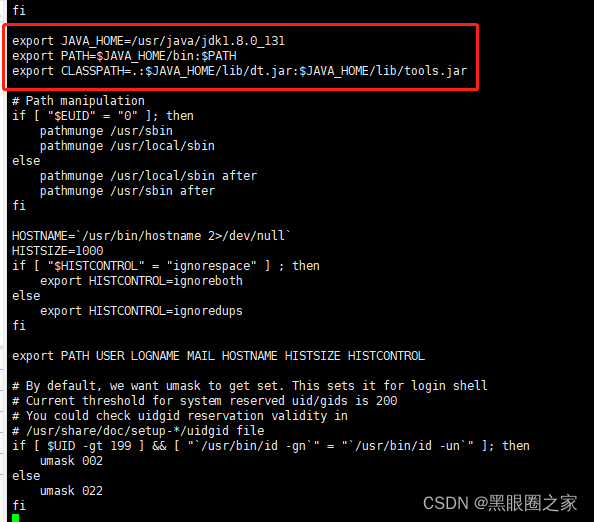

12.安装jdk

通过Xftp

tar -zxvf 压缩包名解压 到自定义目录/usr/java

修改环境变量 vi /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_131

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

使环境变量生效 source /etc/profile

java -version验证环境变量

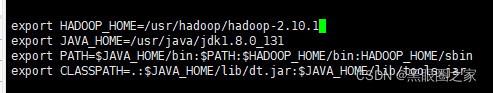

13.安装hadoop

Index of /dist/hadoop/core![]() http://archive.apache.org/dist/hadoop/core/下载hadoop包

http://archive.apache.org/dist/hadoop/core/下载hadoop包

tar -zxvf 压缩包名解压 到自定义目录/usr/hadoop

修改配置文件 所有都在{HadoopHome}/etc/hadoop

a)hadoop-env.sh

b) core-site.xml

核心配置文件

见hadoop官网文档

fs.defaultFS主节点配置名称

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>此处设置为主节点的主机名

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop:9000</value>

</property>

</configuration>

c) hdfs-site.xml

dfs.replication副本个数 根据节点个数来

见hadoop官网文档

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>d) yarn-site.xml 资源调度

见hadoop官网文档

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>e) mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

见hadoop官网文档

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>f)配置环境变量

hadoop version 验证hadoop环境变量

g)配置slaves

vi slaves

改为本机主机名 hadoop

h)环境格式化

bin/hdfs namenode -format

i)启动

sbin目录下 start-all.sh

j)验证

jps

页面验证

hdfs: namenode的ip:50070

yarn: resourcemanager的ip:8088