1.简单爬取网页

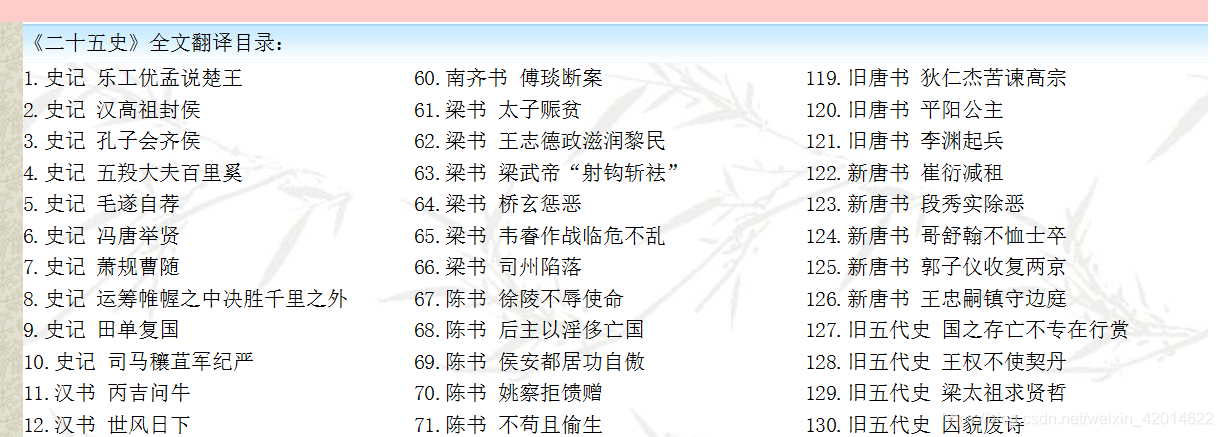

这里以爬取易文言的《二十五史》为例,共有176篇。http://ewenyan.com/contents/more/esws.html

代码如下:

import requests #导入我们需要的库

def GetName(url): #定义一个函数并且传入参数Url

resp=requests.get(url);#//获取网页上的所有信息,以文本的模型返回

resp.encoding = 'GBK'

return resp.text;#//定义一个字符串也就是我们要爬取的地址

def xieru():

fi=open('E:/transformer/wenyanwen/25shi/'+str(a)+'.txt',"wb+");#打开一个文本,以写入的方式写入二级制文本

con = GetName(url);

ss=con.encode('utf-8')#返还的文本转换编码格式

fi.write(ss);#写入打开的文本中

return 0;

for a in range(1,177):

url="http://www.ewenyan.com/articles/esws/"+str(a)+".html";

xieru();

注:

若爬取时出现编码错误,可以先查看网页的编码方式(鼠标右键–查看源文件),如下图所示。

这里的编码方式是gb2312,代码中对应改为了GBK。

结果如下:

2.字符替换

由于1中的结果包含了所有的网页信息,而我需要的只是其中的文字部分,所以需要把代码部分以及多余的信息删除。

这里用到了replace()、findall()、sub()函数

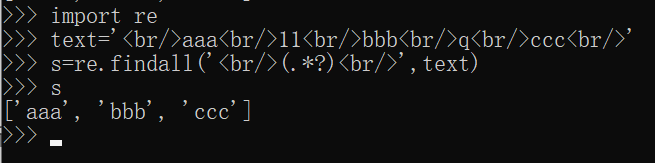

(1)findall()函数

findall()函数可以用正则表达式去找到你需要的文本信息,直接提取出来。如图所示。

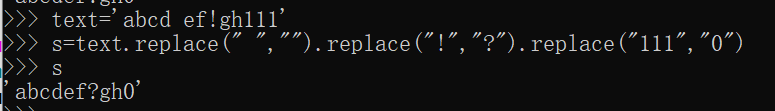

(2)replace()函数

replace()函数可以同时替换不同的字符。如图所示,把空格替换为无,“!”替换为“?”,把“111”替换为“0”。

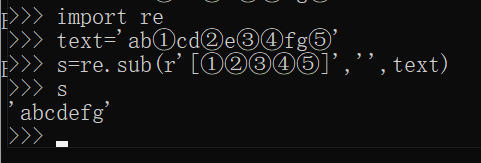

(3)sub()函数

若我们想把很多个不同的字符替换为同一个字符,那我们就可以使用sub()函数。

例如,在文本中可能会出现很多带标号①②③…的注释,我们需要把它们删除,那我就把这些注释标号都替换为空,如下图所示。

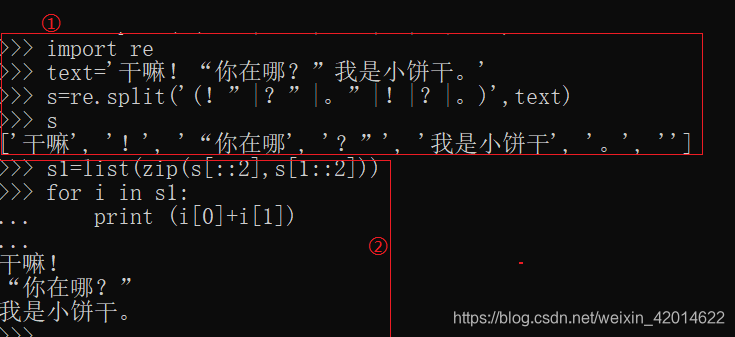

3.文本分句

在2中删除完多余的信息后,需要对文本分句。这里以(!”|?”|。”|。|?|!)进行分句。如下图所示。

框①中对文本句子进行切分,框②对切分的内容组合(句子+标点)

最终的文本如下所示。

版权声明:本文为weixin_42014622原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。