解题思路

卷积神经网络至少包含一个卷积层,且最后一层通常是全连接层;

全连接网络没有卷积层,只使用全连接层(以及非线性层)。

所以关键是理解卷积层和全连接层的区别。

全连接层

全连接,顾名思义,上一层的所有神经元要和下一层的每个神经元都链接,比如上一层有4096个神经元,下一层有10个神经元,那么计算方式如下:

所以全连接层有三个特点:

关注全局信息(每个点都和前后层的所有点链接)

参数量巨大,计算耗时

输入维度需要匹配(因为是矩阵运算,维度不一致无法计算)

卷积层

这个卷积和信号系统中的卷积不太一样,其实就是一个简单的乘加运算,比如cs231课程给出这样一个示例:

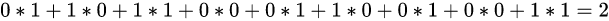

黄色区域表示卷积的感受野(3x3大小),黄色区中的红色数字,是该卷积核的参数,黑色数字是图像当前感受野的特征值,那么卷积运算的结果就是:

从这个例子中,我们可以看出卷积层的两个特性:

局部链接:当前层的神经元只和下一层神经元的局部链接(并不是全连接层的全局链接)

权重共享:神经元的参数(如上图的3*3卷积核),在整个特征图上都是共享的,而不是每个滑动窗口都不同

也正是因为这两个特性,所以卷积层相比于全连接层有如下优点:

需要学习的参数更少,从而降低了过度拟合的可能性,因为该模型不如完全连接的网络复杂。

只需要考虑中的上下文/共享信息。这个未来在许多应用中非常重要,例如图像、视频、文本和语音处理/挖掘,因为相邻输入(例如像素、帧、单词等)通常携带相关信息。

但需要注意的是,无论是全连接层,还是卷积层,都是线性层,只能拟合线性函数,所以都需要通过ReLU等引入非线性,以增加模型的表达能力。比如ReLU函数接受一个输入x,并返回{0, x}的最大值。ReLU(x) = argmax(x, 0)。

版权声明:本文为qq_39173848原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。