1. Logistic回归的优缺点

Logistic优点:

- 模型简单,速度快,适合二分类问题

- 简单易于理解,直接看到各个特征的权重

- 能容易地更新模型吸收新的数据

Logistic缺点:

Logistic是个弱分类器,对数据和场景的适应能力有局限性,不如决策树算法学习能力那么强

2. Logistic回归为什么选择交叉熵作为损失函数,而非平方损失

可以从两个方面解释解释这个问题:

局部极小值方面

如果使用平方损失,那么Logistic的损失函数会出现较多局部极小值,这样在模型迭代过程中,容易陷入较差的局部极小值,不利于模型迭代。

而交叉熵损失函数在此问题上性质相对较好,具体可参考如下:

逻辑回归算法之交叉熵函数理解

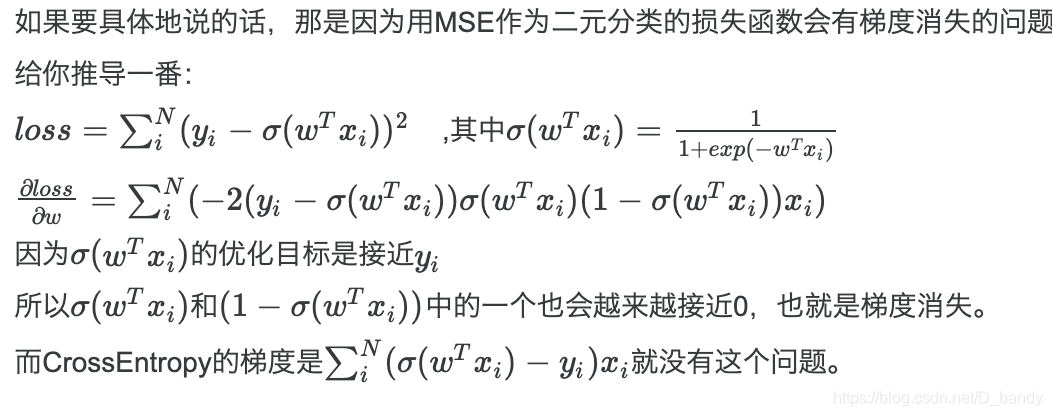

梯度消失方面

3. Logistic回归为什么选择使用sigmoid函数

- sigmoid函数将输入值挤压到[0,1]区间,比较适合分类问题

- sigmoid函数任意阶可导,并且一二阶导数不用求导,可以直接通过原sigmoid函数直接计算,性质优异,比较实用

- 广义模型推导所得

- 满足统计的最大熵模型

4. Logistic回归能做非线性分类吗

可以借助核技巧实现非线性分类,核技巧能将原始的线性输入空间映射为高维度非线性输入特征空间,就像SVM借助的高斯核。

5. Logistic回归为什么要对特征进行离散化

在工业界,很少直接将连续值作为特征喂给逻辑回归模型,而是将连续特征离散化为一系列0、1特征交给逻辑回归模型,这样做的优势有以下几点:

稀疏向量内积乘法运算速度快,计算结果方便存储,容易scalable(扩展)。

离散化后的特征对异常数据有很强的鲁棒性:比如一个特征是年龄>30是1,否则0。如果特征没有离散化,一个异常数据“年龄300岁”会给模型造成很大的干扰。

逻辑回归属于广义线性模型,表达能力受限;单变量离散化为N个后,每个变量有单独的权重,相当于为模型引入了非线性,能够提升模型表达能力,加大拟合。

离散化后可以进行特征交叉,由M+N个变量变为M*N个变量,进一步引入非线性,提升表达能力。

特征离散化后,模型会更稳定,比如如果对用户年龄离散化,20-30作为一个区间,不会因为一个用户年龄长了一岁就变成一个完全不同的人。当然处于区间相邻处的样本会刚好相反,所以怎么划分区间是门学问。

以上解释参考:逻辑回归LR的特征为什么要先离散化

版权声明:本文为D_bandy原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。