kubeadm搭建K8s+Flannel+Harbor的全过程

本文图文并茂地详细介绍了在CentOS7.6上,使用kubeadm工具搭建Kubernates集群v1.17.3,并集成Flannel、Harbor1.10.1的全过程。

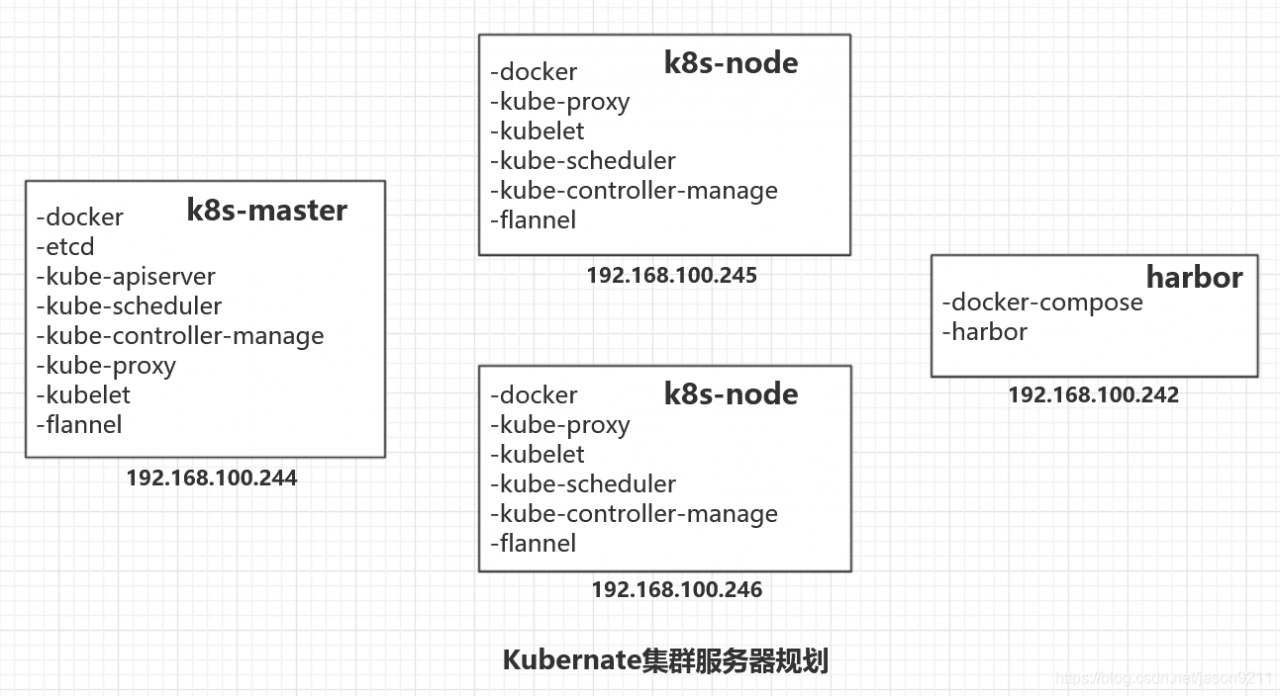

服务器规划

k8s-master:192.168.100.244

k8s-node:192.168.100.246

harbor:192.168.100.242

1. 前期准备

Master节点和Node节点都需要这些准备。

关闭防火墙:

systemctl stop firewalld #停止firewall

systemctl disable firewalld #禁止firewall开机启动

关闭SElinux:

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

关闭swap(k8s官方要求):

# 关闭swap

swapoff -a && sysctl -w vm.swappiness=0

# 取消开机挂载

sed -ri '/^[^#]*swap/s@^@#@' /etc/fstab

添加本地DNS:

vim /etc/hosts

#### kubernates ########

192.168.100.244 k8s-master

192.168.100.245 k8s-node2

192.168.100.246 k8s-node

时钟同步:

ntpdate ntp1.aliyun.com

1.1 安装docker

删除原先docker:

yum remove docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-engine

安装依赖:

yum update -y #根据需要进行更新

yum install -y yum-utils \

device-mapper-persistent-data \

lvm2

更换docker源:

# 添加阿里云的docker-ce源

wget -O /etc/yum.repos.d/docker-ce.repo \

https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# 查看当前所有yum源

ll /etc/yum.repos.d/

安装docker:

yum install -y docker-ce \

docker-ce-cli \

containerd.io

设置开机自启:

systemctl enable --now docker

1.2 修改docker cgroup驱动

创建 docker daemon 文件,进行配置,目的是将native.cgroupdriver由cgroupfs修改为systemd

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

]

}

EOF

重启生效:

systemctl daemon-reload

systemctl restart docker

1.3 更换kubernates源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 查看当前所有yum源

ll /etc/yum.repos.d/

1.4 安装kubelet kubeadm kubectl

先卸载旧版(如果需要):

yum remove \

kubelet \

kubeadm \

cri-tools \

kubectl

再安装v1.17.3版:

yum install -y kubelet-1.17.3-0 \

kubeadm-1.17.3-0 \

kubectl-1.17.3-0 \

--disableexcludes=kubernetes

如果想安装其他版本号,可以使用下面命令查看:

yum list kubeadm --showduplicates

安装这三个程序时,会自动下载的依赖包有:

conntrack-tools.x86_64 0:1.4.4-5.el7_7.2

cri-tools.x86_64 0:1.13.0-0

kubernetes-cni.x86_64 0:0.7.5-0

libnetfilter_cthelper.x86_64 0:1.0.0-10.el7_7.1

libnetfilter_cttimeout.x86_64 0:1.0.0-6.el7_7.1

libnetfilter_queue.x86_64 0:1.0.2-2.el7_2

socat.x86_64 0:1.7.3.2-2.el7

安装完成后,查看版本:

kubeadm version

kubectl version

kubelet --version

开机自启kubelet:

systemctl enable --now kubelet

1.5 设置路由

yum install -y bridge-utils.x86_64

加载br_netfilter模块:

modprobe br_netfilter

创建/etc/sysctl.d/k8s.conf文件:

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

其中net.bridge.bridge-nf-call-iptables = 1 将会使系统下 /proc/sys/net/bridge/bridge-nf-call-iptables的值为1,它会将桥接的IPv4流量传递给iptables的链。这也是包括flannel在内的很多CNI插件工作的前置要求。

使生效:

sysctl -p /etc/sysctl.d/k8s.conf

2. 配置Master和Node节点

2.1 Master节点拉取集群所需镜像

如果能够科学上网,可以直接执行:

kubeadm config images pull

无法科学上网时的替代方案,步骤是这样的:

- 列出kubeadm所需的image名称

- 找个docker镜像下载image

- 修改tag,改成与kubeadm所需名称一致

- 最后启动kubeadm进行安装

下面是具体步骤:

1、列出所需镜像:

kubeadm config images list

# 输出结果:(可以查看各个组件的版本)

k8s.gcr.io/kube-apiserver:v1.17.3

k8s.gcr.io/kube-controller-manager:v1.17.3

k8s.gcr.io/kube-scheduler:v1.17.3

k8s.gcr.io/kube-proxy:v1.17.3

k8s.gcr.io/pause:3.1

k8s.gcr.io/etcd:3.4.3-0

k8s.gcr.io/coredns:1.6.5

2、根据所需镜像名字先拉取国内资源:

docker pull gotok8s/kube-apiserver:v1.17.3

docker pull gotok8s/kube-controller-manager:v1.17.3

docker pull gotok8s/kube-scheduler:v1.17.3

docker pull gotok8s/kube-proxy:v1.17.3

docker pull gotok8s/pause:3.1

docker pull gotok8s/etcd:3.4.3-0

docker pull coredns/coredns:1.6.5

根据网络情况,这一步骤可能需要很长时间。

3、修改tag:

docker tag gotok8s/kube-apiserver:v1.17.3 \

k8s.gcr.io/kube-apiserver:v1.17.3

docker tag gotok8s/kube-controller-manager:v1.17.3 \

k8s.gcr.io/kube-controller-manager:v1.17.3

docker tag gotok8s/kube-scheduler:v1.17.3 \

k8s.gcr.io/kube-scheduler:v1.17.3

docker tag gotok8s/kube-proxy:v1.17.3 \

k8s.gcr.io/kube-proxy:v1.17.3

docker tag gotok8s/pause:3.1 \

k8s.gcr.io/pause:3.1

docker tag gotok8s/etcd:3.4.3-0 \

k8s.gcr.io/etcd:3.4.3-0

docker tag coredns/coredns:1.6.5 \

k8s.gcr.io/coredns:1.6.5

4、删除原来镜像:

docker rmi gotok8s/kube-apiserver:v1.17.3 &&

docker rmi gotok8s/kube-controller-manager:v1.17.3 &&

docker rmi gotok8s/kube-scheduler:v1.17.3 &&

docker rmi gotok8s/kube-proxy:v1.17.3 &&

docker rmi gotok8s/pause:3.1 &&

docker rmi gotok8s/etcd:3.4.3-0 &&

docker rmi coredns/coredns:1.6.5

5、备份镜像(根据需要):

通过docker自带的镜像导入导出功能,可以方便地将一个node节点上镜像导出==>拷贝==>导入到其他node节点的docker中。这样不用每个节点都下载一遍。

如果使用Harbor的话,可以push到Harbor中去,再由各节点的docker客户端从Harbor拉取即可。

下面先来看docker导入导出方式:

docker save 导出:

mkdir -p /home/k8s/docker-images-backup/k8s.gcr.io/

cd /home/k8s/docker-images-backup/k8s.gcr.io/

docker save k8s.gcr.io/kube-apiserver:v1.17.3 -o ./kube-apiserver-v1.17.3.tar

docker save k8s.gcr.io/kube-controller-manager:v1.17.3 -o ./kube-controller-manager-v1.17.3.tar

docker save k8s.gcr.io/kube-scheduler:v1.17.3 -o ./kube-scheduler-v1.17.3.tar

docker save k8s.gcr.io/kube-proxy:v1.17.3 -o ./kube-proxy-v1.17.3.tar

docker save k8s.gcr.io/pause:3.1 -o ./pause-3.1.tar

docker save k8s.gcr.io/etcd:3.4.3-0 -o ./etcd-3.4.3-0.tar

docker save k8s.gcr.io/coredns:1.6.5 -o ./coredns-1.6.5.tar

docker load 导入:

cd /home/k8s/docker-images-backup/k8s.gcr.io/

docker load -i ./kube-apiserver-v1.17.3.tar

docker load -i ./kube-controller-manager-v1.17.3.tar

docker load -i ./kube-scheduler-v1.17.3.tar

docker load -i ./kube-proxy-v1.17.3.tar

docker load -i ./pause-3.1.tar

docker load -i ./etcd-3.4.3-0.tar

docker load -i ./coredns-1.6.5.tar

2.2 各Node节点拉取所需镜像

步骤与《2.1 Master节点拉取集群所需镜像》相同。

3. 创建集群

使用kubeadm创建集群,这是在Master节点中需要执行的:

3.1、初始化集群并保存token

# –apiserver-advertise-address - 是你本机的ip地址

# –pod-network-cidr - 指定pod网络子网。

# 如果是flannel,官网要求设为10.244.0.0/16

# 如果是catico,官网要求设为192.168.0.0/16

kubeadm init \

--apiserver-advertise-address 192.168.100.244 \

--pod-network-cidr 10.244.0.0/16

创建成功后会提示你成功,这时要记录token,我们后面将其他节点加入到该集群中需要使用到它。这个token信息非常重要。

注意 :如果安装时出现

Error writing Crisocket information for the control-plane node: timed out waiting for the condition

则重启 kubeadm:

sudo kubeadm reset

然后再执行init命令。

从kubeadm安装时的提示信息中,我们知道还需要做以下步骤:

3.2、设置权限

下面的命令是配置常规用户如何使用kubectl(客户端)访问集群,因为master节点也需要使用kubectl访问集群,所以也需要运行以下命令(建议一步步执行):

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

3.3、安装Pod Network(我安装的是Flannel)

可以查看官网的要求:

https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/create-cluster-kubeadm/

我这里安装的是flannel network add-on

安装命令:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 输出如下:

podsecuritypolicy.policy/psp.flannel.unprivileged created

clusterrole.rbac.authorization.k8s.io/flannel created

clusterrolebinding.rbac.authorization.k8s.io/flannel created

serviceaccount/flannel created

configmap/kube-flannel-cfg created

daemonset.apps/kube-flannel-ds-amd64 created

daemonset.apps/kube-flannel-ds-arm64 created

daemonset.apps/kube-flannel-ds-arm created

daemonset.apps/kube-flannel-ds-ppc64le created

daemonset.apps/kube-flannel-ds-s390x created

确保您的防火墙规则允许UDP端口8285和8472与所有参加overlay网络的主机通信。

更多关于flannel的信息可以参考:https://github.com/coreos/flannel

4. Node节点加入集群

这句话其实就是Master节点执行kubeadm init成功之后输出的最后一句话,我们拿到Node节点中直接执行即可。

kubeadm join 192.168.100.244:6443 --token 5biv...wdnf \

--discovery-token-ca-cert-hash sha256:4ee34f...d0bce8

当看到下面信息,就说明成功加入集群了。

...

This node has joined the cluster:

...

下面在master节点上执行命令查看集群中的节点:

kubectl get nodes

如果node节点是NotReady,可以使用命令检查是否有报错:

systemctl status -l kubelet.service

注意node节点也要安装flannel。

5. 常见问题

1、集群初始化如果遇到问题,可以使用下面的命令进行清理再重新初始化:

kubeadm reset

ifconfig cni0 down

ip link delete cni0

ifconfig flannel.1 down

ip link delete flannel.1

rm -rf /var/lib/cni/

2、如何从集群中移除Node

假设要移除的节点hostname为k8s-node:

在master节点上执行:

kubectl drain k8s-node --delete-local-data --force --ignore-daemonsets

kubectl delete node k8s-node

在node节点上执行:

kubeadm reset

ifconfig cni0 down

ip link delete cni0

ifconfig flannel.1 down

ip link delete flannel.1

rm -rf /var/lib/cni/

6. 查看节点状态

回到Maser节点,运行下面命令:

# 获取namespace信息

kubectl get namespace

# 查看pod状态

kubectl get pods --all-namespaces

# 查看有多少个节点

kubectl get nodes

查看kubelet进程日志:

journalctl -f -u kubelet

查看所有的token:

kubeadm token list

创建新的token:

kubeadm token create

============================ 我是一条华丽丽的分割线 ============================

如果希望向Kubernates集群中集成Harbor,那么请继续看接下来的内容。

7、安装Harbor

首先是要在k8s集群外的一台主机上安装Harbor,作为云仓库管理docker镜像。安装过程请参考:《CentOS安装Harbor1.10.1并与docker集成 》

然后,在Kubernates中增加secret,用于Harbor认证。

8、Kubernates集成Harbor

Step1、docker login 登录Harbor:

docker login -uharbor-dev -pHarbordev123 harbor.cn

执行命令查看登录状态:

[root@dev ~]# cat ~/.docker/config.json

{

"auths": {

"harbor.cn": {

"auth": "Y2N4...MjM="

}

}

}

Step2、生成秘钥(secret),命名为secret-harbor-dev:

# 参数说明:

# secret-harbor-dev - 这是密钥的键名称, 可自行定义

# --docker-server - 指定docker仓库地址

# --docker-username - 指定docker仓库账号

# --docker-password - 指定docker仓库密码

# -n - 指定namespace,默认为default

kubectl create secret docker-registry secret-harbor-dev \

--docker-server=harbor.cn \

--docker-username=harbor-dev \

--docker-password=Harbordev123

Step3、查看秘钥:

[root@dev244 ~]# kubectl get secret

NAME TYPE DATA AGE

secret-harbor-dev kubernetes.io/dockerconfigjson 1 22s

Step4、yaml文件中通过imagePullSecrets指定拉取镜像操作使用的秘钥:

# imagePullSecrets - 声明拉取镜像时需要指定密钥,值为密钥的名称

# 另外需要注意当前资源的namespace必须与密钥的namespace一致

imagePullSecrets:

- name: secret-harbor-dev

在定义Deployment的yaml文件中,要注意参数层级,应设置在spec.template.spec.imagePullSecrets。

这样,在执行yaml文件时,node节点上的docker就可以使用secret-harbor-dev通过Harbor认证,从Harbor拉取镜像了。