正则化

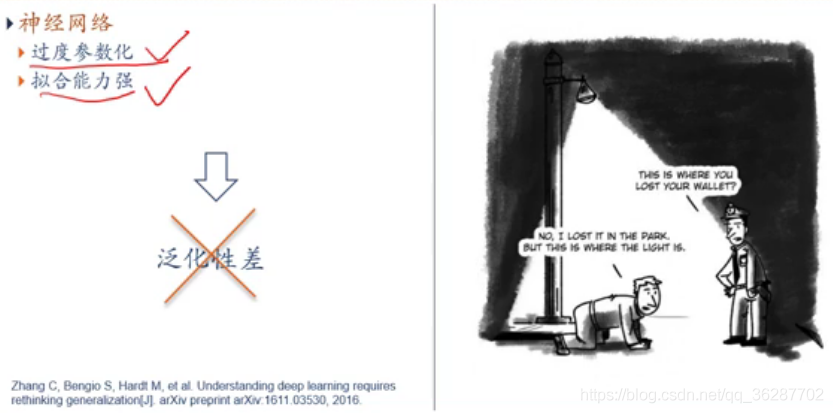

思考泛化性:重新思考模型复杂度和泛化之间的关系

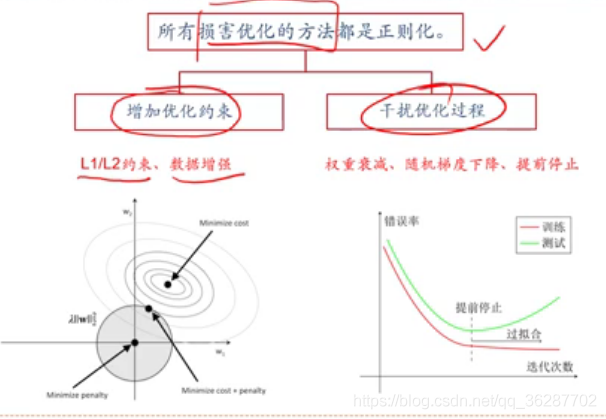

所有损害优化的方法都是正则化

正则化方法:

δ1和δ2的正则化

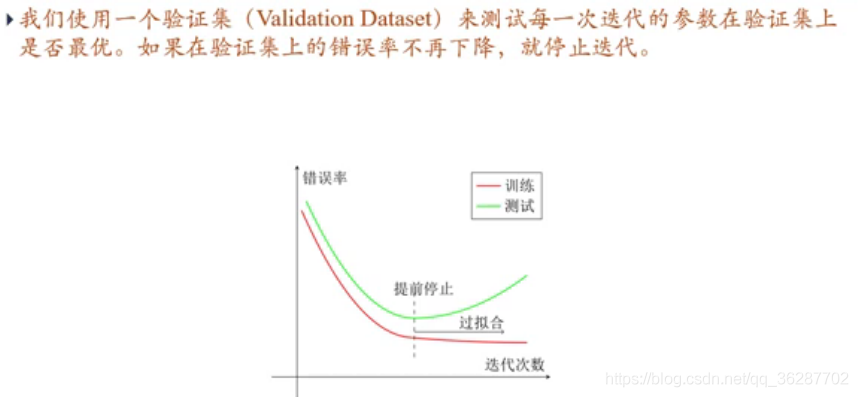

提前停止:

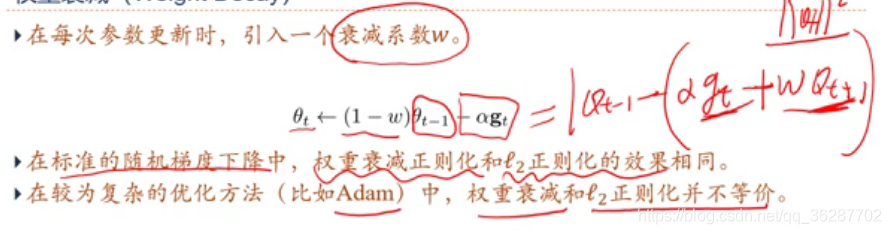

权重衰减:

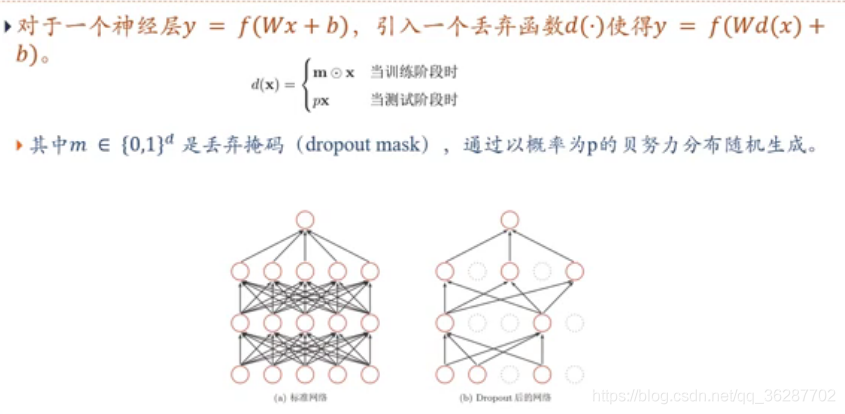

丢弃法:Dropout

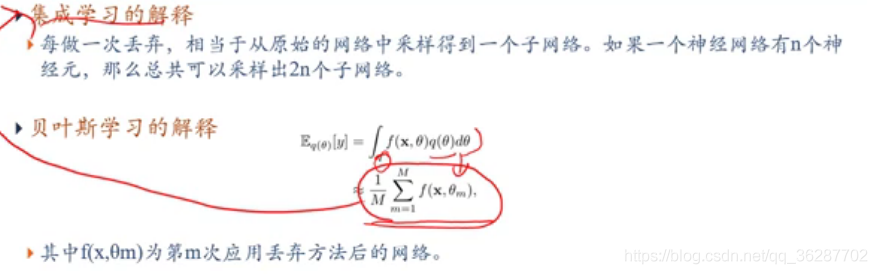

Dropout意义:

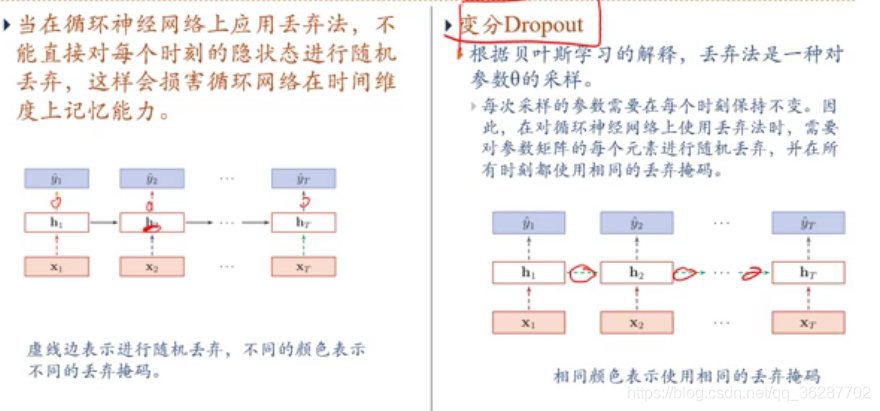

循环神经网络上的丢弃法:要丢都丢

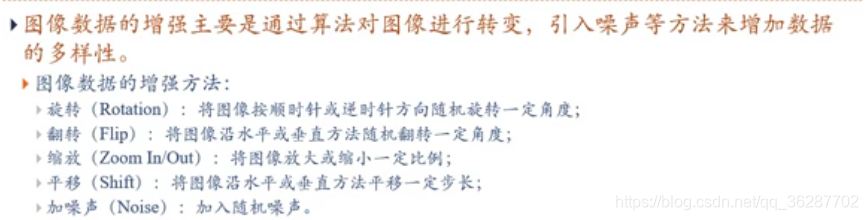

数据增强:

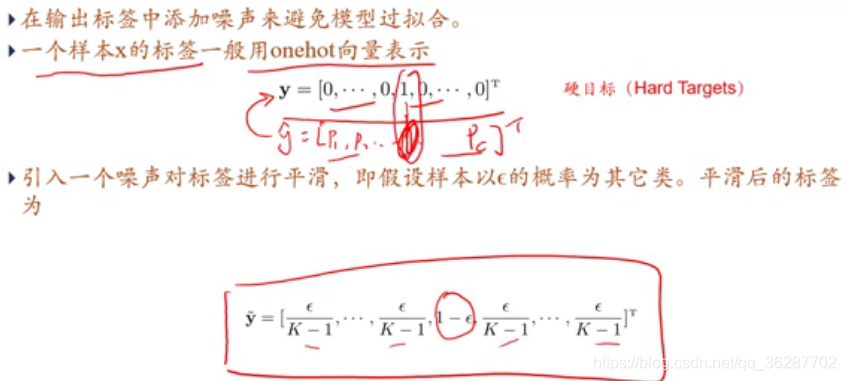

标签平滑:

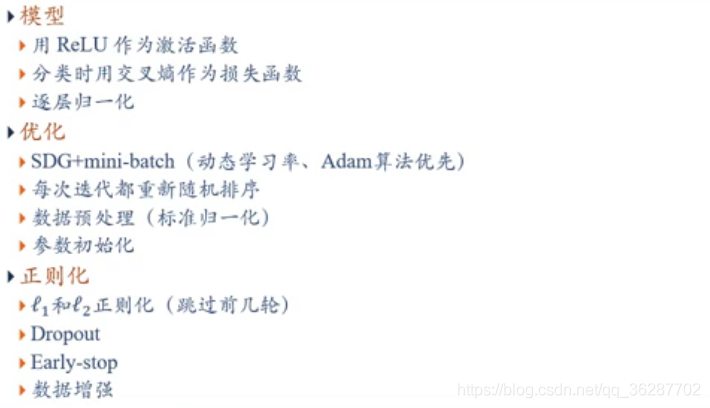

总结:

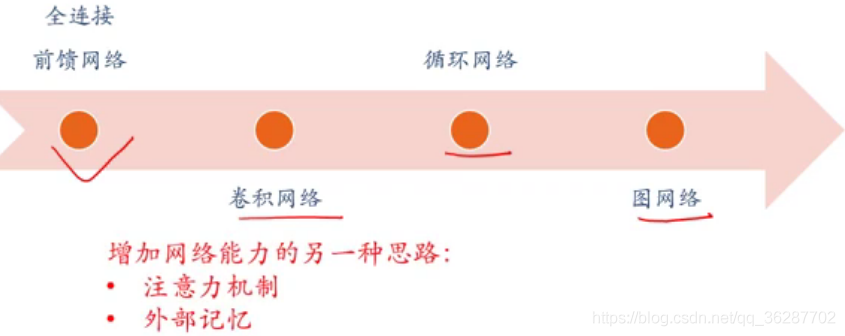

注意力机制和外部记忆1

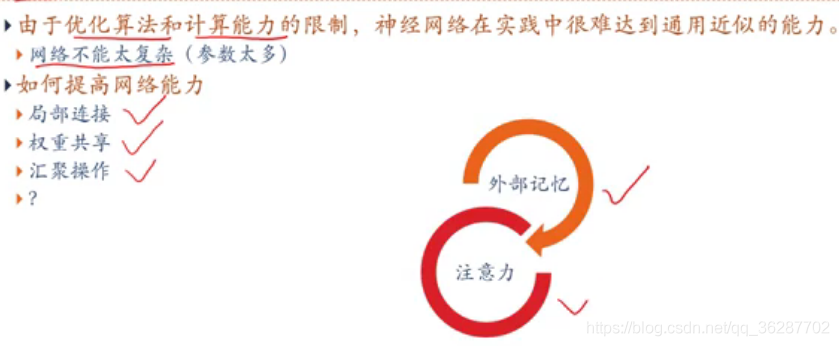

网络能力

注意力机制:

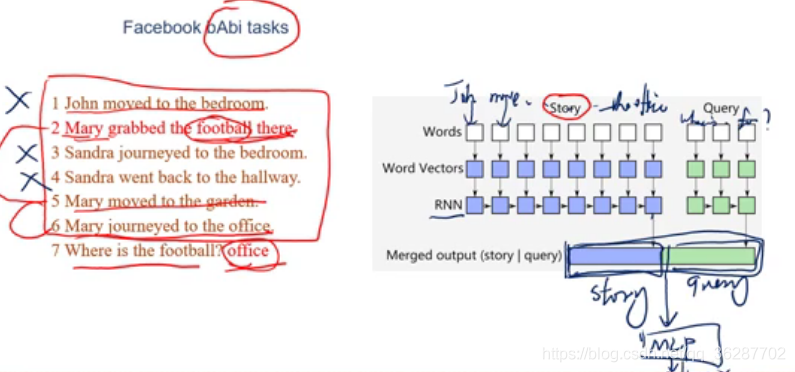

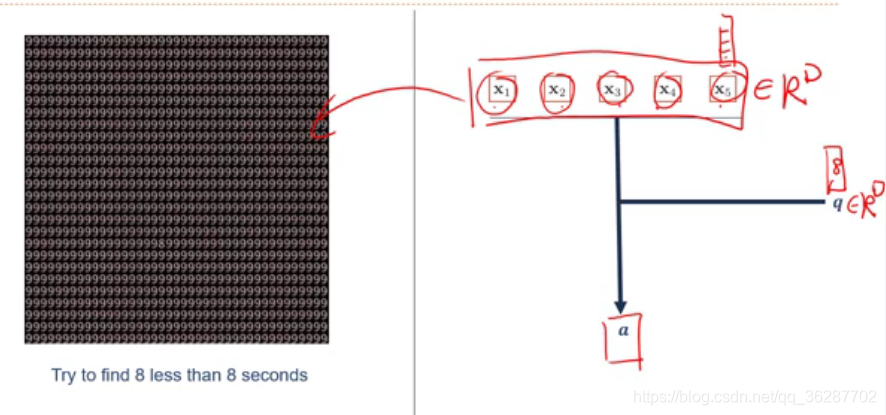

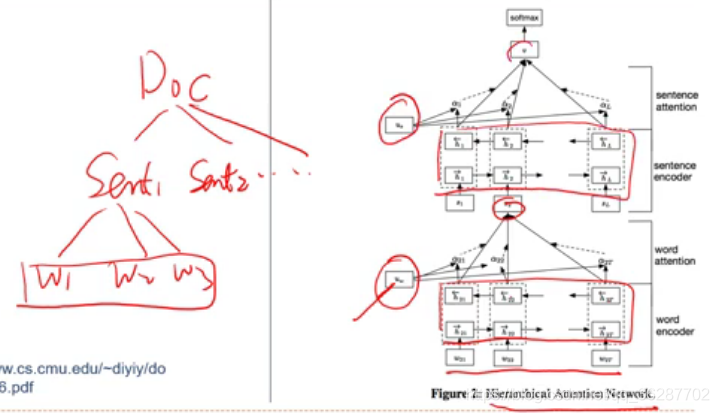

例子:阅读理解 传统RNN会出问题 :1.长程依赖问题2.模型容量问题

通用近似定理

大脑中的注意力:

如何实现?

人工神经网络中的注意力机制

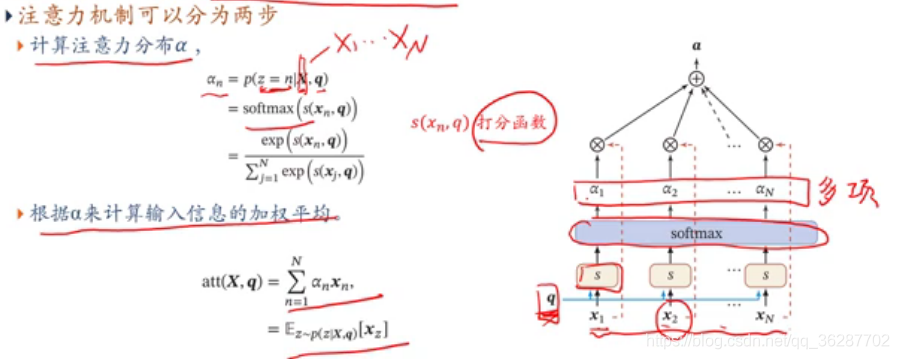

注意力模型:软性注意力机制 soft attention mechanism

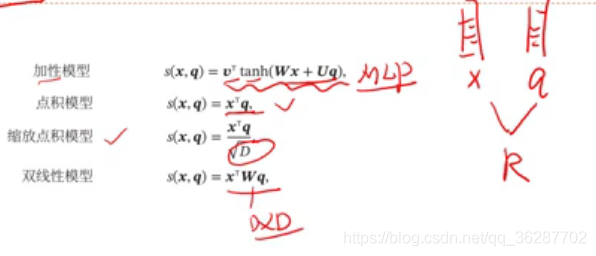

注意力打分函数: 双线性模型 带方向 但是 缩放点击模型不带方向

一些常见的注意力

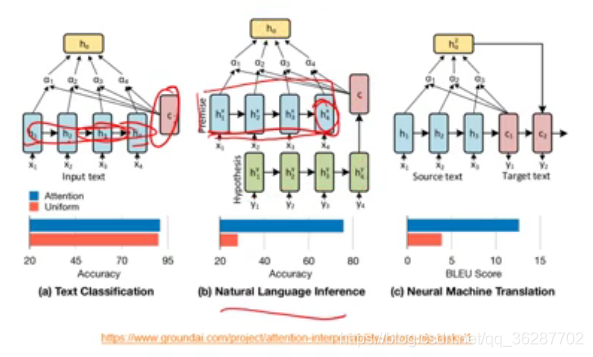

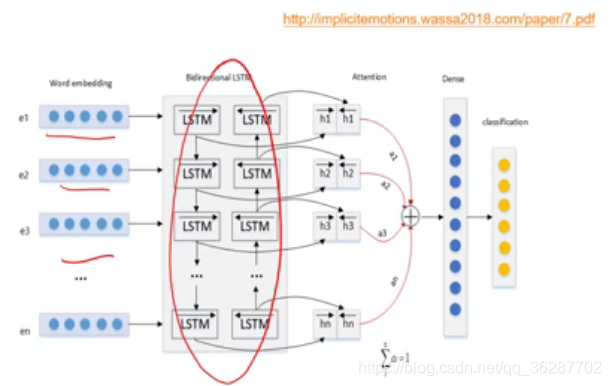

注意力模型 :文本分类

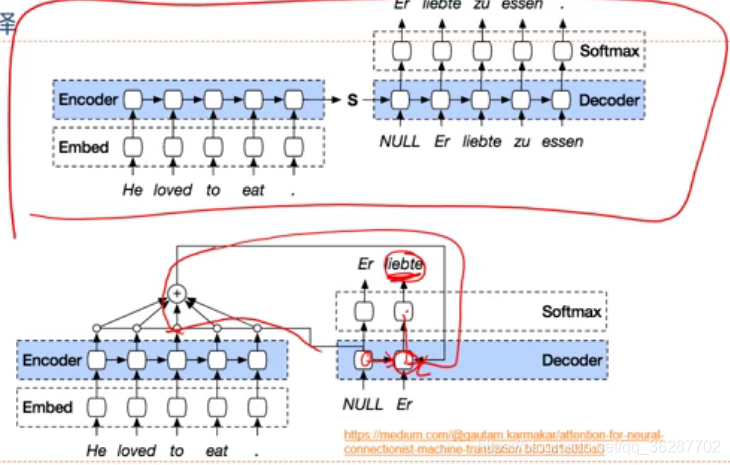

机器翻译:

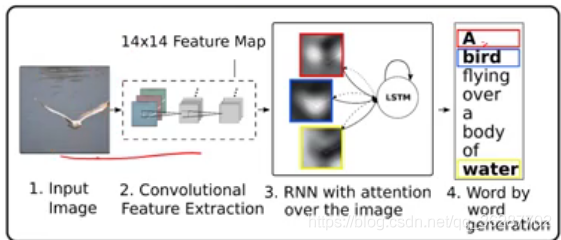

image caption

版权声明:本文为qq_36287702原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。