SeLU

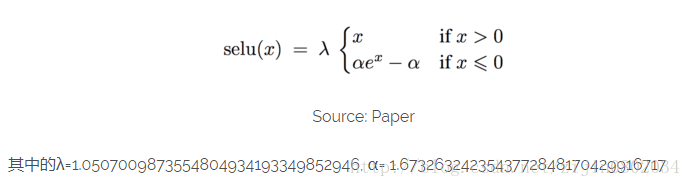

最近arXiv出来一篇新文章,102页的Paper,90+页的附录,密密麻麻的公式证明,已经和我暂时绝缘了, 心疼审稿人1秒。虽然看不懂,并不影响我们使用,总结起来就是下图:

代码放到Tensorflow里面就下面几行:

def selu(x):

with ops.name_scope('elu') as scope:

alpha = 1.6732632423543772848170429916717

scale = 1.0507009873554804934193349852946

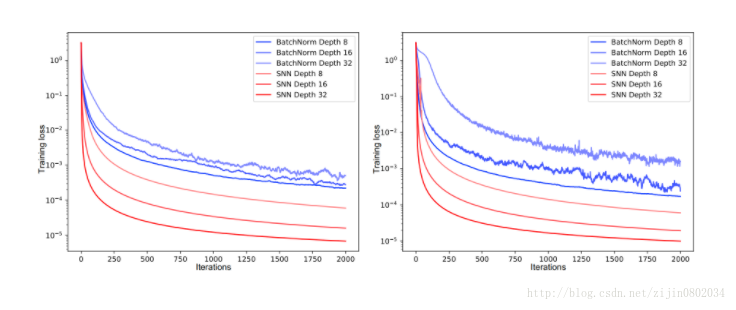

return scale*tf.where(x>=0.0, x, alpha*tf.nn.elu(x))效果比Batch Normalization 要好:

github 代码地址

Paper 原文

推导α,λ的过程 地址

版权声明:本文为zijin0802034原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明。