Bounding Box Regression with Uncertainty for Accurate Object Detection

(CVPR2019, 旷视)

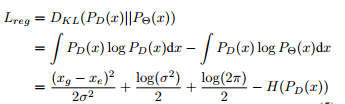

该论文是旷视2019年提出的,主要是使目标边框更加清晰,提升定位精度,提出了一种新的边界框回归损失,同时完成边界框变换和定位差异。在目标检测数据集中,ground-truth边界框在一些情况下存在固有的不确定性。 如下图所示,目标框(a)(c)标注不确定性,(b) 遮挡带来不确定性。(d) 目标自身边界是不确定的。由于树的遮挡,火车的左边界是不清晰的。大尺度目标检测数据集,如ImageNet、MS-COCO、CrowdHuman,都会尽量把边界框标清晰。但是边界框在有些情况下会不可避免的存在不确定性。不确定性会使标注和边界框回归函数的学习变得困难。

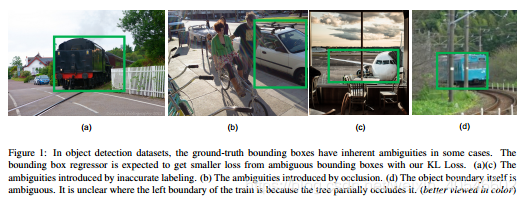

传统的边界框回归损失(如smooth L1 loss)并没有将边界框的不确定性考虑进去。而且边界框回归当分类分数很高的情况下被假定是准确的,但事实并不总是这样。如下图所示,两个框都是不准的,但分类分数高的边界框反而是错误的。

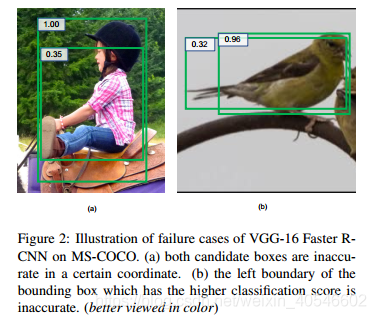

KL Loss旨在同时学习边界框回归和定位不确定性,定义了预测分布和真实分布的KL散度。采用KL Loss学习有三个好处:(1) 数据集中的不确定性可以被很好的捕获到,边界框回归器会从不确定边界框中计算出更小的损失;(2) 学习到的方差在后处理阶段非常有用,提出方差投票(var voting),在NMS阶段使用预测方差来加权候选框相邻的位置,最后得到投票出候选框的最终定位。(3) 学到的概率分布是可解释的,因为它反映了边界框预测的不确定度,可以对自动驾驶和机器人上的应用有潜在的帮助。

KL loss的提出,不光考虑单个预测框的正确性,而是对于N个样本的KL散度最小化。损失函数如下,

![]()